12 KiB

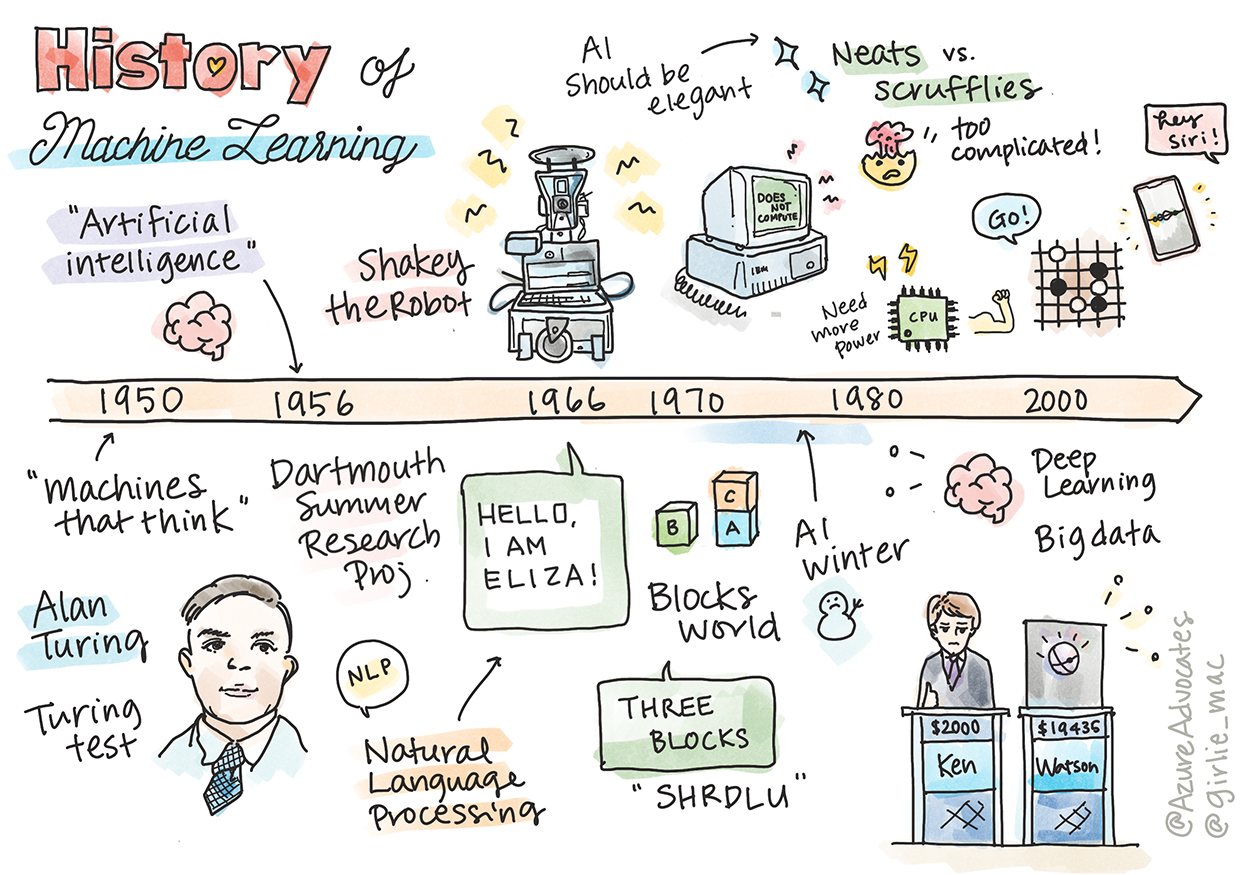

Sejarah pembelajaran mesin

Sketchnote oleh Tomomi Imura

Kuiz pra-pelajaran

🎥 Klik imej di atas untuk video pendek yang menerangkan pelajaran ini.

Dalam pelajaran ini, kita akan melalui pencapaian utama dalam sejarah pembelajaran mesin dan kecerdasan buatan.

Sejarah kecerdasan buatan (AI) sebagai satu bidang berkait rapat dengan sejarah pembelajaran mesin, kerana algoritma dan kemajuan pengiraan yang mendasari ML menyumbang kepada pembangunan AI. Adalah berguna untuk diingat bahawa, walaupun bidang ini sebagai kawasan penyelidikan yang berbeza mula terbentuk pada tahun 1950-an, penemuan algoritma, statistik, matematik, pengiraan dan teknikal yang penting telah mendahului dan bertindih dengan era ini. Malah, manusia telah memikirkan persoalan ini selama ratusan tahun: artikel ini membincangkan asas intelektual sejarah idea 'mesin yang berfikir.'

Penemuan penting

- 1763, 1812 Teorem Bayes dan pendahulunya. Teorem ini dan aplikasinya mendasari inferens, menerangkan kebarangkalian sesuatu peristiwa berlaku berdasarkan pengetahuan sebelumnya.

- 1805 Teori Kuadrat Terkecil oleh ahli matematik Perancis Adrien-Marie Legendre. Teori ini, yang akan anda pelajari dalam unit Regresi kami, membantu dalam penyesuaian data.

- 1913 Rantai Markov, dinamakan sempena ahli matematik Rusia Andrey Markov, digunakan untuk menerangkan urutan peristiwa yang mungkin berlaku berdasarkan keadaan sebelumnya.

- 1957 Perceptron ialah sejenis pengklasifikasi linear yang dicipta oleh ahli psikologi Amerika Frank Rosenblatt yang mendasari kemajuan dalam pembelajaran mendalam.

- 1967 Jiran Terdekat ialah algoritma yang pada asalnya direka untuk memetakan laluan. Dalam konteks ML, ia digunakan untuk mengesan corak.

- 1970 Backpropagation digunakan untuk melatih rangkaian neural feedforward.

- 1982 Rangkaian Neural Berulang ialah rangkaian neural tiruan yang berasal daripada rangkaian neural feedforward yang mencipta graf temporal.

✅ Lakukan sedikit penyelidikan. Apakah tarikh lain yang menonjol sebagai titik penting dalam sejarah ML dan AI?

1950: Mesin yang berfikir

Alan Turing, seorang individu yang benar-benar luar biasa yang telah diundi oleh orang awam pada tahun 2019 sebagai saintis terhebat abad ke-20, dikreditkan sebagai membantu meletakkan asas untuk konsep 'mesin yang boleh berfikir.' Beliau bergelut dengan skeptik dan keperluannya sendiri untuk bukti empirik tentang konsep ini sebahagiannya dengan mencipta Ujian Turing, yang akan anda terokai dalam pelajaran NLP kami.

1956: Projek Penyelidikan Musim Panas Dartmouth

"Projek Penyelidikan Musim Panas Dartmouth mengenai kecerdasan buatan adalah acara penting untuk kecerdasan buatan sebagai satu bidang," dan di sinilah istilah 'kecerdasan buatan' dicipta (sumber).

Setiap aspek pembelajaran atau mana-mana ciri kecerdasan boleh pada prinsipnya diterangkan dengan begitu tepat sehingga mesin boleh dibuat untuk mensimulasikannya.

Penyelidik utama, profesor matematik John McCarthy, berharap "untuk meneruskan berdasarkan andaian bahawa setiap aspek pembelajaran atau mana-mana ciri kecerdasan boleh pada prinsipnya diterangkan dengan begitu tepat sehingga mesin boleh dibuat untuk mensimulasikannya." Para peserta termasuk seorang lagi tokoh terkenal dalam bidang ini, Marvin Minsky.

Bengkel ini dikreditkan dengan memulakan dan menggalakkan beberapa perbincangan termasuk "kemunculan kaedah simbolik, sistem yang tertumpu pada domain terhad (sistem pakar awal), dan sistem deduktif berbanding sistem induktif." (sumber).

1956 - 1974: "Tahun-tahun emas"

Dari tahun 1950-an hingga pertengahan '70-an, optimisme tinggi dalam harapan bahawa AI boleh menyelesaikan banyak masalah. Pada tahun 1967, Marvin Minsky menyatakan dengan yakin bahawa "Dalam satu generasi ... masalah mencipta 'kecerdasan buatan' akan diselesaikan secara substansial." (Minsky, Marvin (1967), Computation: Finite and Infinite Machines, Englewood Cliffs, N.J.: Prentice-Hall)

Penyelidikan pemprosesan bahasa semula jadi berkembang pesat, carian diperhalusi dan menjadi lebih berkuasa, dan konsep 'dunia mikro' dicipta, di mana tugas mudah diselesaikan menggunakan arahan bahasa biasa.

Penyelidikan dibiayai dengan baik oleh agensi kerajaan, kemajuan dibuat dalam pengiraan dan algoritma, dan prototaip mesin pintar dibina. Beberapa mesin ini termasuk:

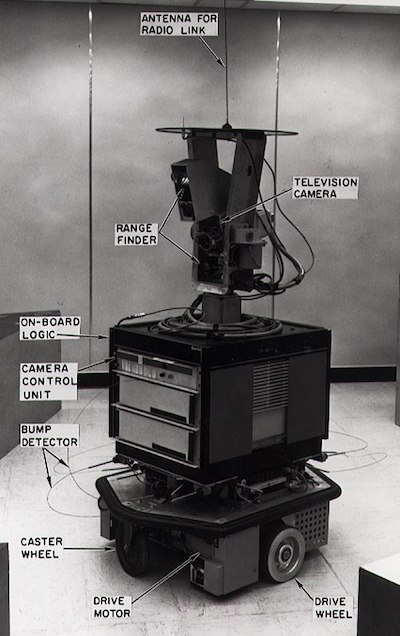

-

Shakey the robot, yang boleh bergerak dan memutuskan cara melaksanakan tugas secara 'bijak'.

Shakey pada tahun 1972

-

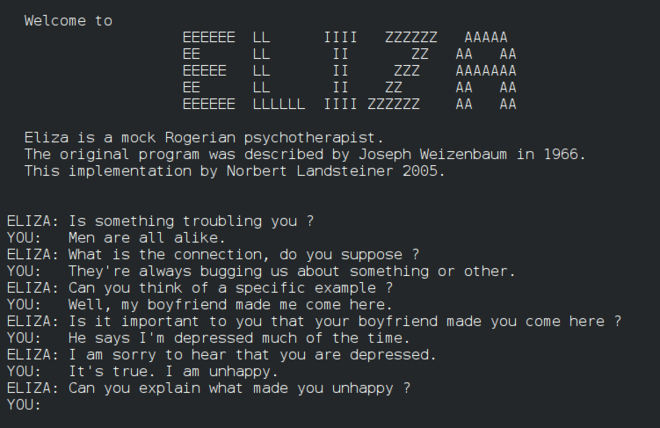

Eliza, 'chatterbot' awal, boleh berbual dengan orang dan bertindak sebagai 'terapis' primitif. Anda akan belajar lebih lanjut tentang Eliza dalam pelajaran NLP.

Versi Eliza, chatbot

-

"Blocks world" adalah contoh dunia mikro di mana blok boleh disusun dan diatur, dan eksperimen dalam mengajar mesin untuk membuat keputusan boleh diuji. Kemajuan yang dibina dengan perpustakaan seperti SHRDLU membantu memacu pemprosesan bahasa ke hadapan.

🎥 Klik imej di atas untuk video: Blocks world dengan SHRDLU

1974 - 1980: "Musim sejuk AI"

Menjelang pertengahan tahun 1970-an, menjadi jelas bahawa kerumitan membuat 'mesin pintar' telah diremehkan dan janji yang diberikan, memandangkan kuasa pengiraan yang tersedia, telah dibesar-besarkan. Pembiayaan terhenti dan keyakinan dalam bidang ini perlahan. Beberapa isu yang menjejaskan keyakinan termasuk:

- Keterbatasan. Kuasa pengiraan terlalu terhad.

- Letupan kombinatorial. Jumlah parameter yang perlu dilatih meningkat secara eksponen apabila lebih banyak diminta daripada komputer, tanpa evolusi selari kuasa dan keupayaan pengiraan.

- Kekurangan data. Kekurangan data menghalang proses pengujian, pembangunan, dan penambahbaikan algoritma.

- Adakah kita bertanya soalan yang betul?. Soalan yang diajukan mula dipersoalkan. Penyelidik mula menghadapi kritikan tentang pendekatan mereka:

- Ujian Turing dipersoalkan melalui, antara lain, teori 'bilik Cina' yang menyatakan bahawa, "memprogram komputer digital mungkin membuatnya kelihatan memahami bahasa tetapi tidak dapat menghasilkan pemahaman sebenar." (sumber)

- Etika memperkenalkan kecerdasan buatan seperti "terapis" ELIZA ke dalam masyarakat dicabar.

Pada masa yang sama, pelbagai aliran pemikiran AI mula terbentuk. Satu dikotomi ditubuhkan antara amalan "AI scruffy" vs. "AI neat". Makmal scruffy menyesuaikan program selama berjam-jam sehingga mereka mendapat hasil yang diinginkan. Makmal neat "fokus pada logik dan penyelesaian masalah formal". ELIZA dan SHRDLU adalah sistem scruffy yang terkenal. Pada tahun 1980-an, apabila permintaan muncul untuk menjadikan sistem ML boleh dihasilkan semula, pendekatan neat secara beransur-ansur mengambil tempat utama kerana hasilnya lebih boleh dijelaskan.

Sistem pakar tahun 1980-an

Apabila bidang ini berkembang, manfaatnya kepada perniagaan menjadi lebih jelas, dan pada tahun 1980-an begitu juga dengan penyebaran 'sistem pakar'. "Sistem pakar adalah antara bentuk perisian kecerdasan buatan (AI) yang pertama benar-benar berjaya." (sumber).

Jenis sistem ini sebenarnya hibrid, terdiri daripada enjin peraturan yang mentakrifkan keperluan perniagaan, dan enjin inferens yang memanfaatkan sistem peraturan untuk membuat deduksi fakta baharu.

Era ini juga menyaksikan perhatian yang semakin meningkat terhadap rangkaian neural.

1987 - 1993: 'Kedinginan' AI

Penyebaran perkakasan sistem pakar khusus mempunyai kesan malang menjadi terlalu khusus. Kebangkitan komputer peribadi juga bersaing dengan sistem besar, khusus, berpusat ini. Demokratisasi pengkomputeran telah bermula, dan akhirnya membuka jalan untuk letupan moden data besar.

1993 - 2011

Era ini menyaksikan zaman baharu untuk ML dan AI untuk dapat menyelesaikan beberapa masalah yang telah disebabkan sebelum ini oleh kekurangan data dan kuasa pengiraan. Jumlah data mula meningkat dengan pesat dan menjadi lebih mudah diakses, baik dan buruk, terutamanya dengan kemunculan telefon pintar sekitar tahun 2007. Kuasa pengiraan berkembang secara eksponen, dan algoritma berkembang seiring. Bidang ini mula mencapai kematangan apabila zaman bebas masa lalu mula mengkristal menjadi satu disiplin yang sebenar.

Kini

Hari ini pembelajaran mesin dan AI menyentuh hampir setiap bahagian kehidupan kita. Era ini memerlukan pemahaman yang teliti tentang risiko dan kesan berpotensi algoritma ini terhadap kehidupan manusia. Seperti yang dinyatakan oleh Brad Smith dari Microsoft, "Teknologi maklumat menimbulkan isu yang menyentuh inti perlindungan hak asasi manusia seperti privasi dan kebebasan bersuara. Isu-isu ini meningkatkan tanggungjawab syarikat teknologi yang mencipta produk ini. Pada pandangan kami, ia juga memerlukan peraturan kerajaan yang bijak dan pembangunan norma tentang penggunaan yang boleh diterima" (sumber).

Masih belum dapat dipastikan apa yang akan berlaku pada masa depan, tetapi adalah penting untuk memahami sistem komputer ini serta perisian dan algoritma yang mereka jalankan. Kami berharap kurikulum ini akan membantu anda mendapatkan pemahaman yang lebih baik supaya anda boleh membuat keputusan sendiri.

🎥 Klik imej di atas untuk video: Yann LeCun membincangkan sejarah pembelajaran mendalam dalam kuliah ini

🚀Cabaran

Selidiki salah satu momen sejarah ini dan pelajari lebih lanjut tentang orang di sebaliknya. Terdapat watak-watak yang menarik, dan tiada penemuan saintifik yang pernah dicipta dalam vakum budaya. Apa yang anda temui?

Kuiz selepas pelajaran

Ulasan & Kajian Kendiri

Berikut adalah item untuk ditonton dan didengar:

Podcast ini di mana Amy Boyd membincangkan evolusi AI

Tugasan

Penafian:

Dokumen ini telah diterjemahkan menggunakan perkhidmatan terjemahan AI Co-op Translator. Walaupun kami berusaha untuk memastikan ketepatan, sila ambil perhatian bahawa terjemahan automatik mungkin mengandungi kesilapan atau ketidaktepatan. Dokumen asal dalam bahasa asalnya harus dianggap sebagai sumber yang berwibawa. Untuk maklumat yang kritikal, terjemahan manusia profesional adalah disyorkan. Kami tidak bertanggungjawab atas sebarang salah faham atau salah tafsir yang timbul daripada penggunaan terjemahan ini.