32 KiB

การสร้างโซลูชัน Machine Learning ด้วย AI ที่มีความรับผิดชอบ

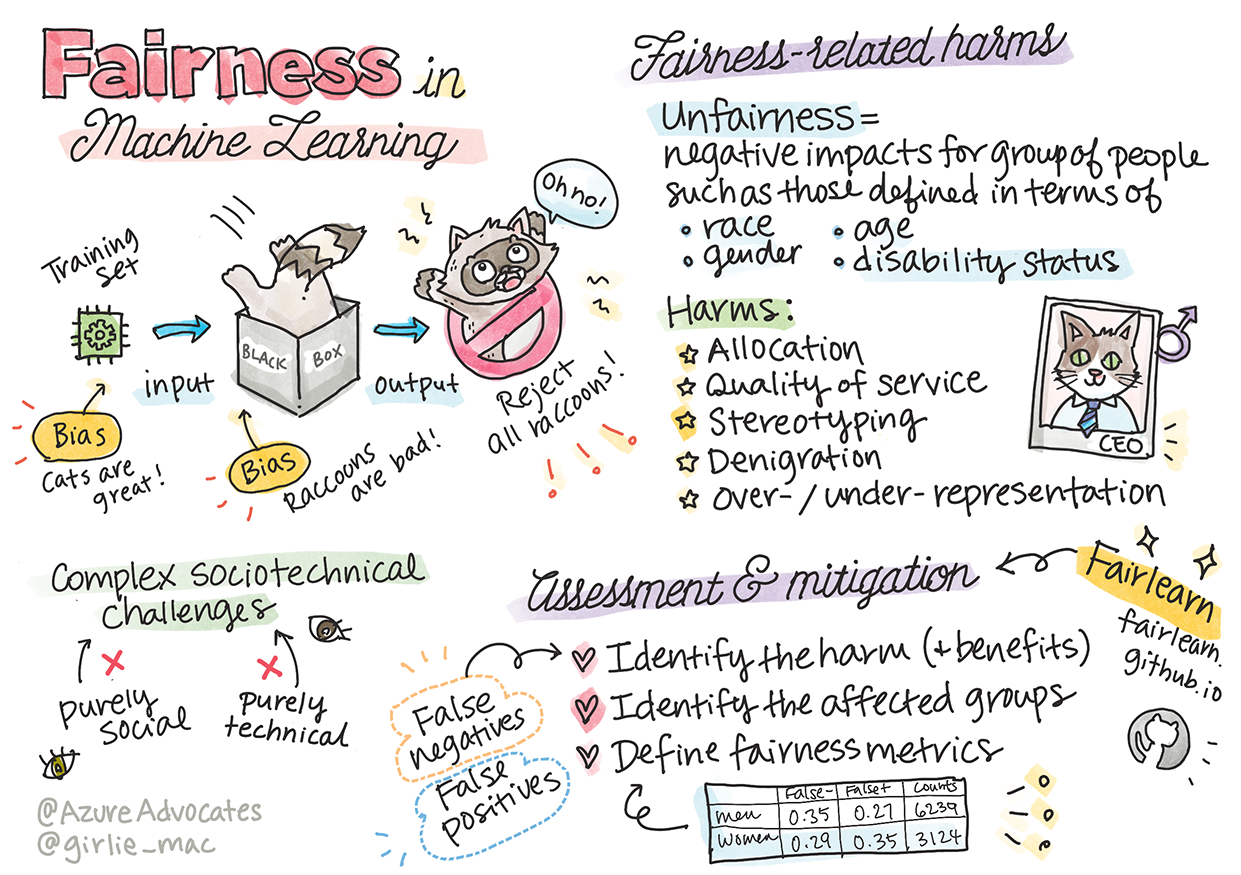

ภาพวาดโดย Tomomi Imura

แบบทดสอบก่อนเรียน

บทนำ

ในหลักสูตรนี้ คุณจะเริ่มค้นพบว่า Machine Learning มีผลกระทบต่อชีวิตประจำวันของเราอย่างไร แม้ในปัจจุบัน ระบบและโมเดลต่าง ๆ มีบทบาทในงานตัดสินใจประจำวัน เช่น การวินิจฉัยทางการแพทย์ การอนุมัติสินเชื่อ หรือการตรวจจับการฉ้อโกง ดังนั้นจึงเป็นสิ่งสำคัญที่โมเดลเหล่านี้จะต้องทำงานได้ดีเพื่อให้ผลลัพธ์ที่น่าเชื่อถือ เช่นเดียวกับแอปพลิเคชันซอฟต์แวร์ใด ๆ ระบบ AI อาจไม่เป็นไปตามความคาดหวังหรือมีผลลัพธ์ที่ไม่พึงประสงค์ นั่นคือเหตุผลที่เราต้องสามารถเข้าใจและอธิบายพฤติกรรมของโมเดล AI ได้

ลองจินตนาการถึงสิ่งที่อาจเกิดขึ้นเมื่อข้อมูลที่คุณใช้สร้างโมเดลเหล่านี้ขาดแคลนกลุ่มประชากรบางกลุ่ม เช่น เชื้อชาติ เพศ มุมมองทางการเมือง ศาสนา หรือมีการแสดงกลุ่มประชากรเหล่านี้อย่างไม่สมดุล หรือเมื่อผลลัพธ์ของโมเดลถูกตีความว่าให้ความสำคัญกับกลุ่มประชากรบางกลุ่ม ผลกระทบต่อแอปพลิเคชันจะเป็นอย่างไร? นอกจากนี้ หากโมเดลมีผลลัพธ์ที่เป็นอันตรายต่อผู้คน ใครจะเป็นผู้รับผิดชอบต่อพฤติกรรมของระบบ AI? นี่คือคำถามบางส่วนที่เราจะสำรวจในหลักสูตรนี้

ในบทเรียนนี้ คุณจะ:

- ตระหนักถึงความสำคัญของความเป็นธรรมใน Machine Learning และผลกระทบที่เกี่ยวข้องกับความไม่เป็นธรรม

- เรียนรู้การสำรวจค่าผิดปกติและสถานการณ์ที่ไม่ปกติเพื่อให้มั่นใจในความน่าเชื่อถือและความปลอดภัย

- เข้าใจถึงความจำเป็นในการออกแบบระบบที่ครอบคลุมเพื่อให้ทุกคนมีส่วนร่วม

- สำรวจความสำคัญของการปกป้องความเป็นส่วนตัวและความปลอดภัยของข้อมูลและผู้คน

- เห็นความสำคัญของการมีแนวทางแบบ "กล่องแก้ว" เพื่ออธิบายพฤติกรรมของโมเดล AI

- ตระหนักถึงความสำคัญของความรับผิดชอบในการสร้างความไว้วางใจในระบบ AI

ความรู้พื้นฐานที่จำเป็น

ก่อนเริ่มต้นบทเรียนนี้ โปรดเรียนรู้เกี่ยวกับ "หลักการ AI ที่มีความรับผิดชอบ" และดูวิดีโอด้านล่างในหัวข้อที่เกี่ยวข้อง:

เรียนรู้เพิ่มเติมเกี่ยวกับ AI ที่มีความรับผิดชอบได้ที่ Learning Path

🎥 คลิกที่ภาพด้านบนเพื่อดูวิดีโอ: Microsoft's Approach to Responsible AI

ความเป็นธรรม

ระบบ AI ควรปฏิบัติต่อทุกคนอย่างเป็นธรรมและหลีกเลี่ยงการส่งผลกระทบต่อกลุ่มคนที่คล้ายกันในรูปแบบที่แตกต่างกัน ตัวอย่างเช่น เมื่อระบบ AI ให้คำแนะนำเกี่ยวกับการรักษาทางการแพทย์ การสมัครสินเชื่อ หรือการจ้างงาน ระบบควรให้คำแนะนำเดียวกันแก่ทุกคนที่มีอาการคล้ายกัน สถานการณ์ทางการเงิน หรือคุณสมบัติทางวิชาชีพที่คล้ายกัน มนุษย์ทุกคนมีอคติที่สืบทอดมาซึ่งส่งผลต่อการตัดสินใจและการกระทำของเรา อคติเหล่านี้อาจปรากฏในข้อมูลที่เราใช้ฝึกระบบ AI ซึ่งบางครั้งอาจเกิดขึ้นโดยไม่ตั้งใจ และมักเป็นเรื่องยากที่จะรู้ตัวเมื่อคุณกำลังนำอคติเข้าสู่ข้อมูล

“ความไม่เป็นธรรม” หมายถึงผลกระทบเชิงลบ หรือ “อันตราย” ต่อกลุ่มคน เช่น กลุ่มที่กำหนดโดยเชื้อชาติ เพศ อายุ หรือสถานะความพิการ ผลกระทบที่เกี่ยวข้องกับความไม่เป็นธรรมสามารถแบ่งออกเป็น:

- การจัดสรร เช่น การให้ความสำคัญกับเพศหรือเชื้อชาติหนึ่งมากกว่าอีกกลุ่มหนึ่ง

- คุณภาพของบริการ หากคุณฝึกข้อมูลสำหรับสถานการณ์เฉพาะ แต่ความเป็นจริงมีความซับซ้อนมากกว่า จะนำไปสู่บริการที่มีประสิทธิภาพต่ำ ตัวอย่างเช่น เครื่องจ่ายสบู่ที่ไม่สามารถตรวจจับคนที่มีผิวสีเข้มได้ อ้างอิง

- การวิจารณ์เชิงลบ เช่น การวิจารณ์หรือการติดป้ายกำกับอย่างไม่เป็นธรรม ตัวอย่างเช่น เทคโนโลยีการติดป้ายภาพเคยติดป้ายภาพของคนผิวสีว่าเป็นกอริลลา

- การแสดงผลมากเกินไปหรือน้อยเกินไป เช่น การที่กลุ่มหนึ่งไม่ปรากฏในอาชีพบางประเภท และบริการหรือฟังก์ชันใด ๆ ที่ส่งเสริมสิ่งนั้นถือเป็นการสร้างอันตราย

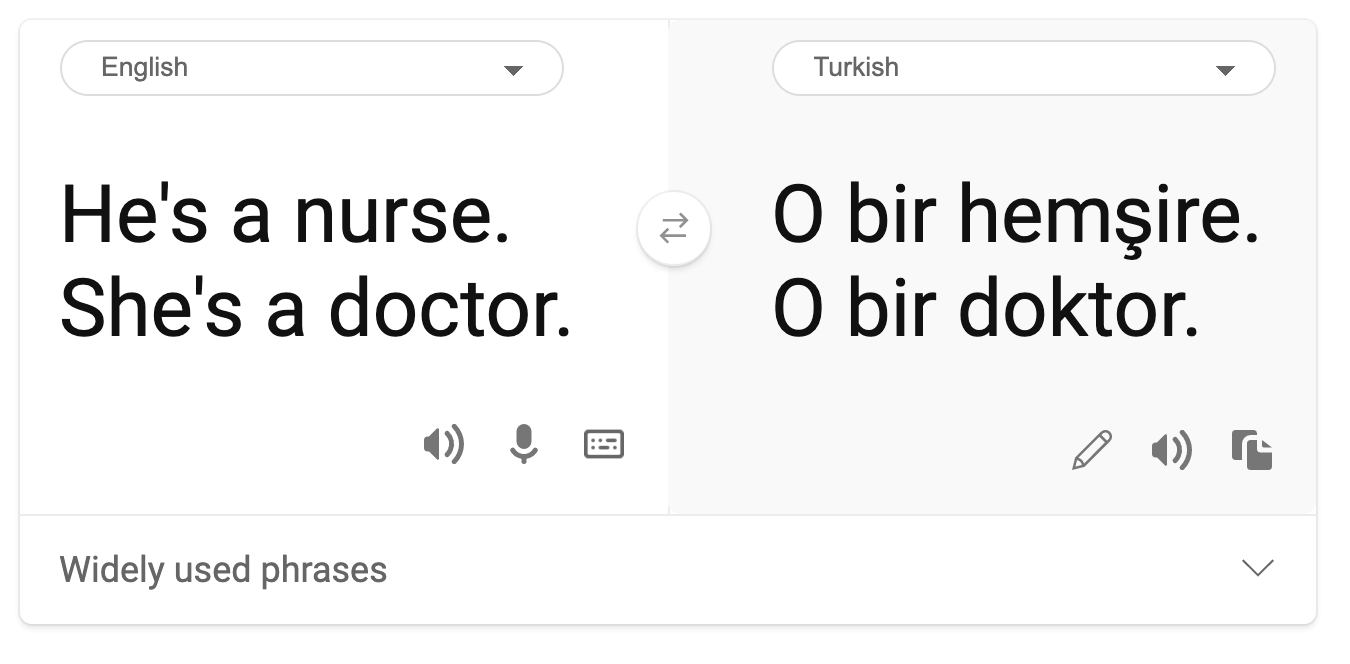

- การเหมารวม เช่น การเชื่อมโยงกลุ่มหนึ่งกับคุณลักษณะที่กำหนดไว้ล่วงหน้า ตัวอย่างเช่น ระบบแปลภาษาระหว่างภาษาอังกฤษและตุรกีอาจมีความไม่ถูกต้องเนื่องจากคำที่มีการเชื่อมโยงกับเพศในเชิงเหมารวม

การแปลเป็นภาษาตุรกี

การแปลกลับเป็นภาษาอังกฤษ

เมื่อออกแบบและทดสอบระบบ AI เราต้องมั่นใจว่า AI มีความเป็นธรรมและไม่ได้ถูกตั้งโปรแกรมให้ตัดสินใจที่มีอคติหรือเลือกปฏิบัติ ซึ่งมนุษย์เองก็ถูกห้ามไม่ให้ทำ การรับประกันความเป็นธรรมใน AI และ Machine Learning ยังคงเป็นความท้าทายที่ซับซ้อนทั้งในด้านสังคมและเทคนิค

ความน่าเชื่อถือและความปลอดภัย

เพื่อสร้างความไว้วางใจ ระบบ AI จำเป็นต้องมีความน่าเชื่อถือ ปลอดภัย และสม่ำเสมอภายใต้เงื่อนไขปกติและไม่ปกติ สิ่งสำคัญคือต้องรู้ว่าระบบ AI จะมีพฤติกรรมอย่างไรในสถานการณ์ต่าง ๆ โดยเฉพาะเมื่อเป็นค่าผิดปกติ เมื่อสร้างโซลูชัน AI จำเป็นต้องให้ความสำคัญอย่างมากกับการจัดการสถานการณ์ที่หลากหลายที่ระบบ AI อาจเผชิญ ตัวอย่างเช่น รถยนต์ที่ขับเคลื่อนด้วยตัวเองต้องให้ความสำคัญกับความปลอดภัยของผู้คนเป็นอันดับแรก ดังนั้น AI ที่ขับเคลื่อนรถยนต์ต้องพิจารณาสถานการณ์ที่เป็นไปได้ทั้งหมดที่รถอาจพบ เช่น กลางคืน พายุฝนฟ้าคะนอง หรือพายุหิมะ เด็กวิ่งข้ามถนน สัตว์เลี้ยง การก่อสร้างถนน เป็นต้น ความสามารถของระบบ AI ในการจัดการเงื่อนไขที่หลากหลายอย่างน่าเชื่อถือและปลอดภัยสะท้อนถึงระดับการคาดการณ์ที่นักวิทยาศาสตร์ข้อมูลหรือผู้พัฒนา AI พิจารณาในระหว่างการออกแบบหรือทดสอบระบบ

การมีส่วนร่วม

ระบบ AI ควรได้รับการออกแบบเพื่อให้ทุกคนมีส่วนร่วมและได้รับการสนับสนุน เมื่อออกแบบและใช้งานระบบ AI นักวิทยาศาสตร์ข้อมูลและผู้พัฒนา AI จะต้องระบุและแก้ไขอุปสรรคที่อาจทำให้ผู้คนถูกกีดกันโดยไม่ตั้งใจ ตัวอย่างเช่น มีผู้คน 1 พันล้านคนทั่วโลกที่มีความพิการ ด้วยความก้าวหน้าของ AI พวกเขาสามารถเข้าถึงข้อมูลและโอกาสได้ง่ายขึ้นในชีวิตประจำวัน การแก้ไขอุปสรรคเหล่านี้ช่วยสร้างโอกาสในการสร้างนวัตกรรมและพัฒนาผลิตภัณฑ์ AI ที่มีประสบการณ์ที่ดีขึ้นซึ่งเป็นประโยชน์ต่อทุกคน

ความปลอดภัยและความเป็นส่วนตัว

ระบบ AI ควรมีความปลอดภัยและเคารพความเป็นส่วนตัวของผู้คน ผู้คนมีความไว้วางใจน้อยลงในระบบที่ทำให้ความเป็นส่วนตัว ข้อมูล หรือชีวิตของพวกเขาตกอยู่ในความเสี่ยง เมื่อฝึกโมเดล Machine Learning เราอาศัยข้อมูลเพื่อให้ได้ผลลัพธ์ที่ดีที่สุด ในการทำเช่นนั้น แหล่งที่มาของข้อมูลและความสมบูรณ์ของข้อมูลต้องได้รับการพิจารณา ตัวอย่างเช่น ข้อมูลนั้นถูกส่งโดยผู้ใช้หรือเป็นข้อมูลสาธารณะ? นอกจากนี้ ในขณะที่ทำงานกับข้อมูล จำเป็นต้องพัฒนาระบบ AI ที่สามารถปกป้องข้อมูลที่เป็นความลับและต้านทานการโจมตีได้ เมื่อ AI มีบทบาทมากขึ้น การปกป้องความเป็นส่วนตัวและการรักษาความปลอดภัยของข้อมูลส่วนบุคคลและข้อมูลธุรกิจที่สำคัญจึงมีความสำคัญและซับซ้อนมากขึ้น ปัญหาความเป็นส่วนตัวและความปลอดภัยของข้อมูลต้องได้รับการดูแลเป็นพิเศษสำหรับ AI เนื่องจากการเข้าถึงข้อมูลเป็นสิ่งสำคัญสำหรับระบบ AI ในการคาดการณ์และตัดสินใจเกี่ยวกับผู้คนอย่างแม่นยำและมีข้อมูลครบถ้วน

- ในอุตสาหกรรม เราได้มีความก้าวหน้าอย่างมากในด้านความเป็นส่วนตัวและความปลอดภัย ซึ่งได้รับแรงผลักดันอย่างมากจากกฎระเบียบ เช่น GDPR (General Data Protection Regulation)

- อย่างไรก็ตาม สำหรับระบบ AI เราต้องยอมรับความตึงเครียดระหว่างความต้องการข้อมูลส่วนบุคคลเพิ่มเติมเพื่อทำให้ระบบมีความเป็นส่วนตัวและมีประสิทธิภาพมากขึ้น กับความเป็นส่วนตัว

- เช่นเดียวกับการเกิดขึ้นของคอมพิวเตอร์ที่เชื่อมต่อกับอินเทอร์เน็ต เรากำลังเห็นการเพิ่มขึ้นอย่างมากในจำนวนปัญหาด้านความปลอดภัยที่เกี่ยวข้องกับ AI

- ในขณะเดียวกัน เราได้เห็น AI ถูกนำมาใช้เพื่อปรับปรุงความปลอดภัย ตัวอย่างเช่น โปรแกรมสแกนไวรัสสมัยใหม่ส่วนใหญ่ขับเคลื่อนโดย AI heuristics

- เราต้องมั่นใจว่ากระบวนการ Data Science ของเราผสมผสานอย่างกลมกลืนกับแนวปฏิบัติด้านความเป็นส่วนตัวและความปลอดภัยล่าสุด

ความโปร่งใส

ระบบ AI ควรสามารถเข้าใจได้ ส่วนสำคัญของความโปร่งใสคือการอธิบายพฤติกรรมของระบบ AI และส่วนประกอบของมัน การปรับปรุงความเข้าใจในระบบ AI ต้องการให้ผู้มีส่วนได้ส่วนเสียเข้าใจว่าระบบทำงานอย่างไรและทำไม เพื่อให้สามารถระบุปัญหาด้านประสิทธิภาพ ความปลอดภัยและความเป็นส่วนตัว อคติ การปฏิบัติที่กีดกัน หรือผลลัพธ์ที่ไม่ตั้งใจได้ นอกจากนี้ เราเชื่อว่าผู้ที่ใช้ระบบ AI ควรมีความซื่อสัตย์และเปิดเผยเกี่ยวกับเวลา เหตุผล และวิธีที่พวกเขาเลือกใช้ระบบ AI รวมถึงข้อจำกัดของระบบที่พวกเขาใช้ ตัวอย่างเช่น หากธนาคารใช้ระบบ AI เพื่อสนับสนุนการตัดสินใจให้สินเชื่อแก่ผู้บริโภค สิ่งสำคัญคือต้องตรวจสอบผลลัพธ์และเข้าใจว่าข้อมูลใดมีอิทธิพลต่อคำแนะนำของระบบ รัฐบาลเริ่มควบคุม AI ในอุตสาหกรรมต่าง ๆ ดังนั้นนักวิทยาศาสตร์ข้อมูลและองค์กรต้องอธิบายว่าระบบ AI ตรงตามข้อกำหนดด้านกฎระเบียบหรือไม่ โดยเฉพาะเมื่อมีผลลัพธ์ที่ไม่พึงประสงค์

- เนื่องจากระบบ AI มีความซับซ้อนมาก จึงยากที่จะเข้าใจว่าระบบทำงานอย่างไรและตีความผลลัพธ์

- ความไม่เข้าใจนี้ส่งผลต่อวิธีการจัดการ การดำเนินงาน และการบันทึกของระบบเหล่านี้

- ความไม่เข้าใจนี้ส่งผลสำคัญต่อการตัดสินใจที่ใช้ผลลัพธ์ที่ระบบเหล่านี้สร้างขึ้น

ความรับผิดชอบ

ผู้ที่ออกแบบและใช้งานระบบ AI ต้องรับผิดชอบต่อการทำงานของระบบ ความจำเป็นในการรับผิดชอบมีความสำคัญอย่างยิ่งในเทคโนโลยีที่มีการใช้งานที่ละเอียดอ่อน เช่น การจดจำใบหน้า เมื่อเร็ว ๆ นี้ มีความต้องการเพิ่มขึ้นสำหรับเทคโนโลยีการจดจำใบหน้า โดยเฉพาะจากองค์กรบังคับใช้กฎหมายที่เห็นศักยภาพของเทคโนโลยีในการใช้งาน เช่น การค้นหาเด็กที่หายไป อย่างไรก็ตาม เทคโนโลยีเหล่านี้อาจถูกใช้โดยรัฐบาลเพื่อทำให้เสรีภาพพื้นฐานของพลเมืองตกอยู่ในความเสี่ยง เช่น การเฝ้าระวังบุคคลเฉพาะอย่างต่อเนื่อง ดังนั้นนักวิทยาศาสตร์ข้อมูลและองค์กรต้องรับผิดชอบต่อผลกระทบของระบบ AI ที่มีต่อบุคคลหรือสังคม

🎥 คลิกที่ภาพด้านบนเพื่อดูวิดีโอ: การเตือนเกี่ยวกับการเฝ้าระวังมวลชนผ่านการจดจำใบหน้า

ในท้ายที่สุด หนึ่งในคำถามที่ใหญ่ที่สุดสำหรับคนรุ่นเรา ในฐานะคนรุ่นแรกที่นำ AI เข้าสู่สังคม คือวิธีการทำให้คอมพิวเตอร์ยังคงมีความรับผิดชอบต่อผู้คน และวิธีการทำให้ผู้ที่ออกแบบคอมพิวเตอร์มีความรับผิดชอบต่อทุกคน

การประเมินผลกระทบ

ก่อนการฝึกโมเดล Machine Learning สิ่งสำคัญคือต้องทำการประเมินผลกระทบเพื่อทำความเข้าใจวัตถุประสงค์ของระบบ AI การใช้งานที่ตั้งใจไว้ สถานที่ที่จะนำไปใช้ และผู้ที่จะมีปฏิสัมพันธ์กับระบบ สิ่งเหล่านี้มีประโยชน์สำหรับผู้ตรวจสอบหรือผู้ทดสอบในการประเมินระบบเพื่อทราบว่าปัจจัยใดที่ควรพิจารณาเมื่อระบุความเสี่ยงที่อาจเกิดขึ้นและผลกระทบที่คาดหวัง

พื้นที่ที่ควรให้ความสำคัญเมื่อทำการประเมินผลกระทบ ได้แก่:

- ผลกระทบเชิงลบต่อบุคคล การตระหนักถึงข้อจำกัดหรือข้อกำหนด การใช้งานที่ไม่รองรับ หรือข้อจำกัดที่ทราบซึ่งขัดขวางประสิทธิภาพของระบบเป็นสิ่งสำคัญเพื่อให้มั่นใจว่าระบบจะไม่ถูกใช้งานในลักษณะที่อาจก่อให้เกิดอันตรายต่อบุคคล

- ข้อกำหนดด้านข้อมูล การทำความเข้าใจว่าระบบจะใช้ข้อมูลอย่างไรและที่ไหนช่วยให้ผู้ตรวจสอบสามารถสำรวจข้อกำหนดด้านข้อมูลที่คุณต้องคำนึงถึง (เช่น ข้อบังคับ GDPR หรือ HIPPA) นอกจากนี้ ตรวจสอบว่าแหล่งที่มาหรือปริมาณข้อมูลมีความเพียงพอสำหรับการฝึกฝนหรือไม่

- สรุปผลกระทบ รวบรวมรายการอันตรายที่อาจเกิดขึ้นจากการใช้ระบบ ในระหว่างวงจรชีวิต ML ตรวจสอบว่าปัญหาที่ระบุได้รับการแก้ไขหรือบรรเทาหรือไม่

- เป้าหมายที่เกี่ยวข้อง สำหรับหลักการหลักทั้งหกข้อ ประเมินว่าเป้าหมายจากแต่ละหลักการได้รับการตอบสนองหรือไม่ และมีช่องว่างใด ๆ หรือไม่

การดีบักด้วย AI ที่มีความรับผิดชอบ

เช่นเดียวกับการดีบักแอปพลิเคชันซอฟต์แวร์ การดีบักระบบ AI เป็นกระบวนการที่จำเป็นในการระบุและ ดูเวิร์กช็อปนี้เพื่อเจาะลึกหัวข้อเพิ่มเติม:

- การแสวงหา AI ที่รับผิดชอบ: นำหลักการไปสู่การปฏิบัติ โดย Besmira Nushi, Mehrnoosh Sameki และ Amit Sharma

🎥 คลิกที่ภาพด้านบนเพื่อดูวิดีโอ: RAI Toolbox: กรอบงานโอเพ่นซอร์สสำหรับการสร้าง AI ที่รับผิดชอบ โดย Besmira Nushi, Mehrnoosh Sameki และ Amit Sharma

นอกจากนี้ อ่านเพิ่มเติม:

-

ศูนย์ทรัพยากร RAI ของ Microsoft: Responsible AI Resources – Microsoft AI

-

กลุ่มวิจัย FATE ของ Microsoft: FATE: Fairness, Accountability, Transparency, and Ethics in AI - Microsoft Research

RAI Toolbox:

อ่านเกี่ยวกับเครื่องมือของ Azure Machine Learning เพื่อรับรองความเป็นธรรม:

งานที่ได้รับมอบหมาย

ข้อจำกัดความรับผิดชอบ:

เอกสารนี้ได้รับการแปลโดยใช้บริการแปลภาษา AI Co-op Translator แม้ว่าเราจะพยายามให้การแปลมีความถูกต้อง แต่โปรดทราบว่าการแปลอัตโนมัติอาจมีข้อผิดพลาดหรือความไม่แม่นยำ เอกสารต้นฉบับในภาษาต้นทางควรถือเป็นแหล่งข้อมูลที่เชื่อถือได้ สำหรับข้อมูลที่สำคัญ ขอแนะนำให้ใช้บริการแปลภาษามนุษย์ที่เป็นมืออาชีพ เราจะไม่รับผิดชอบต่อความเข้าใจผิดหรือการตีความที่ผิดพลาดซึ่งเกิดจากการใช้การแปลนี้