14 KiB

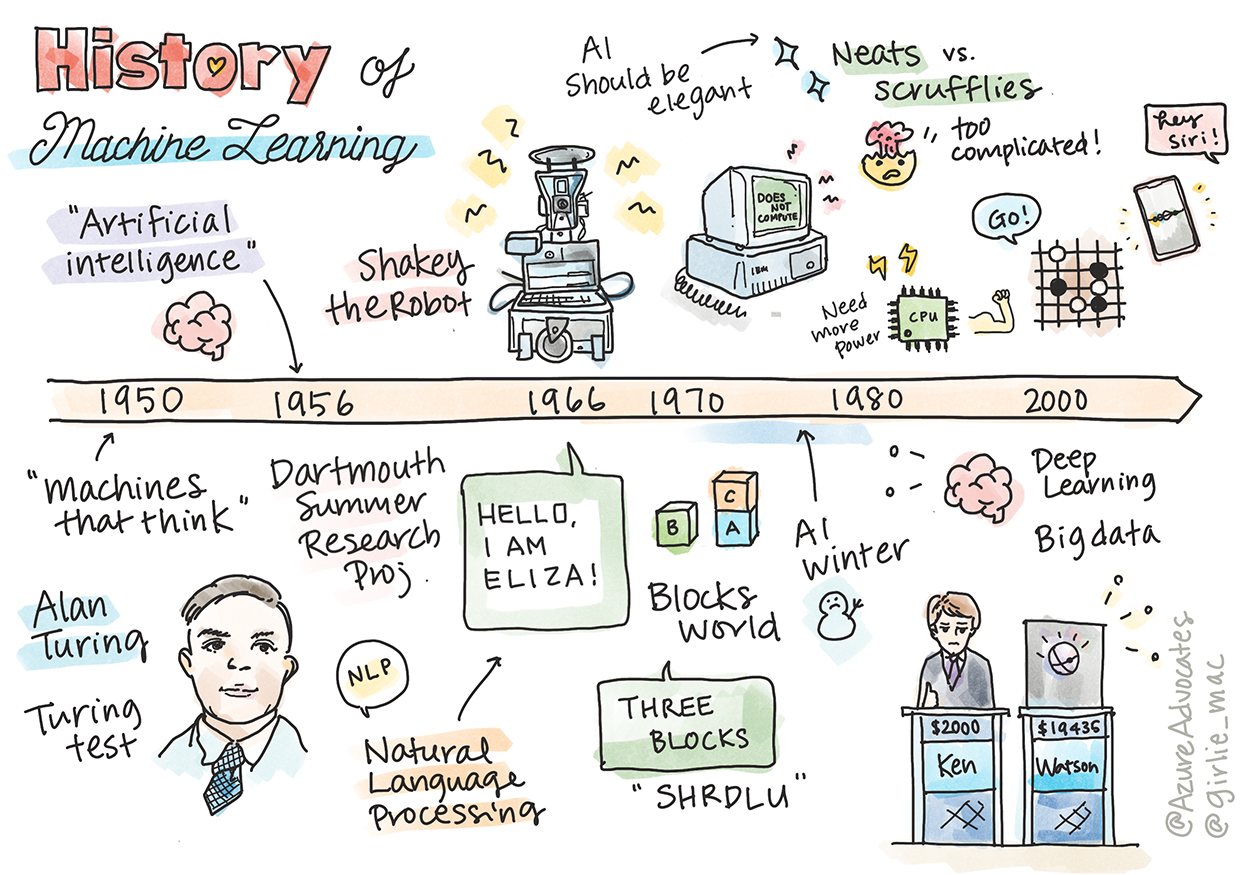

Historia del aprendizaje automático

Sketchnote por Tomomi Imura

Cuestionario previo a la lección

🎥 Haz clic en la imagen de arriba para ver un breve video sobre esta lección.

En esta lección, repasaremos los hitos más importantes en la historia del aprendizaje automático y la inteligencia artificial.

La historia de la inteligencia artificial (IA) como campo está entrelazada con la historia del aprendizaje automático, ya que los algoritmos y avances computacionales que sustentan el aprendizaje automático contribuyeron al desarrollo de la IA. Es útil recordar que, aunque estos campos como áreas de investigación distintas comenzaron a cristalizar en la década de 1950, importantes descubrimientos algorítmicos, estadísticos, matemáticos, computacionales y técnicos precedieron y se superpusieron a esta era. De hecho, las personas han estado reflexionando sobre estas cuestiones durante cientos de años: este artículo analiza los fundamentos intelectuales históricos de la idea de una 'máquina pensante'.

Descubrimientos notables

- 1763, 1812 Teorema de Bayes y sus predecesores. Este teorema y sus aplicaciones son fundamentales para la inferencia, describiendo la probabilidad de que ocurra un evento basado en conocimientos previos.

- 1805 Teoría de los mínimos cuadrados por el matemático francés Adrien-Marie Legendre. Esta teoría, que aprenderás en nuestra unidad de Regresión, ayuda en el ajuste de datos.

- 1913 Cadenas de Markov, nombradas en honor al matemático ruso Andrey Markov, se utilizan para describir una secuencia de eventos posibles basada en un estado previo.

- 1957 Perceptrón, un tipo de clasificador lineal inventado por el psicólogo estadounidense Frank Rosenblatt que sustenta los avances en el aprendizaje profundo.

- 1967 Vecino más cercano es un algoritmo originalmente diseñado para trazar rutas. En un contexto de aprendizaje automático, se utiliza para detectar patrones.

- 1970 Retropropagación se utiliza para entrenar redes neuronales feedforward.

- 1982 Redes neuronales recurrentes son redes neuronales artificiales derivadas de las redes neuronales feedforward que crean gráficos temporales.

✅ Investiga un poco. ¿Qué otras fechas destacan como fundamentales en la historia del aprendizaje automático y la IA?

1950: Máquinas que piensan

Alan Turing, una persona verdaderamente extraordinaria que fue votada por el público en 2019 como el mejor científico del siglo XX, es reconocido por ayudar a sentar las bases del concepto de una 'máquina que puede pensar'. Se enfrentó a detractores y a su propia necesidad de evidencia empírica de este concepto en parte creando el Test de Turing, que explorarás en nuestras lecciones de procesamiento de lenguaje natural.

1956: Proyecto de investigación de verano en Dartmouth

"El Proyecto de investigación de verano en Dartmouth sobre inteligencia artificial fue un evento fundamental para la inteligencia artificial como campo", y fue aquí donde se acuñó el término 'inteligencia artificial' (fuente).

Cada aspecto del aprendizaje o cualquier otra característica de la inteligencia puede, en principio, describirse tan precisamente que se pueda construir una máquina que lo simule.

El investigador principal, el profesor de matemáticas John McCarthy, esperaba "proceder sobre la base de la conjetura de que cada aspecto del aprendizaje o cualquier otra característica de la inteligencia puede, en principio, describirse tan precisamente que se pueda construir una máquina que lo simule". Los participantes incluyeron a otro destacado en el campo, Marvin Minsky.

El taller es reconocido por haber iniciado y fomentado varias discusiones, incluyendo "el auge de los métodos simbólicos, sistemas enfocados en dominios limitados (primeros sistemas expertos) y sistemas deductivos frente a sistemas inductivos". (fuente).

1956 - 1974: "Los años dorados"

Desde la década de 1950 hasta mediados de los años 70, el optimismo era alto con la esperanza de que la IA pudiera resolver muchos problemas. En 1967, Marvin Minsky afirmó con confianza que "Dentro de una generación... el problema de crear 'inteligencia artificial' estará sustancialmente resuelto". (Minsky, Marvin (1967), Computation: Finite and Infinite Machines, Englewood Cliffs, N.J.: Prentice-Hall)

La investigación en procesamiento de lenguaje natural floreció, la búsqueda se refinó y se hizo más poderosa, y se creó el concepto de 'micro-mundos', donde se completaban tareas simples utilizando instrucciones en lenguaje sencillo.

La investigación fue bien financiada por agencias gubernamentales, se lograron avances en computación y algoritmos, y se construyeron prototipos de máquinas inteligentes. Algunas de estas máquinas incluyen:

-

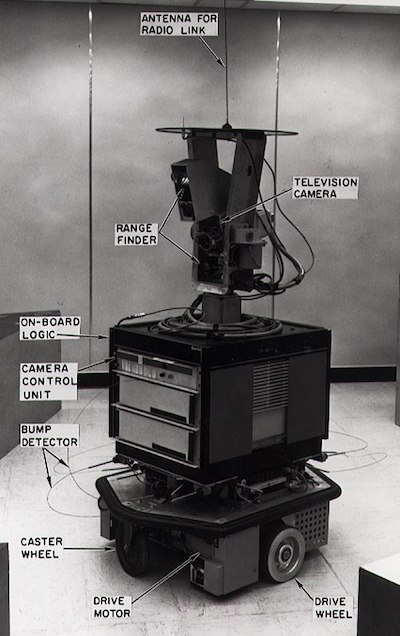

Shakey el robot, que podía maniobrar y decidir cómo realizar tareas 'inteligentemente'.

Shakey en 1972

-

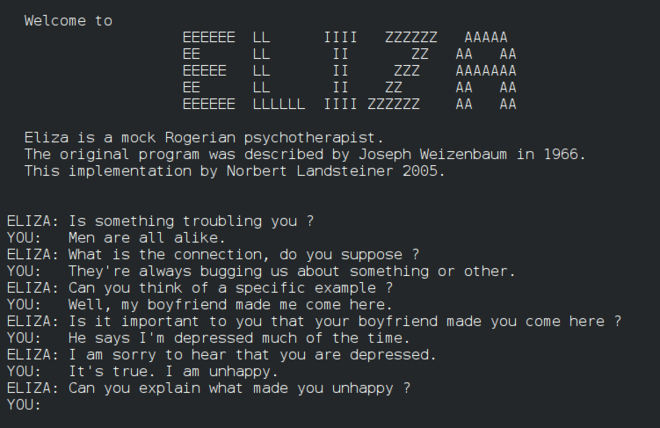

Eliza, un primer 'chatterbot', podía conversar con personas y actuar como un 'terapeuta' primitivo. Aprenderás más sobre Eliza en las lecciones de procesamiento de lenguaje natural.

Una versión de Eliza, un chatbot

-

"Blocks world" fue un ejemplo de un micro-mundo donde los bloques podían apilarse y ordenarse, y se podían probar experimentos para enseñar a las máquinas a tomar decisiones. Los avances construidos con bibliotecas como SHRDLU ayudaron a impulsar el procesamiento de lenguaje.

🎥 Haz clic en la imagen de arriba para ver un video: Blocks world con SHRDLU

1974 - 1980: "Invierno de la IA"

A mediados de los años 70, se hizo evidente que la complejidad de crear 'máquinas inteligentes' había sido subestimada y que su promesa, dada la potencia computacional disponible, había sido exagerada. Los fondos se agotaron y la confianza en el campo disminuyó. Algunos problemas que afectaron la confianza incluyeron:

- Limitaciones. La potencia computacional era demasiado limitada.

- Explosión combinatoria. La cantidad de parámetros necesarios para entrenar creció exponencialmente a medida que se pedía más a las computadoras, sin una evolución paralela de la potencia y capacidad computacional.

- Escasez de datos. Había una escasez de datos que dificultaba el proceso de probar, desarrollar y refinar algoritmos.

- ¿Estamos haciendo las preguntas correctas?. Las mismas preguntas que se estaban planteando comenzaron a ser cuestionadas. Los investigadores comenzaron a recibir críticas sobre sus enfoques:

- Los tests de Turing fueron cuestionados mediante, entre otras ideas, la 'teoría de la habitación china', que postulaba que, "programar una computadora digital puede hacer que parezca entender el lenguaje pero no podría producir una comprensión real". (fuente)

- Se cuestionó la ética de introducir inteligencias artificiales como el "terapeuta" ELIZA en la sociedad.

Al mismo tiempo, comenzaron a formarse varias escuelas de pensamiento sobre IA. Se estableció una dicotomía entre las prácticas de "IA desordenada" vs. "IA ordenada". Los laboratorios desordenados ajustaban programas durante horas hasta obtener los resultados deseados. Los laboratorios ordenados "se enfocaban en la lógica y la resolución formal de problemas". ELIZA y SHRDLU eran sistemas desordenados bien conocidos. En la década de 1980, a medida que surgió la demanda de hacer que los sistemas de aprendizaje automático fueran reproducibles, el enfoque ordenado gradualmente tomó la delantera, ya que sus resultados son más explicables.

Sistemas expertos en los años 80

A medida que el campo creció, su beneficio para los negocios se hizo más claro, y en la década de 1980 también lo hizo la proliferación de 'sistemas expertos'. "Los sistemas expertos estuvieron entre las primeras formas verdaderamente exitosas de software de inteligencia artificial (IA)." (fuente).

Este tipo de sistema es en realidad híbrido, compuesto parcialmente por un motor de reglas que define los requisitos empresariales y un motor de inferencia que aprovecha el sistema de reglas para deducir nuevos hechos.

Esta era también vio una creciente atención hacia las redes neuronales.

1987 - 1993: Enfriamiento de la IA

La proliferación de hardware especializado para sistemas expertos tuvo el desafortunado efecto de volverse demasiado especializado. El auge de las computadoras personales también compitió con estos sistemas grandes, especializados y centralizados. La democratización de la informática había comenzado, y eventualmente allanó el camino para la explosión moderna de big data.

1993 - 2011

Esta época marcó una nueva era para el aprendizaje automático y la IA, permitiendo resolver algunos de los problemas causados anteriormente por la falta de datos y potencia computacional. La cantidad de datos comenzó a aumentar rápidamente y a estar más ampliamente disponible, para bien y para mal, especialmente con la llegada del smartphone alrededor de 2007. La potencia computacional se expandió exponencialmente, y los algoritmos evolucionaron junto con ella. El campo comenzó a ganar madurez a medida que los días desenfrenados del pasado comenzaron a cristalizarse en una verdadera disciplina.

Hoy

Hoy en día, el aprendizaje automático y la IA tocan casi todas las partes de nuestras vidas. Esta era exige una comprensión cuidadosa de los riesgos y los efectos potenciales de estos algoritmos en la vida humana. Como ha afirmado Brad Smith de Microsoft, "La tecnología de la información plantea cuestiones que van al corazón de las protecciones fundamentales de los derechos humanos, como la privacidad y la libertad de expresión. Estas cuestiones aumentan la responsabilidad de las empresas tecnológicas que crean estos productos. En nuestra opinión, también exigen una regulación gubernamental reflexiva y el desarrollo de normas sobre usos aceptables" (fuente).

Queda por ver qué depara el futuro, pero es importante comprender estos sistemas informáticos y el software y los algoritmos que ejecutan. Esperamos que este plan de estudios te ayude a obtener una mejor comprensión para que puedas decidir por ti mismo.

🎥 Haz clic en la imagen de arriba para ver un video: Yann LeCun habla sobre la historia del aprendizaje profundo en esta conferencia

🚀Desafío

Investiga uno de estos momentos históricos y aprende más sobre las personas detrás de ellos. Hay personajes fascinantes, y ningún descubrimiento científico se creó jamás en un vacío cultural. ¿Qué descubres?

Cuestionario posterior a la lección

Revisión y autoestudio

Aquí tienes elementos para ver y escuchar:

Este podcast donde Amy Boyd analiza la evolución de la IA

Tarea

Descargo de responsabilidad:

Este documento ha sido traducido utilizando el servicio de traducción automática Co-op Translator. Si bien nos esforzamos por garantizar la precisión, tenga en cuenta que las traducciones automatizadas pueden contener errores o imprecisiones. El documento original en su idioma nativo debe considerarse como la fuente autorizada. Para información crítica, se recomienda una traducción profesional realizada por humanos. No nos hacemos responsables de malentendidos o interpretaciones erróneas que puedan surgir del uso de esta traducción.