24 KiB

Δημιουργία λύσεων Μηχανικής Μάθησης με υπεύθυνη Τεχνητή Νοημοσύνη

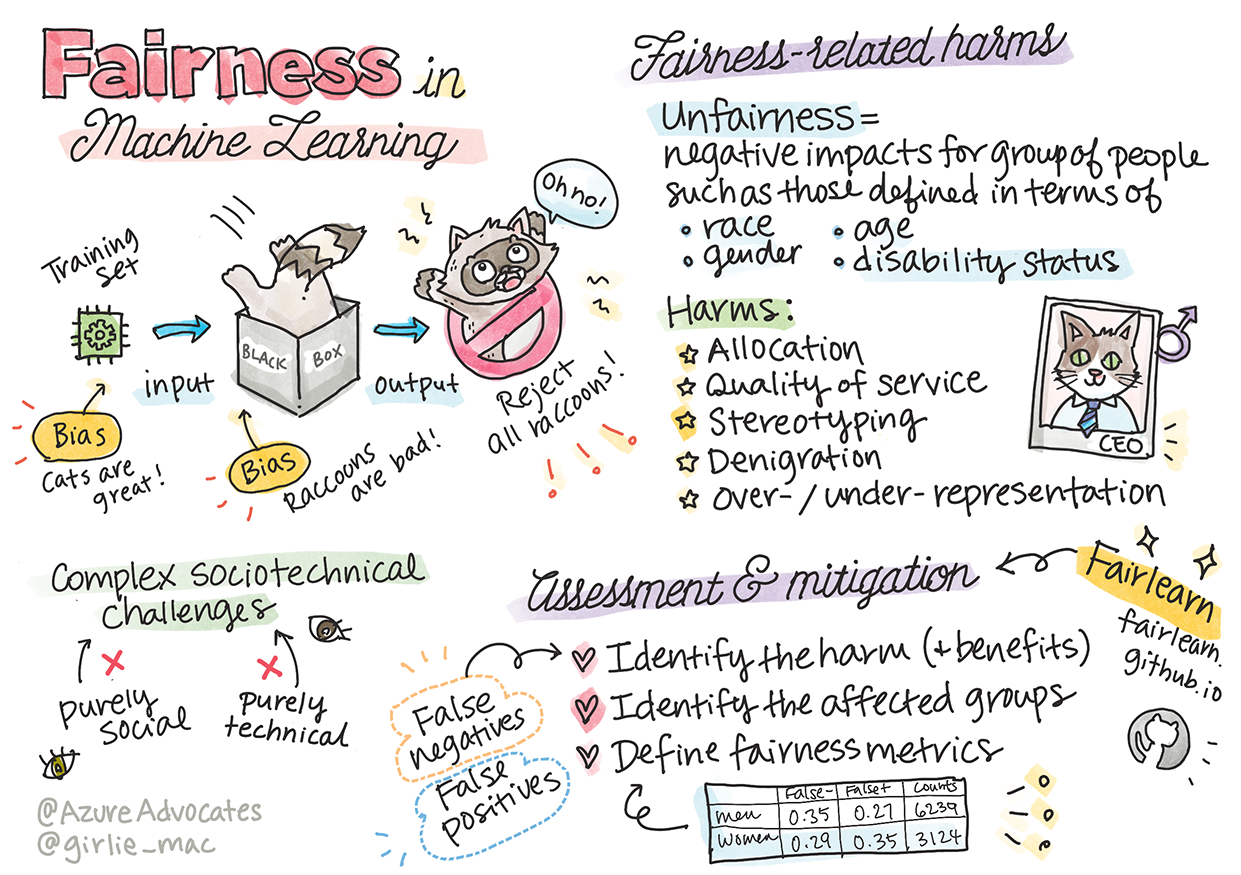

Σκίτσο από την Tomomi Imura

Προ-μάθημα κουίζ

Εισαγωγή

Σε αυτό το πρόγραμμα σπουδών, θα αρχίσετε να ανακαλύπτετε πώς η μηχανική μάθηση μπορεί και επηρεάζει την καθημερινή μας ζωή. Ακόμα και τώρα, συστήματα και μοντέλα εμπλέκονται σε καθημερινές διαδικασίες λήψης αποφάσεων, όπως διαγνώσεις υγείας, εγκρίσεις δανείων ή ανίχνευση απάτης. Είναι λοιπόν σημαντικό αυτά τα μοντέλα να λειτουργούν σωστά ώστε να παρέχουν αξιόπιστα αποτελέσματα. Όπως κάθε εφαρμογή λογισμικού, τα συστήματα Τεχνητής Νοημοσύνης μπορεί να μην ανταποκριθούν στις προσδοκίες ή να έχουν ανεπιθύμητα αποτελέσματα. Γι' αυτό είναι απαραίτητο να μπορούμε να κατανοούμε και να εξηγούμε τη συμπεριφορά ενός μοντέλου Τεχνητής Νοημοσύνης.

Φανταστείτε τι μπορεί να συμβεί όταν τα δεδομένα που χρησιμοποιείτε για να δημιουργήσετε αυτά τα μοντέλα δεν περιλαμβάνουν συγκεκριμένες δημογραφικές ομάδες, όπως φυλή, φύλο, πολιτικές απόψεις, θρησκεία, ή όταν εκπροσωπούν δυσανάλογα αυτές τις ομάδες. Τι γίνεται όταν η έξοδος του μοντέλου ερμηνεύεται ώστε να ευνοεί κάποια δημογραφική ομάδα; Ποια είναι η συνέπεια για την εφαρμογή; Επιπλέον, τι συμβαίνει όταν το μοντέλο έχει αρνητικό αποτέλεσμα και είναι επιβλαβές για τους ανθρώπους; Ποιος είναι υπεύθυνος για τη συμπεριφορά του συστήματος Τεχνητής Νοημοσύνης; Αυτά είναι μερικά από τα ερωτήματα που θα εξερευνήσουμε σε αυτό το πρόγραμμα σπουδών.

Σε αυτό το μάθημα, θα:

- Αυξήσετε την ευαισθητοποίησή σας για τη σημασία της δικαιοσύνης στη μηχανική μάθηση και τις βλάβες που σχετίζονται με αυτήν.

- Εξοικειωθείτε με την πρακτική της εξερεύνησης ακραίων περιπτώσεων και ασυνήθιστων σεναρίων για να διασφαλίσετε την αξιοπιστία και την ασφάλεια.

- Κατανοήσετε την ανάγκη να ενδυναμώσουμε όλους σχεδιάζοντας συστήματα χωρίς αποκλεισμούς.

- Εξερευνήσετε πόσο ζωτικής σημασίας είναι η προστασία της ιδιωτικότητας και της ασφάλειας των δεδομένων και των ανθρώπων.

- Δείτε τη σημασία της διαφάνειας για την εξήγηση της συμπεριφοράς των μοντέλων Τεχνητής Νοημοσύνης.

- Εξετάσετε πώς η λογοδοσία είναι απαραίτητη για την οικοδόμηση εμπιστοσύνης στα συστήματα Τεχνητής Νοημοσύνης.

Προαπαιτούμενα

Ως προαπαιτούμενο, παρακαλούμε να παρακολουθήσετε το "Responsible AI Principles" Learn Path και να δείτε το παρακάτω βίντεο σχετικά με το θέμα:

Μάθετε περισσότερα για την Υπεύθυνη Τεχνητή Νοημοσύνη ακολουθώντας αυτό το Learning Path

🎥 Κάντε κλικ στην εικόνα παραπάνω για το βίντεο: Η προσέγγιση της Microsoft για την Υπεύθυνη Τεχνητή Νοημοσύνη

Δικαιοσύνη

Τα συστήματα Τεχνητής Νοημοσύνης πρέπει να αντιμετωπίζουν όλους δίκαια και να αποφεύγουν να επηρεάζουν παρόμοιες ομάδες ανθρώπων με διαφορετικούς τρόπους. Για παράδειγμα, όταν τα συστήματα Τεχνητής Νοημοσύνης παρέχουν καθοδήγηση για ιατρική θεραπεία, αιτήσεις δανείων ή απασχόληση, πρέπει να κάνουν τις ίδιες συστάσεις σε όλους με παρόμοια συμπτώματα, οικονομικές συνθήκες ή επαγγελματικά προσόντα. Ο καθένας μας, ως άνθρωπος, φέρει κληρονομικές προκαταλήψεις που επηρεάζουν τις αποφάσεις και τις ενέργειές μας. Αυτές οι προκαταλήψεις μπορεί να είναι εμφανείς στα δεδομένα που χρησιμοποιούμε για την εκπαίδευση των συστημάτων Τεχνητής Νοημοσύνης. Μερικές φορές, τέτοιες παραποιήσεις συμβαίνουν ακούσια. Είναι συχνά δύσκολο να γνωρίζουμε συνειδητά πότε εισάγουμε προκατάληψη στα δεδομένα.

Η "Αδικία" περιλαμβάνει αρνητικές επιπτώσεις ή "βλάβες" για μια ομάδα ανθρώπων, όπως αυτές που ορίζονται με βάση τη φυλή, το φύλο, την ηλικία ή την κατάσταση αναπηρίας. Οι κύριες βλάβες που σχετίζονται με τη δικαιοσύνη μπορούν να ταξινομηθούν ως:

- Κατανομή: Όταν, για παράδειγμα, ένα φύλο ή μια εθνικότητα ευνοείται έναντι άλλης.

- Ποιότητα υπηρεσίας: Εάν εκπαιδεύσετε τα δεδομένα για ένα συγκεκριμένο σενάριο, αλλά η πραγματικότητα είναι πολύ πιο περίπλοκη, αυτό οδηγεί σε κακή απόδοση της υπηρεσίας. Για παράδειγμα, ένας διανομέας σαπουνιού που δεν μπορούσε να ανιχνεύσει ανθρώπους με σκούρο δέρμα. Αναφορά

- Υποτίμηση: Η άδικη κριτική και η ετικετοποίηση κάτι ή κάποιου. Για παράδειγμα, μια τεχνολογία ετικετοποίησης εικόνων κατηγορήθηκε ότι εσφαλμένα ετικετοποίησε εικόνες ανθρώπων με σκούρο δέρμα ως γορίλες.

- Υπερ- ή υπο-εκπροσώπηση: Η ιδέα ότι μια συγκεκριμένη ομάδα δεν φαίνεται σε ένα συγκεκριμένο επάγγελμα, και οποιαδήποτε υπηρεσία ή λειτουργία που συνεχίζει να προωθεί αυτό συμβάλλει στη βλάβη.

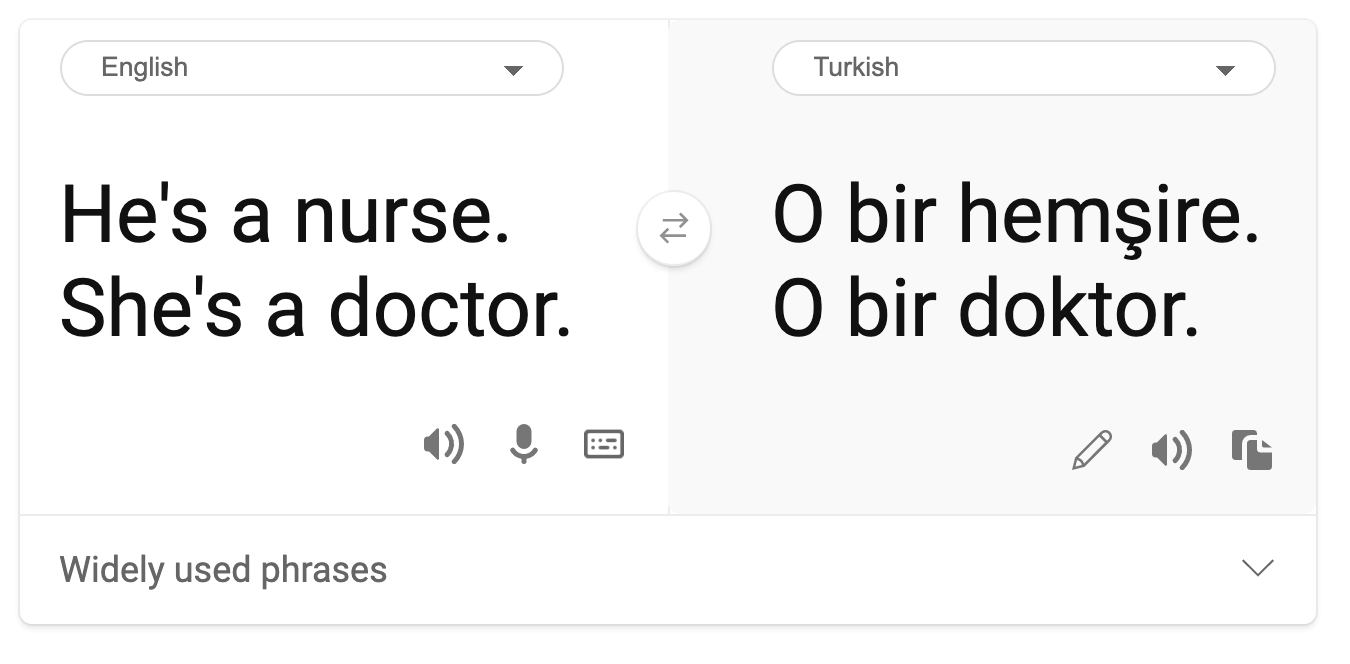

- Στερεοτυπία: Η σύνδεση μιας δεδομένης ομάδας με προκαθορισμένα χαρακτηριστικά. Για παράδειγμα, ένα σύστημα μετάφρασης μεταξύ Αγγλικών και Τουρκικών μπορεί να έχει ανακρίβειες λόγω λέξεων με στερεοτυπικές συσχετίσεις με το φύλο.

μετάφραση στα Τουρκικά

μετάφραση πίσω στα Αγγλικά

Όταν σχεδιάζουμε και δοκιμάζουμε συστήματα Τεχνητής Νοημοσύνης, πρέπει να διασφαλίσουμε ότι η Τεχνητή Νοημοσύνη είναι δίκαιη και δεν προγραμματίζεται να λαμβάνει προκατειλημμένες ή διακριτικές αποφάσεις, τις οποίες απαγορεύεται να λαμβάνουν και οι άνθρωποι. Η διασφάλιση της δικαιοσύνης στην Τεχνητή Νοημοσύνη και τη μηχανική μάθηση παραμένει μια σύνθετη κοινωνικοτεχνική πρόκληση.

Αξιοπιστία και ασφάλεια

Για να οικοδομήσουμε εμπιστοσύνη, τα συστήματα Τεχνητής Νοημοσύνης πρέπει να είναι αξιόπιστα, ασφαλή και συνεπή υπό κανονικές και απρόβλεπτες συνθήκες. Είναι σημαντικό να γνωρίζουμε πώς θα συμπεριφερθούν τα συστήματα Τεχνητής Νοημοσύνης σε διάφορες καταστάσεις, ειδικά όταν πρόκειται για ακραίες περιπτώσεις. Όταν δημιουργούμε λύσεις Τεχνητής Νοημοσύνης, πρέπει να δίνεται μεγάλη έμφαση στο πώς να χειριστούμε μια ευρεία ποικιλία περιστάσεων που θα αντιμετωπίσουν οι λύσεις Τεχνητής Νοημοσύνης. Για παράδειγμα, ένα αυτοκινούμενο αυτοκίνητο πρέπει να θέτει την ασφάλεια των ανθρώπων ως κορυφαία προτεραιότητα. Ως αποτέλεσμα, η Τεχνητή Νοημοσύνη που τροφοδοτεί το αυτοκίνητο πρέπει να λαμβάνει υπόψη όλα τα πιθανά σενάρια που μπορεί να συναντήσει το αυτοκίνητο, όπως νύχτα, καταιγίδες ή χιονοθύελλες, παιδιά που τρέχουν στον δρόμο, κατοικίδια, κατασκευές στον δρόμο κ.λπ. Το πόσο καλά ένα σύστημα Τεχνητής Νοημοσύνης μπορεί να χειριστεί ένα ευρύ φάσμα συνθηκών με αξιοπιστία και ασφάλεια αντικατοπτρίζει το επίπεδο προνοητικότητας που έλαβε υπόψη ο επιστήμονας δεδομένων ή ο προγραμματιστής Τεχνητής Νοημοσύνης κατά τη σχεδίαση ή τη δοκιμή του συστήματος.

Συμπερίληψη

Τα συστήματα Τεχνητής Νοημοσύνης πρέπει να σχεδιάζονται ώστε να εμπλέκουν και να ενδυναμώνουν όλους. Κατά τη σχεδίαση και την υλοποίηση συστημάτων Τεχνητής Νοημοσύνης, οι επιστήμονες δεδομένων και οι προγραμματιστές Τεχνητής Νοημοσύνης εντοπίζουν και αντιμετωπίζουν πιθανά εμπόδια στο σύστημα που θα μπορούσαν ακούσια να αποκλείσουν ανθρώπους. Για παράδειγμα, υπάρχουν 1 δισεκατομμύριο άνθρωποι με αναπηρίες σε όλο τον κόσμο. Με την πρόοδο της Τεχνητής Νοημοσύνης, μπορούν να έχουν πρόσβαση σε ένα ευρύ φάσμα πληροφοριών και ευκαιριών πιο εύκολα στην καθημερινή τους ζωή. Αντιμετωπίζοντας τα εμπόδια, δημιουργούνται ευκαιρίες για καινοτομία και ανάπτυξη προϊόντων Τεχνητής Νοημοσύνης με καλύτερες εμπειρίες που ωφελούν όλους.

🎥 Κάντε κλικ εδώ για ένα βίντεο: συμπερίληψη στην Τεχνητή Νοημοσύνη

Ασφάλεια και ιδιωτικότητα

Τα συστήματα Τεχνητής Νοημοσύνης πρέπει να είναι ασφαλή και να σέβονται την ιδιωτικότητα των ανθρώπων. Οι άνθρωποι έχουν λιγότερη εμπιστοσύνη σε συστήματα που θέτουν την ιδιωτικότητά τους, τις πληροφορίες τους ή τη ζωή τους σε κίνδυνο. Κατά την εκπαίδευση μοντέλων μηχανικής μάθησης, βασιζόμαστε στα δεδομένα για να παράγουμε τα καλύτερα αποτελέσματα. Κάνοντας αυτό, πρέπει να λαμβάνεται υπόψη η προέλευση και η ακεραιότητα των δεδομένων. Για παράδειγμα, υποβλήθηκαν τα δεδομένα από χρήστες ή ήταν διαθέσιμα δημόσια; Στη συνέχεια, ενώ εργαζόμαστε με τα δεδομένα, είναι κρίσιμο να αναπτύξουμε συστήματα Τεχνητής Νοημοσύνης που μπορούν να προστατεύσουν εμπιστευτικές πληροφορίες και να αντισταθούν σε επιθέσεις. Καθώς η Τεχνητή Νοημοσύνη γίνεται πιο διαδεδομένη, η προστασία της ιδιωτικότητας και η ασφάλεια σημαντικών προσωπικών και επιχειρηματικών πληροφοριών γίνεται πιο κρίσιμη και περίπλοκη. Τα ζητήματα ιδιωτικότητας και ασφάλειας δεδομένων απαιτούν ιδιαίτερη προσοχή για την Τεχνητή Νοημοσύνη, επειδή η πρόσβαση στα δεδομένα είναι απαραίτητη για να κάνουν τα συστήματα Τεχνητής Νοημοσύνης ακριβείς και ενημερωμένες προβλέψεις και αποφάσεις για τους ανθρώπους.

🎥 Κάντε κλικ εδώ για ένα βίντεο: ασφάλεια στην Τεχνητή Νοημοσύνη

- Ως βιομηχανία έχουμε σημειώσει σημαντική πρόοδο στην ιδιωτικότητα και την ασφάλεια, τροφοδοτούμενη σημαντικά από κανονισμούς όπως ο GDPR (Γενικός Κανονισμός για την Προστασία Δεδομένων).

- Παρ' όλα αυτά, με τα συστήματα Τεχνητής Νοημοσύνης πρέπει να αναγνωρίσουμε την ένταση μεταξύ της ανάγκης για περισσότερα προσωπικά δεδομένα ώστε να κάνουμε τα συστήματα πιο προσωπικά και αποτελεσματικά – και της ιδιωτικότητας.

- Όπως με τη γέννηση των συνδεδεμένων υπολογιστών μέσω του διαδικτύου, βλέπουμε επίσης μια τεράστια αύξηση στον αριθμό των ζητημάτων ασφάλειας που σχετίζονται με την Τεχνητή Νοημοσύνη.

- Ταυτόχρονα, έχουμε δει την Τεχνητή Νοημοσύνη να χρησιμοποιείται για τη βελτίωση της ασφάλειας. Για παράδειγμα, οι περισσότερες σύγχρονες σαρωτές αντι-ιών καθοδηγούνται από ευρετικές Τεχνητής Νοημοσύνης.

- Πρέπει να διασφαλίσουμε ότι οι διαδικασίες Επιστήμης Δεδομένων μας συνδυάζονται αρμονικά με τις τελευταίες πρακτικές ιδιωτικότητας και ασφάλειας.

Διαφάνεια

Τα συστήματα Τεχνητής Νοημοσύνης πρέπει να είναι κατανοητά. Ένα κρίσιμο μέρος της διαφάνειας είναι η εξήγηση της συμπεριφοράς των συστημάτων Τεχνητής Νοημοσύνης και των συστατικών τους. Η βελτίωση της κατανόησης των συστημάτων Τεχνητής Νοημοσύνης απαιτεί από τους ενδιαφερόμενους να κατανοήσουν πώς και γιατί λειτουργούν, ώστε να μπορούν να εντοπίσουν πιθανά ζητήματα απόδοσης, ανησυχίες για την ασφάλεια και την ιδιωτικότητα, προκαταλήψεις, πρακτικές αποκλεισμού ή ακούσια αποτελέσματα. Πιστεύουμε επίσης ότι όσοι χρησιμοποιούν συστήματα Τεχνητής Νοημοσύνης πρέπει να είναι ειλικρινείς και ανοιχτοί σχετικά με το πότε, γιατί και πώς επιλέγουν να τα χρησιμοποιήσουν. Καθώς και για τους περιορισμούς των συστημάτων που χρησιμοποιούν. Για παράδειγμα, εάν μια τράπεζα χρησιμοποιεί ένα σύστημα Τεχνητής Νοημοσύνης για να υποστηρίξει τις αποφάσεις δανεισμού καταναλωτών, είναι σημαντικό να εξεταστούν τα αποτελέσματα και να κατανοηθεί ποια δεδομένα επηρεάζουν τις συστάσεις του συστήματος. Οι κυβερνήσεις αρχίζουν να ρυθμίζουν την Τεχνητή Νοημοσύνη σε διάφορους κλάδους, οπότε οι επιστήμονες δεδομένων και οι οργανισμοί πρέπει να εξηγήσουν εάν ένα σύστημα Τεχνητής Νοημοσύνης πληροί τις κανονιστικές απαιτήσεις, ειδικά όταν υπάρχει ανεπιθύμητο αποτέλεσμα.

🎥 Κάντε κλικ εδώ για ένα βίντεο: διαφάνεια στην Τεχνητή Νοημοσύνη

- Επειδή τα συστήματα Τεχνητής Νοημοσύνης είναι τόσο περίπλοκα, είναι δύσκολο να κατανοήσουμε πώς λειτουργούν και να ερμηνεύσουμε τα αποτελέσματα.

- Αυτή η έλλειψη κατανόησης επηρεάζει τον τρόπο με τον οποίο αυτά τα συστήματα διαχειρίζονται, λειτουργούν και τεκμηριώνονται.

- Αυτή η έλλειψη κατανόησης επηρεάζει πιο σημαντικά τις αποφάσεις που λαμβάνονται χρησιμοποιώντας τα αποτελέσματα που παράγουν αυτά τα συστήματα.

Λογοδοσία

Οι άνθρωποι που σχεδιάζουν και αναπτύσσουν συστήματα Τεχνητής Νοημοσύνης πρέπει να είναι υπεύθυ Παρακολουθήστε αυτό το εργαστήριο για να εμβαθύνετε στα θέματα:

- Στην αναζήτηση υπεύθυνης AI: Εφαρμογή αρχών στην πράξη από τους Besmira Nushi, Mehrnoosh Sameki και Amit Sharma

🎥 Κάντε κλικ στην εικόνα παραπάνω για το βίντεο: RAI Toolbox: Ένα ανοιχτού κώδικα πλαίσιο για την ανάπτυξη υπεύθυνης AI από τους Besmira Nushi, Mehrnoosh Sameki και Amit Sharma

Επίσης, διαβάστε:

-

Το κέντρο πόρων RAI της Microsoft: Responsible AI Resources – Microsoft AI

-

Η ερευνητική ομάδα FATE της Microsoft: FATE: Fairness, Accountability, Transparency, and Ethics in AI - Microsoft Research

RAI Toolbox:

Διαβάστε για τα εργαλεία του Azure Machine Learning για τη διασφάλιση της δικαιοσύνης:

Εργασία

Αποποίηση ευθύνης:

Αυτό το έγγραφο έχει μεταφραστεί χρησιμοποιώντας την υπηρεσία αυτόματης μετάφρασης Co-op Translator. Παρόλο που καταβάλλουμε προσπάθειες για ακρίβεια, παρακαλούμε να έχετε υπόψη ότι οι αυτοματοποιημένες μεταφράσεις ενδέχεται να περιέχουν λάθη ή ανακρίβειες. Το πρωτότυπο έγγραφο στη μητρική του γλώσσα θα πρέπει να θεωρείται η αυθεντική πηγή. Για κρίσιμες πληροφορίες, συνιστάται επαγγελματική ανθρώπινη μετάφραση. Δεν φέρουμε ευθύνη για τυχόν παρεξηγήσεις ή εσφαλμένες ερμηνείες που προκύπτουν από τη χρήση αυτής της μετάφρασης.