27 KiB

Създаване на решения за машинно обучение с отговорен AI

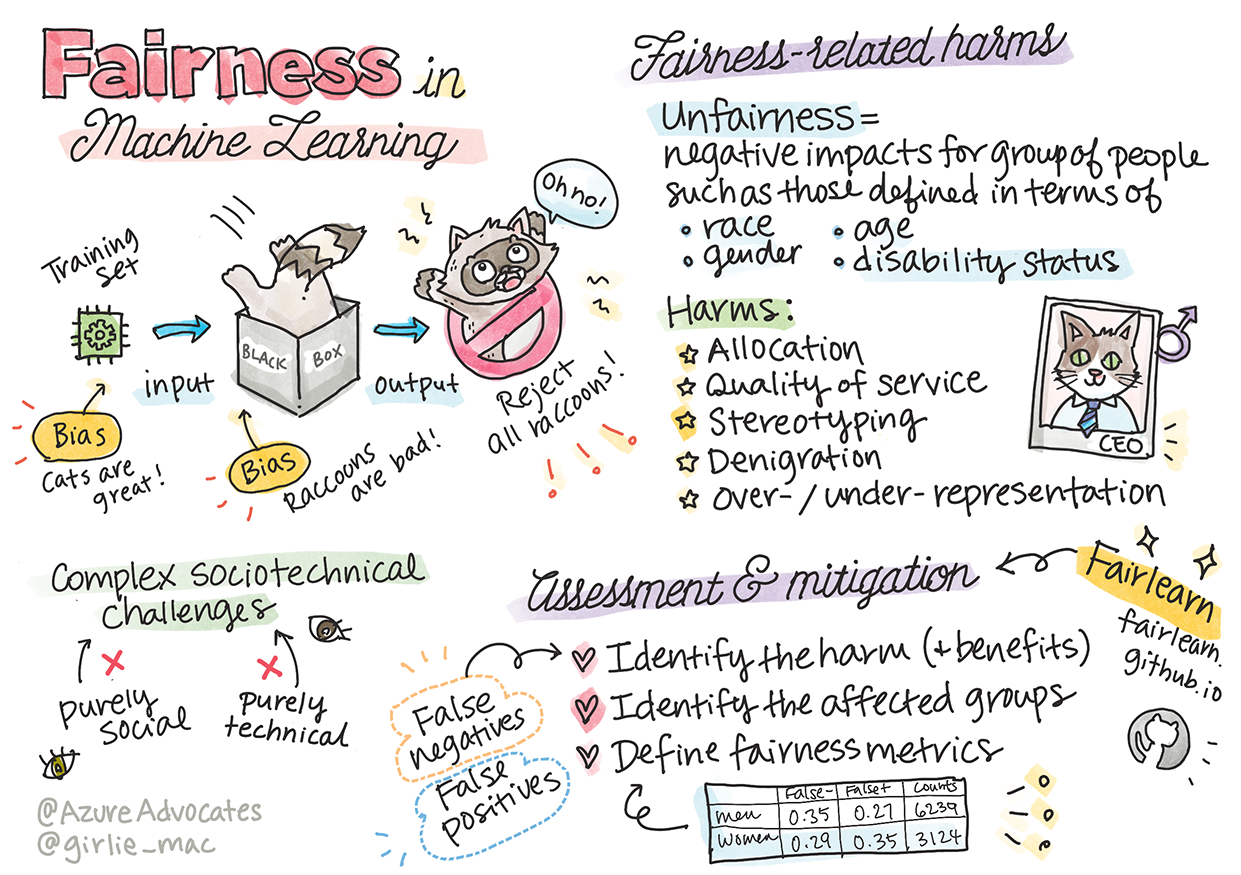

Скица от Tomomi Imura

Тест преди лекцията

Въведение

В този учебен материал ще започнете да откривате как машинното обучение може да влияе и вече влияе на нашето ежедневие. Дори сега системи и модели участват в ежедневни задачи за вземане на решения, като диагностика в здравеопазването, одобрение на заеми или откриване на измами. Затова е важно тези модели да работят добре, за да предоставят резултати, които са надеждни. Както всяко софтуерно приложение, AI системите могат да не оправдаят очакванията или да доведат до нежелани резултати. Ето защо е от съществено значение да можем да разберем и обясним поведението на AI модела.

Представете си какво може да се случи, когато данните, които използвате за изграждане на тези модели, липсват определени демографски характеристики, като раса, пол, политически възгледи, религия, или непропорционално представят такива демографски характеристики. А какво става, когато изходът на модела се интерпретира така, че да фаворизира определена демографска група? Какви са последствията за приложението? Освен това, какво се случва, когато моделът има неблагоприятен резултат и вреди на хората? Кой носи отговорност за поведението на AI системите? Това са някои от въпросите, които ще разгледаме в този учебен материал.

В този урок ще:

- Повишите осведомеността си за важността на справедливостта в машинното обучение и вредите, свързани със справедливостта.

- Станете запознати с практиката за изследване на изключения и необичайни сценарии, за да гарантирате надеждност и безопасност.

- Разберете необходимостта от създаване на инклузивни системи, които дават възможност на всички.

- Изследвате колко важно е да се защитава поверителността и сигурността на данните и хората.

- Видите значението на подхода "стъклена кутия" за обяснение на поведението на AI моделите.

- Бъдете внимателни към това как отговорността е от съществено значение за изграждане на доверие в AI системите.

Предварителни изисквания

Като предварително изискване, моля, преминете през учебния път "Принципи на отговорния AI" и гледайте видеото по-долу на тази тема:

Научете повече за отговорния AI, като следвате този учебен път

🎥 Кликнете върху изображението по-горе за видео: Подходът на Microsoft към отговорния AI

Справедливост

AI системите трябва да третират всички справедливо и да избягват различно въздействие върху сходни групи хора. Например, когато AI системите предоставят насоки за медицинско лечение, заявления за заеми или заетост, те трябва да правят същите препоръки на всички със сходни симптоми, финансови обстоятелства или професионални квалификации. Всеки от нас като хора носи наследени предразсъдъци, които влияят на нашите решения и действия. Тези предразсъдъци могат да бъдат очевидни в данните, които използваме за обучение на AI системи. Такава манипулация понякога може да се случи неволно. Често е трудно съзнателно да се осъзнае кога въвеждате предразсъдъци в данните.

„Несправедливост“ обхваща негативни въздействия или „вреди“ за група хора, като тези, дефинирани по отношение на раса, пол, възраст или статус на инвалидност. Основните вреди, свързани със справедливостта, могат да бъдат класифицирани като:

- Разпределение, ако например даден пол или етнос е предпочитан пред друг.

- Качество на услугата. Ако обучите данните за един специфичен сценарий, но реалността е много по-сложна, това води до лошо представяне на услугата. Например, дозатор за сапун, който не може да разпознае хора с тъмна кожа. Референция

- Омаловажаване. Несправедливо критикуване и етикетиране на нещо или някого. Например, технология за етикетиране на изображения, която скандално етикетира изображения на хора с тъмна кожа като горили.

- Прекомерно или недостатъчно представяне. Идеята е, че определена група не се вижда в определена професия, и всяка услуга или функция, която продължава да насърчава това, допринася за вреда.

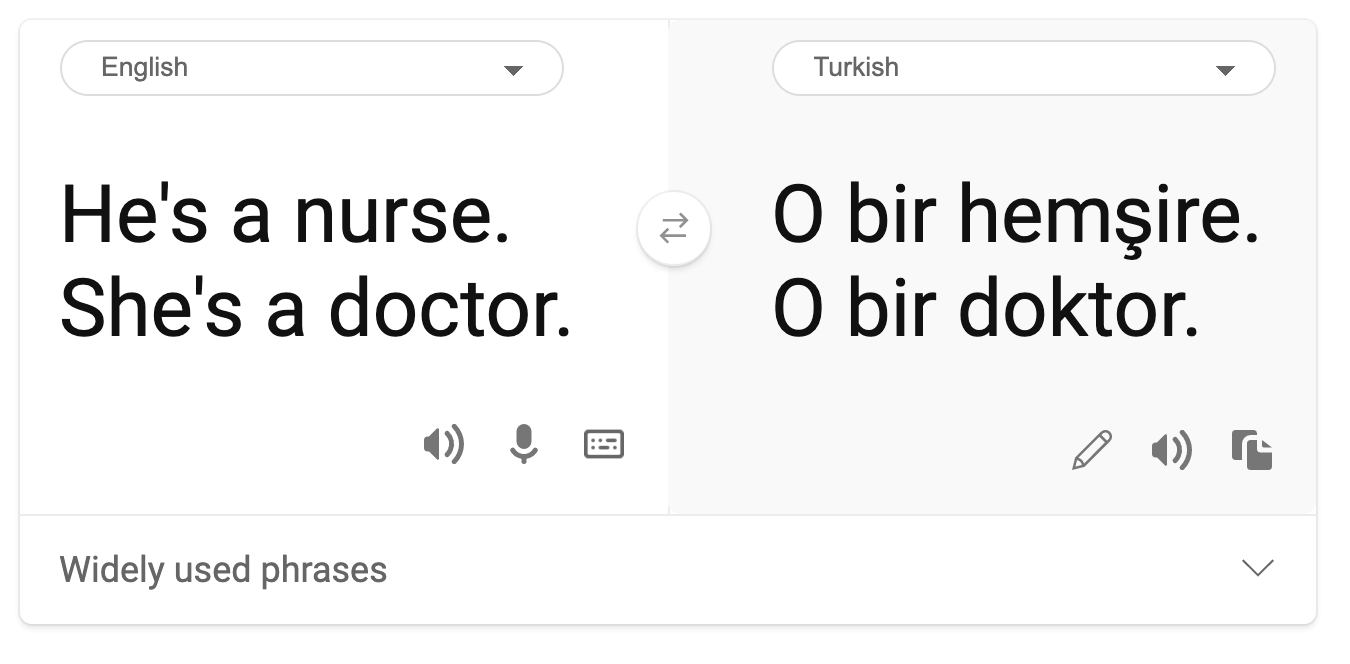

- Стереотипизиране. Свързване на дадена група с предварително зададени атрибути. Например, система за превод между английски и турски може да има неточности поради думи със стереотипни асоциации към пола.

превод на турски

превод обратно на английски

Когато проектираме и тестваме AI системи, трябва да гарантираме, че AI е справедлив и не е програмиран да взема предубедени или дискриминационни решения, които също са забранени за хората. Гарантирането на справедливост в AI и машинното обучение остава сложен социотехнически предизвикателство.

Надеждност и безопасност

За да изградим доверие, AI системите трябва да бъдат надеждни, безопасни и последователни при нормални и неочаквани условия. Важно е да знаем как AI системите ще се държат в различни ситуации, особено когато са изключения. Когато изграждаме AI решения, трябва да се съсредоточим значително върху това как да се справим с широк спектър от обстоятелства, които AI решенията биха срещнали. Например, самоуправляваща се кола трябва да постави безопасността на хората като основен приоритет. В резултат AI, който управлява колата, трябва да вземе предвид всички възможни сценарии, които колата може да срещне, като нощ, гръмотевични бури или снежни виелици, деца, които тичат по улицата, домашни любимци, пътни ремонти и др. Колко добре AI системата може да се справи с широк спектър от условия надеждно и безопасно отразява нивото на предвиждане, което специалистът по данни или AI разработчик е взел предвид по време на проектирането или тестването на системата.

Инклузивност

AI системите трябва да бъдат проектирани така, че да ангажират и дават възможност на всички. Когато проектират и внедряват AI системи, специалистите по данни и AI разработчиците идентифицират и адресират потенциални бариери в системата, които биха могли неволно да изключат хора. Например, има 1 милиард хора с увреждания по света. С напредъка на AI те могат да получат достъп до широк спектър от информация и възможности по-лесно в ежедневния си живот. Като адресираме бариерите, създаваме възможности за иновации и разработване на AI продукти с по-добри преживявания, които са от полза за всички.

Сигурност и поверителност

AI системите трябва да бъдат безопасни и да уважават поверителността на хората. Хората имат по-малко доверие в системи, които поставят тяхната поверителност, информация или живот в риск. Когато обучаваме модели за машинно обучение, разчитаме на данни, за да постигнем най-добри резултати. В този процес трябва да се вземе предвид произходът и интегритетът на данните. Например, дали данните са предоставени от потребители или са публично достъпни? Освен това, докато работим с данните, е важно да разработим AI системи, които могат да защитят конфиденциална информация и да устоят на атаки. С разпространението на AI защитата на поверителността и сигурността на важна лична и бизнес информация става все по-критична и сложна. Въпросите за поверителност и сигурност на данните изискват особено внимание за AI, защото достъпът до данни е от съществено значение за AI системите, за да правят точни и информирани прогнози и решения за хората.

- Като индустрия постигнахме значителен напредък в поверителността и сигурността, значително подпомогнат от регулации като GDPR (Общ регламент за защита на данните).

- Въпреки това, с AI системите трябва да признаем напрежението между нуждата от повече лични данни за правене на системите по-лични и ефективни – и поверителността.

- Както при раждането на свързани компютри с интернет, наблюдаваме огромен ръст в броя на проблемите със сигурността, свързани с AI.

- В същото време виждаме AI, използван за подобряване на сигурността. Например, повечето съвременни антивирусни скенери се задвижват от AI евристики.

- Трябва да гарантираме, че нашите процеси за анализ на данни хармонично се съчетават с най-новите практики за поверителност и сигурност.

Прозрачност

AI системите трябва да бъдат разбираеми. Ключова част от прозрачността е обяснението на поведението на AI системите и техните компоненти. Подобряването на разбирането на AI системите изисква заинтересованите страни да разберат как и защо те функционират, за да могат да идентифицират потенциални проблеми с производителността, опасения за безопасността и поверителността, предразсъдъци, изключващи практики или нежелани резултати. Също така вярваме, че тези, които използват AI системи, трябва да бъдат честни и открити относно това кога, защо и как решават да ги внедрят, както и ограниченията на системите, които използват. Например, ако банка използва AI система за подпомагане на решения за потребителско кредитиране, важно е да се изследват резултатите и да се разбере кои данни влияят на препоръките на системата. Правителствата започват да регулират AI в различни индустрии, така че специалистите по данни и организациите трябва да обяснят дали AI системата отговаря на регулаторните изисквания, особено когато има нежелан резултат.

- Тъй като AI системите са толкова сложни, е трудно да се разбере как работят и да се интерпретират резултатите.

- Тази липса на разбиране влияе върху начина, по който тези системи се управляват, оперативизират и документират.

- Тази липса на разбиране, по-важното, влияе върху решенията, взети въз основа на резултатите, които тези системи произвеждат.

Отговорност

Хората, които проектират и внедряват AI системи, трябва да бъдат отговорни за начина, по който техните системи функционират. Необходимостта от отговорност е особено важна при чувствителни технологии като разпознаване на лица. Напоследък има нарастващо търсене на технологии за разпознаване на лица, особено от организации за правоприлагане, които виждат потенциала на технологията в приложения като намиране на изчезнали деца. Въпреки това, тези технологии могат потенциално да бъдат използвани от правителство, за да поставят основните свободи на гражданите в риск, например чрез непрекъснато наблюдение на конкретни лица. Затова специалистите по данни и организациите трябва да бъдат отговорни за начина, по който тяхната AI система влияе на индивидите или обществото.

🎥 Кликнете върху изображението по-горе за видео: Предупреждения за масово наблюдение чрез разпознаване на лица

В крайна сметка един от най-големите въпроси за нашето поколение, като първото поколение, което въвежда AI в обществото, е как да гарантираме, че компютрите ще останат отговорни пред хората и как да гарантираме, че хората, които проектират компютри, остават отговорни пред всички останали.

Оценка на въздействието

Преди да обучите модел за машинно обучение, е важно да проведете оценка на въздействието, за да разберете целта на AI системата; какво е предназначението ѝ; къде ще бъде внедрена; и кой ще взаимодейства със системата. Това е полезно за рецензенти или тестери, които оценяват системата, за да знаят какви фактори да вземат предвид при идентифициране на потенциални рискове и очаквани последствия.

Следните са области на фокус при провеждане на оценка на въздействието:

- Неблагоприятно въздействие върху индивидите. Осъзнаването на всякакви ограничения или изисквания, неподдържана употреба или известни ограничения, които възпрепятстват производителността на системата, е жизненоважно, за да се гарантира, че системата не се използва по начин, който може да причини вреда на индивидите.

- Изисквания за данни. Разбирането на това как и къде системата ще използва данни позволява на рецензентите да изследват всякакви изисквания за данни, които трябва да се вземат предвид (например, GDPR или HIPPA регулации за данни). Освен това, проверете дали източникът или количеството данни са достатъчни за обучение.

- Обобщение на въздействието. Съберете списък с потенциални вреди, които могат да възникнат от използването на системата. През целия жизнен цикъл на ML проверявайте дали идентифицираните проблеми са смекчени или адресирани.

- Приложими цели за всяка от шестте основни принципа. Оценете дали целите от всеки принцип са постигнати и дали има пропуски.

Дебъгване с отговорен AI

Подобно на дебъгването на софтуерно приложение, дебъгването на AI система е необходим процес за идентифициране и разрешаване на проблеми в системата. Има много фактори, които могат да повлияят на модела да не работи според очакванията или отговорно. Повечето традиционни метрики за производителност на модела са количествени агрегати на производителността на модела, които не са достатъчни за анализиране как моделът нарушава принципите на отговорния AI. Освен това, моделът за машинно обучение е черна кутия, което затруднява разбирането на това, което движи неговия резултат или предоставянето на обяснение, когато прави греш Гледайте този уъркшоп, за да се задълбочите в темите:

- В търсене на отговорен AI: Превръщане на принципите в практика от Бесмира Нуши, Мехрнуш Самеки и Амит Шарма

🎥 Кликнете върху изображението по-горе за видео: RAI Toolbox: Отворена рамка за изграждане на отговорен AI от Бесмира Нуши, Мехрнуш Самеки и Амит Шарма

Също така, прочетете:

-

Ресурсният център на Microsoft за отговорен AI: Responsible AI Resources – Microsoft AI

-

Изследователската група FATE на Microsoft: FATE: Fairness, Accountability, Transparency, and Ethics in AI - Microsoft Research

RAI Toolbox:

Прочетете за инструментите на Azure Machine Learning за осигуряване на справедливост:

Задача

Отказ от отговорност:

Този документ е преведен с помощта на AI услуга за превод Co-op Translator. Въпреки че се стремим към точност, моля, имайте предвид, че автоматизираните преводи може да съдържат грешки или неточности. Оригиналният документ на неговия роден език трябва да се счита за авторитетен източник. За критична информация се препоръчва професионален човешки превод. Ние не носим отговорност за недоразумения или погрешни интерпретации, произтичащи от използването на този превод.