16 KiB

責任あるAIを用いた機械学習ソリューションの構築

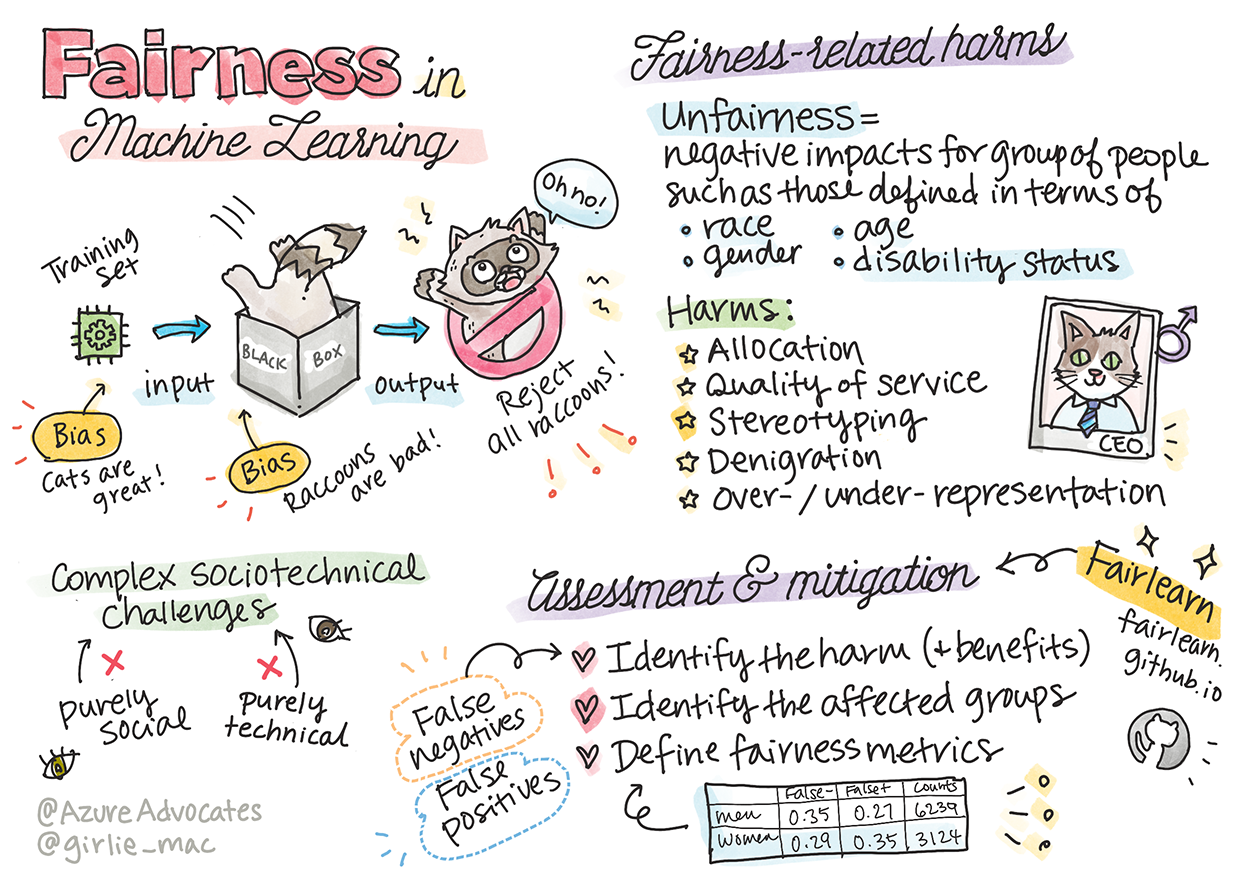

スケッチノート by Tomomi Imura

事前講義クイズ

はじめに

このカリキュラムでは、機械学習がどのように私たちの日常生活に影響を与えているかを発見し始めます。現在でも、システムやモデルは、医療診断、ローンの承認、詐欺の検出など、日常の意思決定タスクに関与しています。したがって、これらのモデルが信頼できる結果を提供するためにうまく機能することが重要です。あらゆるソフトウェアアプリケーションと同様に、AIシステムも期待を裏切ったり、望ましくない結果をもたらすことがあります。そのため、AIモデルの挙動を理解し、説明することが不可欠です。

これらのモデルを構築するために使用するデータに特定の人口統計(人種、性別、政治的見解、宗教など)が欠けている場合、またはこれらの人口統計が不均衡に表現されている場合、何が起こるかを想像してみてください。モデルの出力が特定の人口統計を優遇するように解釈された場合、アプリケーションにとっての結果はどうなるでしょうか。さらに、モデルが望ましくない結果をもたらし、人々に害を及ぼす場合はどうなるでしょうか。AIシステムの挙動に対する責任は誰が負うのでしょうか。これらは、このカリキュラムで探求するいくつかの質問です。

このレッスンでは、次のことを学びます:

- 機械学習における公平性の重要性と関連する害についての認識を高める

- 信頼性と安全性を確保するために異常値や異常なシナリオを探る実践に慣れる

- 包括的なシステムを設計することで全員をエンパワーメントする必要性を理解する

- データと人々のプライバシーとセキュリティを保護することの重要性を探る

- AIモデルの挙動を説明するためのガラスボックスアプローチの重要性を見る

- AIシステムに対する信頼を構築するためにアカウンタビリティが不可欠であることを意識する

前提条件

前提条件として、「責任あるAIの原則」学習パスを受講し、以下のビデオを視聴してください:

この学習パスを通じて責任あるAIについてさらに学びましょう。

🎥 上の画像をクリックしてビデオを視聴: Microsoftの責任あるAIへのアプローチ

公平性

AIシステムはすべての人を公平に扱い、類似のグループに異なる影響を与えないようにする必要があります。例えば、AIシステムが医療処置、ローン申請、または雇用に関するガイダンスを提供する場合、類似の症状、財政状況、または専門資格を持つすべての人に同じ推奨を行うべきです。私たち人間は、意思決定や行動に影響を与える遺伝的なバイアスを持っています。これらのバイアスは、AIシステムをトレーニングするために使用するデータにも現れることがあります。このような操作は時には意図せずに行われることがあります。データにバイアスを導入する際に意識的に気づくことはしばしば困難です。

**「不公平」**とは、人種、性別、年齢、障害状態などの観点から定義される人々のグループに対するネガティブな影響、または「害」を指します。主な公平性に関連する害は次のように分類されます:

- 割り当て。例えば、性別や民族が他の性別や民族に対して優遇される場合。

- サービスの質。特定のシナリオのためにデータをトレーニングしたが、現実ははるかに複雑である場合、パフォーマンスの低いサービスにつながります。例えば、暗い肌の人々を感知できないハンドソープディスペンサー。参考

- 中傷。何かまたは誰かを不公平に批判し、ラベル付けすること。例えば、画像ラベリング技術が暗い肌の人々の画像をゴリラと誤ってラベリングしたことで有名です。

- 過剰または過小な表現。特定の職業に特定のグループが見られないという考えであり、そのサービスや機能がそれを促進し続けることは害をもたらします。

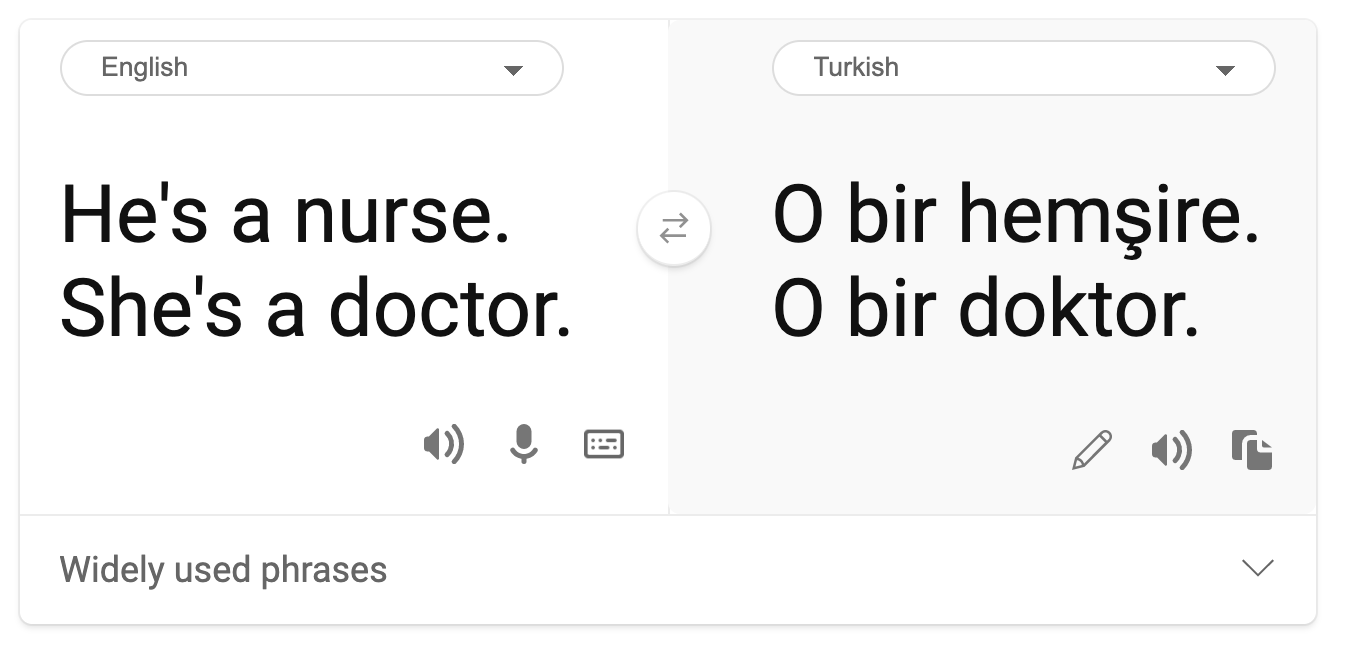

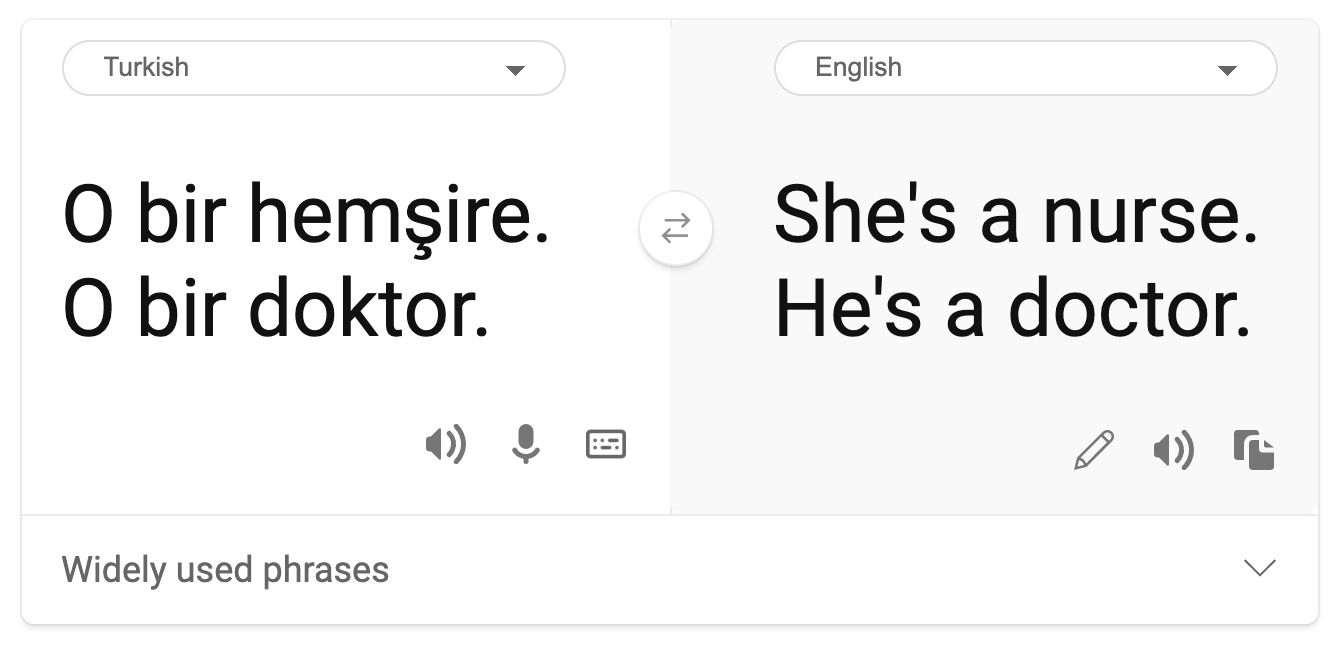

- ステレオタイプ。特定のグループを事前に割り当てられた属性と関連付けること。例えば、英語とトルコ語の間の言語翻訳システムが、性別に関するステレオタイプに関連する単語のために不正確さを持つ可能性があります。

トルコ語への翻訳

英語への翻訳

AIシステムの設計とテストを行う際には、AIが公平であり、バイアスや差別的な決定を下すようにプログラムされていないことを確認する必要があります。AIと機械学習における公平性を保証することは、依然として複雑な社会技術的課題です。

信頼性と安全性

信頼を築くためには、AIシステムは通常および予期せぬ条件下でも信頼性が高く、安全で一貫している必要があります。特に外れ値の場合に、AIシステムがどのように挙動するかを知ることが重要です。AIソリューションを構築する際には、AIソリューションが遭遇するさまざまな状況をどのように処理するかに多くの焦点を当てる必要があります。例えば、自動運転車は人々の安全を最優先に考える必要があります。その結果、車を駆動するAIは、夜間、雷雨、吹雪、道路を横切る子供、ペット、道路工事など、車が遭遇する可能性のあるすべてのシナリオを考慮する必要があります。AIシステムが幅広い条件をどれだけ信頼性が高く安全に処理できるかは、データサイエンティストやAI開発者がシステムの設計やテスト中にどれだけの予測を考慮したかを反映しています。

包括性

AIシステムは、すべての人々をエンゲージし、エンパワーメントするように設計されるべきです。AIシステムを設計および実装する際に、データサイエンティストやAI開発者は、システムが意図せずに人々を排除する可能性のある障壁を特定し、対処します。例えば、世界中には10億人の障害者がいます。AIの進歩により、彼らは日常生活で幅広い情報や機会により簡単にアクセスできるようになります。障壁に対処することで、すべての人々に利益をもたらすより良い体験を提供するAI製品を革新し、開発する機会が生まれます。

セキュリティとプライバシー

AIシステムは安全であり、人々のプライバシーを尊重するべきです。プライバシー、情報、または生活を危険にさらすシステムには、人々はあまり信頼を寄せません。機械学習モデルをトレーニングする際には、最良の結果を生み出すためにデータに依存します。そのため、データの出所と整合性を考慮する必要があります。例えば、データがユーザーによって提供されたものか、公開されているものかを確認します。次に、データを扱う際には、機密情報を保護し、攻撃に耐えるAIシステムを開発することが重要です。AIが普及するにつれて、プライバシーを保護し、重要な個人情報やビジネス情報を保護することがますます重要かつ複雑になっています。プライバシーとデータセキュリティの問題は、AIにとって特に注意が必要です。なぜなら、データへのアクセスは、AIシステムが人々について正確で情報に基づいた予測と決定を行うために不可欠だからです。

- 業界として、GDPR(一般データ保護規則)などの規制により、プライバシーとセキュリティの分野で大きな進展を遂げました。

- しかし、AIシステムにおいては、システムをより個人的で効果的にするためにより多くの個人データが必要であるという必要性とプライバシーの間の緊張関係を認識する必要があります。

- インターネットを介した接続されたコンピュータの誕生と同様に、AIに関連するセキュリティ問題の数が急増しています。

- 同時に、セキュリティを向上させるためにAIが使用されているのを目にしています。例えば、ほとんどの最新のアンチウイルススキャナーは、今日ではAIヒューリスティックによって駆動されています。

- データサイエンスのプロセスが最新のプライバシーとセキュリティの実践と調和するようにする必要があります。

透明性

AIシステムは理解可能であるべきです。透明性の重要な部分は、AIシステムとそのコンポーネントの挙動を説明することです。AIシステムの理解を深めるためには、ステークホルダーがそれらがどのように機能し、なぜ機能するのかを理解し、潜在的なパフォーマンスの問題、安全性とプライバシーの懸念、バイアス、排除的な実践、または意図しない結果を特定できるようにする必要があります。また、AIシステムを使用する人々は、いつ、なぜ、どのようにそれらを展開することを選択するのかについて正直で率直であるべきだと考えています。使用するシステムの限界も含めて説明する必要があります。例えば、銀行が消費者向け融資決定を支援するためにAIシステムを使用する場合、その結果を調査し、システムの推奨をどのデータが影響しているのかを理解することが重要です。政府は産業全体でAIを規制し始めているため、データサイエンティストや組織は、AIシステムが規制要件を満たしているかどうかを説明する必要があります。特に望ましくない結果が生じた場合には、特に重要です。

- AIシステムは非常に複雑であるため、それらがどのように機能し、結果を解釈するのかを理解するのは難しいです。

- この理解の欠如は、これらのシステムがどのように管理され、運用され、文書化されるかに影響を与えます。

- さらに重要なのは、これらのシステムが生成する結果を使用して行われる意思決定に影響を与えます。

アカウンタビリティ

AIシステムを設計し、展開する人々は、そのシステムの動作に対して責任を負わなければなりません。アカウンタビリティの必要性は、特に顔認識のような敏感な技術において特に重要です。最近、特に失踪した子供を見つけるなどの用途で技術の可能性を見ている法執行機関から、顔認識技術に対する需要が高まっています。しかし、これらの技術は、特定の個人の継続的な監視を可能にすることによって、政府が市民の基本的な自由を危険にさらす可能性があります。したがって、データサイエンティストや組織は、自分たちのAIシステムが個人や社会に与える影響について責任を持つ必要があります。

🎥 上の画像をクリックしてビデオを視聴: 顔認識による大規模監視の警告

最終的に、AIを社会に導入する最初の世代としての私たちの最大の課題の一つは、コンピュータが人々に対して責任を持ち続けることをどのように確保するか、そしてコンピュータを設計する人々が他のすべての人々に対して責任を持ち続けることをどのように確保するかです。

影響評価

機械学習モデルをトレーニングする前に、AIシステムの目的、意図された使用法、展開場所、およびシステムとやり取りする人々を理解するために影響評価を実施することが重要です。これらは、システムを評価するレビュアーやテスターに、潜在的なリスクや予期される結果を特定する際に考慮すべき要因を知らせるのに役立ちます。

影響評価を行う際の重点領域は次のとおりです:

- 個人への悪影響。システムのパフォーマンスを妨げる制限や要件、サポートされていない使用法、既知の制限に注意を払うことは、システムが個人に害を与える方法で使用されないようにするために重要です。

- データ要件。システムがデータをどのように使用し、どこで使用するかを理解することで、考慮すべきデータ要件(例:GDPRやHIPPAデータ規制)を探ることができます。さらに、トレーニングに十分なデータの出所や量を確認します。

- 影響の概要。システムの使用によって生じる可能性のある害のリストを収集します。MLライフサイクル全体で、特定された問題が軽減または対処されているかどうかを確認します。

- 6つのコア原則の適用可能な目標。各原則の目標が達成されているかどうか、およびギャップがあるかどうかを評価します。

責任あるAIによるデバッグ

ソフトウェアアプリケーションの

免責事項: この文書は機械ベースのAI翻訳サービスを使用して翻訳されています。正確さを期していますが、自動翻訳には誤りや不正確さが含まれる可能性があることをご理解ください。元の言語で書かれた原文が信頼できる情報源とみなされるべきです。重要な情報については、専門の人間による翻訳を推奨します。この翻訳の使用に起因する誤解や誤った解釈について、当社は責任を負いません。