Middleware

Introduction:收纳技术相关的基础知识 `Redis`、`RocketMQ`、`Zookeeper`、`Netty`、`Tomcat` 等总结!

[TOC]

# SPI

SPI 全称为 Service Provider Interface,是一种服务发现机制。SPI 的本质是将接口实现类的全限定名,配置在文件中,并由服务加载器读取配置文件,加载实现类。这样可以在运行时,动态为接口替换实现类,正因为该特性,我们可以很容易的通过 SPI 机制为程序提供拓展功能。

## Java SPI

JDK 中 提供了一个 `SPI` 的功能,核心类是 `java.util.ServiceLoader`。其作用就是,可以通过类名获取在 `META-INF/services/` 下的多个配置实现文件。为了解决上面的扩展问题,现在我们在`META-INF/services/`下创建一个`com.github.yu120.test.SuperLoggerConfiguration`文件(没有后缀)。文件中只有一行代码,那就是我们默认的`com.github.yu120.test.XMLConfiguration`(注意,一个文件里也可以写多个实现,回车分隔)。然后通过 ServiceLoader 获取我们的 SPI 机制配置的实现类:

```java

// META-INF/services/com.github.test.test.SuperLoggerConfiguration:

com.github.yu120.test.XMLConfiguration

ServiceLoader serviceLoader = ServiceLoader.load(SuperLoggerConfiguration.class);

Iterator iterator = serviceLoader.iterator();

SuperLoggerConfiguration configuration;

while(iterator.hasNext()) {

// 加载并初始化实现类

configuration = iterator.next();

}

// 对最后一个configuration类调用configure方法

configuration.configure(configFile);

```

## [Dubbo SPI](https://github.com/apache/dubbo/tree/master/dubbo-common/src/main/java/org/apache/dubbo/common/extension)

Dubbo SPI 的相关逻辑被封装在了 ExtensionLoader类中,它的getExtensionLoader方法用于从缓存中获取与接口对应的ExtensionLoader,若缓存未命中,则创建一个新的实例。Dubbo SPI的核心思想其实很简单:

- 通过配置文件,解耦拓展接口和拓展实现类

- 通过IOC自动注入依赖的拓展实现类对象

- 通过URL参数,在运行时确认真正的自定义拓展类对象

Dubbo SPI 所需的配置文件需放置在 META-INF/dubbo 路径下,配置内容如下(以下demo来自dubbo官方文档)。

```properties

optimusPrime = org.apache.spi.OptimusPrime

bumblebee = org.apache.spi.Bumblebee

```

与 Java SPI 实现类配置不同,Dubbo SPI 是通过键值对的方式进行配置,这样我们可以按需加载指定的实现类。另外在使用时还需要在接口上标注 @SPI 注解。

## [Motan SPI](https://github.com/weibocom/motan/tree/master/motan-core/src/main/java/com/weibo/api/motan/core/extension)

Motan使用SPI机制来实现模块间的访问,基于接口和name来获取实现类,降低了模块间的耦合。

Motan的SPI的实现在 `motan-core/com/weibo/api/motan/core/extension` 中。组织结构如下:

```tex

motan-core/com.weibo.api.motan.core.extension

|-Activation:SPI的扩展功能,例如过滤、排序

|-ActivationComparator:排序比较器

|-ExtensionLoader:核心,主要负责SPI的扫描和加载

|-Scope:模式枚举,单例、多例

|-Spi:注解,作用在接口上,表明这个接口的实现可以通过SPI的形式加载

|-SpiMeta:注解,作用在具体的SPI接口的实现类上,标注该扩展的名称

```

## SpringBoot SPI

Spring 的 SPI 配置文件是一个固定的文件 - `META-INF/spring.factories`,功能上和 JDK 的类似,每个接口可以有多个扩展实现,使用起来非常简单:

```java

// 获取所有factories文件中配置的LoggingSystemFactory

List> factories = SpringFactoriesLoader.loadFactories(LoggingSystemFactory.class, classLoader);

```

下面是一段 Spring Boot 中 spring.factories 的配置

```properties

# Logging Systems

org.springframework.boot.logging.LoggingSystemFactory=\

org.springframework.boot.logging.logback.LogbackLoggingSystem.Factory,\

org.springframework.boot.logging.log4j2.Log4J2LoggingSystem.Factory

# PropertySource Loaders

org.springframework.boot.env.PropertySourceLoader=\

org.springframework.boot.env.PropertiesPropertySourceLoader,\

org.springframework.boot.env.YamlPropertySourceLoader

```

# Redis

**Java类型所占字节数(或bit数)**

| 类型 | 存储(byte) | bit数(bit) | 取值范围 |

| ------- | ---------- | ---------- | ------------------------------------------------------------ |

| int | 4字节 | 4×8位 | 即 (-2)的31次方 ~ (2的31次方) - 1 |

| short | 2字节 | 2×8位 | 即 (-2)的15次方 ~ (2的15次方) - 1 |

| long | 8字节 | 8×8位 | 即 (-2)的63次方 ~ (2的63次方) - 1 |

| byte | 1字节 | 1×8位 | 即 (-2)的7次方 ~ (2的7次方) - 1,-128~127 |

| float | 4字节 | 4×8位 | float 类型的数值有一个后缀 F(例如:3.14F) |

| double | 8字节 | 8×8位 | 没有后缀 F 的浮点数值(例如:3.14)默认为 double |

| boolean | 1字节 | 1×8位 | true、false |

| char | 2字节 | 2×8位 | Java中,只要是字符,不管是数字还是英文还是汉字,都占两个字节 |

**注意**:

- 英文的数字、字母或符号:1个字符 = 1个字节数

- 中文的数字、字母或符号:1个字符 = 2个字节数

- 计算机的基本单位:bit 。一个bit代表一个0或1,1个字节是8个bit

- 1TB=1024GB,1GB=1024MB,1MB=1024KB,1KB=1024B(字节,byte),1B=8b(bit,位)

## 线程模型

Redis内部使用文件事件处理器`File Event Handler`,这个文件事件处理器是单线程的所以Redis才叫做单线程的模型。它采用`I/O`多路复用机制同时监听多个`Socket`,将产生事件的`Socket`压入到内存队列中,事件分派器根据`Socket`上的事件类型来选择对应的事件处理器来进行处理。文件事件处理器包含5个部分:

- **多个Socket**

- **I/O多路复用程序**

- **Scocket队列**

- **文件事件分派器**

- **事件处理器**(连接应答处理器、命令请求处理器、命令回复处理器)

### 通信流程

客户端与redis的一次通信过程:

- **请求类型1**:`客户端发起建立连接的请求`

- 服务端会产生一个`AE_READABLE`事件,`I/O`多路复用程序接收到`server socket`事件后,将该`socket`压入队列中

- 文件事件分派器从队列中获取`socket`,交给连接应答处理器,创建一个可以和客户端交流的`socket01`

- 将`socket01`的`AE_READABLE`事件与命令请求处理器关联

- **请求类型2**:`客户端发起set key value请求`

- `socket01`产生`AE_READABLE`事件,`socket01`压入队列

- 将获取到的`socket01`与命令请求处理器关联

- 命令请求处理器读取`socket01`中的`key value`,并在内存中完成对应的设置

- 将`socket01`的`AE_WRITABLE`事件与命令回复处理器关联

- **请求类型3**:`服务端返回结果`

- `Redis`中的`socket01`会产生一个`AE_WRITABLE`事件,压入到队列中

- 将获取到的`socket01`与命令回复处理器关联

- 回复处理器对`socket01`输入操作结果,如`ok`。之后解除`socket01`的`AE_WRITABLE`事件与命令回复处理器的关联

### 文件事件处理器

- **基于 Reactor 模式开发了自己的网络事件处理器(文件事件处理器,file event handler)**

- 文件事件处理器 **使用 I/O 多路复用(multiplexing)程序来同时监听多个套接字**,并根据套接字目前执行的任务来为套接字关联不同的事件处理器

- 当被监听的套接字准备好执行连接应答(accept)、读取(read)、写入(write)、关闭(close)等操作时, 与操作相对应的文件事件就会产生, 这时文件事件处理器就会调用套接字之前关联好的事件处理器来处理这些事件

- 文件事件处理器以单线程方式运行, 但通过使用 I/O 多路复用程序来监听多个套接字, 文件事件处理器既实现了高性能的网络通信模型, 又可以很好地与 redis 服务器中其他同样以单线程方式运行的模块进行对接, 这保持了 Redis 内部单线程设计的简单性

### I/O多路复用

I/O多路复用的I/O是指网络I/O,多路指多个TCP连接(即socket或者channel),复用指复用一个或几个线程。意思说一个或一组线程处理多个TCP连接。最大优势是减少系统开销小,不必创建过多的进程/线程,也不必维护这些进程/线程。

I/O多路复用使用两个系统调用(select/poll/epoll和recvfrom),blocking I/O只调用了recvfrom;select/poll/epoll 核心是可以同时处理多个connection,而不是更快,所以连接数不高的话,性能不一定比多线程+阻塞I/O好,多路复用模型中,每一个socket,设置为non-blocking,阻塞是被select这个函数block,而不是被socket阻塞的。

**select机制**

**基本原理**

客户端操作服务器时就会产生这三种文件描述符(简称fd):writefds(写)、readfds(读)、和exceptfds(异常)。select会阻塞住监视3类文件描述符,等有数据、可读、可写、出异常 或超时、就会返回;返回后通过遍历fdset整个数组来找到就绪的描述符fd,然后进行对应的I/O操作。

**优点**

- 几乎在所有的平台上支持,跨平台支持性好

**缺点**

- 由于是采用轮询方式全盘扫描,会随着文件描述符FD数量增多而性能下降

- 每次调用 select(),需要把 fd 集合从用户态拷贝到内核态,并进行遍历(消息传递都是从内核到用户空间)

- 默认单个进程打开的FD有限制是1024个,可修改宏定义,但是效率仍然慢。

**poll机制**

基本原理与select一致,也是轮询+遍历;唯一的区别就是poll没有最大文件描述符限制(使用链表的方式存储fd)。

**epoll机制**

**基本原理**

没有fd个数限制,用户态拷贝到内核态只需要一次,使用时间通知机制来触发。通过epoll_ctl注册fd,一旦fd就绪就会通过callback回调机制来激活对应fd,进行相关的io操作。epoll之所以高性能是得益于它的三个函数:

- `epoll_create()`:系统启动时,在Linux内核里面申请一个B+树结构文件系统,返回epoll对象,也是一个fd

- `epoll_ctl()`:每新建一个连接,都通过该函数操作epoll对象,在这个对象里面修改添加删除对应的链接fd, 绑定一个callback函数

- `epoll_wait()`:轮训所有的callback集合,并完成对应的IO操作

**优点**

- 没fd这个限制,所支持的FD上限是操作系统的最大文件句柄数,1G内存大概支持10万个句柄

- 效率提高,使用回调通知而不是轮询的方式,不会随着FD数目的增加效率下降

- 内核和用户空间mmap同一块内存实现(mmap是一种内存映射文件方法,即将一个文件或其它对象映射到进程的地址空间)

例子:100万个连接,里面有1万个连接是活跃,我们可以对比 select、poll、epoll 的性能表现:

- `select`:不修改宏定义默认是1024,则需要100w/1024=977个进程才可以支持 100万连接,会使得CPU性能特别的差

- `poll`: 没有最大文件描述符限制,100万个链接则需要100w个fd,遍历都响应不过来了,还有空间的拷贝消耗大量资源

- `epoll`: 请求进来时就创建fd并绑定一个callback,主需要遍历1w个活跃连接的callback即可,即高效又不用内存拷贝

### 执行效率高

**Redis是单线程模型为什么效率还这么高?**

- `纯内存操作`:数据存放在内存中,内存的响应时间大约是100纳秒,这是Redis每秒万亿级别访问的重要基础

- `非阻塞的I/O多路复用机制`:Redis采用epoll做为I/O多路复用技术的实现,再加上Redis自身的事件处理模型将epoll中的连接,读写,关闭都转换为了时间,不在I/O上浪费过多的时间

- `C语言实现`:距离操作系统更近,执行速度会更快

- `单线程避免切换开销`:单线程避免了多线程上下文切换的时间开销,预防了多线程可能产生的竞争问题

## 数据类型

在 Redis 中,常用的 5 种数据类型和应用场景如下:

- **String:** 缓存、计数器、分布式锁等

- **List:** 链表、队列、微博关注人时间轴列表等

- **Hash:** 用户信息、Hash 表等

- **Set:** 去重、赞、踩、共同好友等

- **Zset:** 访问量排行榜、点击量排行榜等

### String(字符串)

String 数据结构是简单的 key-value 类型,value 不仅可以是 String,也可以是数字(当数字类型用 Long 可以表示的时候encoding 就是整型,其他都存储在 sdshdr 当做字符串)。

### Hash(字典)

在 Memcached 中,我们经常将一些结构化的信息打包成 hashmap,在客户端序列化后存储为一个字符串的值(一般是 JSON 格式),比如用户的昵称、年龄、性别、积分等。这时候在需要修改其中某一项时,通常需要将字符串(JSON)取出来,然后进行反序列化,修改某一项的值,再序列化成字符串(JSON)存储回去。简单修改一个属性就干这么多事情,消耗必定是很大的,也不适用于一些可能并发操作的场合(比如两个并发的操作都需要修改积分)。而 Redis 的 Hash 结构可以使你像在数据库中 Update 一个属性一样只修改某一项属性值。

- 存储、读取、修改用户属性

**实战场景**

- 缓存: 经典使用场景,把常用信息,字符串,图片或者视频等信息放到redis中,redis作为缓存层,mysql做持久化层,降低mysql的读写压力

- 计数器:redis是单线程模型,一个命令执行完才会执行下一个,同时数据可以一步落地到其他的数据源

- session:常见方案spring session + redis实现session共享

### List(列表)

List 说白了就是链表(redis 使用双端链表实现的 List),相信学过数据结构知识的人都应该能理解其结构。使用 List 结构,我们可以轻松地实现最新消息排行等功能(比如新浪微博的 TimeLine )。List 的另一个应用就是消息队列,可以利用 List 的 *PUSH 操作,将任务存在 List 中,然后工作线程再用 POP 操作将任务取出进行执行。Redis 还提供了操作 List 中某一段元素的 API,你可以直接查询,删除 List 中某一段的元素。

- 微博 TimeLine

- 消息队列

使用列表的技巧

- lpush+lpop=Stack(栈)

- lpush+rpop=Queue(队列)

- lpush+ltrim=Capped Collection(有限集合)

- lpush+brpop=Message Queue(消息队列)

实战场景:

- timeline:例如微博的时间轴,有人发布微博,用lpush加入时间轴,展示新的列表信息。

### Set(集合)

Set 就是一个集合,集合的概念就是一堆不重复值的组合。利用 Redis 提供的 Set 数据结构,可以存储一些集合性的数据。比如在微博应用中,可以将一个用户所有的关注人存在一个集合中,将其所有粉丝存在一个集合。因为 Redis 非常人性化的为集合提供了求交集、并集、差集等操作,那么就可以非常方便的实现如共同关注、共同喜好、二度好友等功能,对上面的所有集合操作,你还可以使用不同的命令选择将结果返回给客户端还是存集到一个新的集合中。

- 共同好友、二度好友

- 利用唯一性,可以统计访问网站的所有独立 IP

- 好友推荐的时候,根据 tag 求交集,大于某个 threshold 就可以推荐

实战场景;

- 标签(tag),给用户添加标签,或者用户给消息添加标签,这样有同一标签或者类似标签的可以给推荐关注的事或者关注的人

- 点赞,或点踩,收藏等,可以放到set中实现

### Sorted Set(有序集合)

和Sets相比,Sorted Sets是将 Set 中的元素增加了一个权重参数 score,使得集合中的元素能够按 score 进行有序排列,比如一个存储全班同学成绩的 Sorted Sets,其集合 value 可以是同学的学号,而 score 就可以是其考试得分,这样在数据插入集合的时候,就已经进行了天然的排序。另外还可以用 Sorted Sets 来做带权重的队列,比如普通消息的 score 为1,重要消息的 score 为2,然后工作线程可以选择按 score 的倒序来获取工作任务。让重要的任务优先执行。

- 带有权重的元素,比如一个游戏的用户得分排行榜

- 比较复杂的数据结构,一般用到的场景不算太多

实战场景:

- 排行榜:有序集合经典使用场景。例如小说视频等网站需要对用户上传的小说视频做排行榜,榜单可以按照用户关注数,更新时间,字数等打分,做排行。

## 特殊数据结构

### HyperLogLog(基数统计)

HyperLogLog 主要的应用场景就是进行基数统计。实际上不会存储每个元素的值,它使用的是概率算法,通过存储元素的hash值的第一个1的位置,来计算元素数量。HyperLogLog 可用极小空间完成独立数统计。命令如下:

| 命令 | 作用 |

| ----------------------------- | ----------------------- |

| pfadd key element ... | 将所有元素添加到key中 |

| pfcount key | 统计key的估算值(不精确) |

| pgmerge new_key key1 key2 ... | 合并key至新key |

**应用案例**

如何统计 Google 主页面每天被多少个不同的账户访问过?

对于 Google 这种访问量巨大的网页而言,其实统计出有十亿的访问量或十亿零十万的访问量其实是没有太多的区别的,因此,在这种业务场景下,为了节省成本,其实可以只计算出一个大概的值,而没有必要计算出精准的值。

对于上面的场景,可以使用`HashMap`、`BitMap`和`HyperLogLog`来解决。对于这三种解决方案,这边做下对比:

- `HashMap`:算法简单,统计精度高,对于少量数据建议使用,但是对于大量的数据会占用很大内存空间

- `BitMap`:位图算法,具体内容可以参考我的这篇,统计精度高,虽然内存占用要比`HashMap`少,但是对于大量数据还是会占用较大内存

- `HyperLogLog`:存在一定误差,占用内存少,稳定占用 12k 左右内存,可以统计 2^64 个元素,对于上面举例的应用场景,建议使用

### Geo(地理空间信息)

Geo主要用于存储地理位置信息,并对存储的信息进行操作(添加、获取、计算两位置之间距离、获取指定范围内位置集合、获取某地点指定范围内集合)。Redis支持将Geo信息存储到有序集合(zset)中,再通过Geohash算法进行填充。命令如下:

| 命令 | 作用 |

| ------------------------------------ | ------------------------------------------------------------ |

| geoadd key latitude longitude member | 添加成员位置(纬度、经度、名称)到key中 |

| geopos key member ... | 获取成员geo坐标 |

| geodist key member1 member2 [unit] | 计算成员位置间距离。若两个位置之间的其中一个不存在, 那返回空值 |

| georadius | 基于经纬度坐标范围查询 |

| georadiusbymember | 基于成员位置范围查询 |

| geohash | 计算经纬度hash |

**GEORADIUS**

```properties

GEORADIUS key longitude latitude radius m|km|ft|mi [WITHCOORD] [WITHDIST] [WITHHASH] [COUNT count]

```

以给定的经纬度为中心, 返回键包含的位置元素当中, 与中心的距离不超过给定最大距离的所有位置元素。范围可以使用以下其中一个单位:

- **m** 表示单位为米

- **km** 表示单位为千米

- **mi** 表示单位为英里

- **ft** 表示单位为英尺

在给定以下可选项时, 命令会返回额外的信息:

- `WITHDIST`: 在返回位置元素的同时, 将位置元素与中心之间的距离也一并返回。 距离单位和范围单位保持一致

- `WITHCOORD`: 将位置元素的经度和维度也一并返回

- `WITHHASH`: 以 52 位有符号整数的形式, 返回位置元素经过原始 geohash 编码的有序集合分值。 这个选项主要用于底层应用或者调试, 实际中的作用并不大

命令默认返回未排序的位置元素。 通过以下两个参数, 用户可以指定被返回位置元素的排序方式:

- `ASC`: 根据中心的位置, 按照从近到远的方式返回位置元素

- `DESC`: 根据中心的位置, 按照从远到近的方式返回位置元素

在默认情况下, GEORADIUS 命令会返回所有匹配的位置元素。 虽然用户可以使用 **COUNT ``** 选项去获取前 N 个匹配元素, 但是因为命令在内部可能会需要对所有被匹配的元素进行处理, 所以在对一个非常大的区域进行搜索时, 即使只使用 `COUNT` 选项去获取少量元素, 命令的执行速度也可能会非常慢。 但是从另一方面来说, 使用 `COUNT` 选项去减少需要返回的元素数量, 对于减少带宽来说仍然是非常有用的。

### Pub/Sub(发布订阅)

发布订阅类似于广播功能。redis发布订阅包括 发布者、订阅者、Channel。常用命令如下:

| 命令 | 作用 | 时间复杂度 |

| ----------------------- | ---------------------------------- | ------------------------------------------------------------ |

| subscribe channel | 订阅一个频道 | O(n) |

| unsubscribe channel ... | 退订一个/多个频道 | O(n) |

| publish channel msg | 将信息发送到指定的频道 | O(n+m),n 是频道 channel 的订阅者数量, M 是使用模式订阅(subscribed patterns)的客户端的数量 |

| pubsub CHANNELS | 查看订阅与发布系统状态(多种子模式) | O(n) |

| psubscribe | 订阅多个频道 | O(n) |

| unsubscribe | 退订多个频道 | O(n) |

### Bitmap(位图)

Bitmap就是位图,其实也就是字节数组(byte array),用一串连续的2进制数字(0或1)表示,每一位所在的位置为偏移(offset),位图就是用每一个二进制位来存放或者标记某个元素对应的值。通常是用来判断某个数据存不存在的,因为是用bit为单位来存储所以Bitmap本身会极大的节省储存空间。常用命令如下:

| 命令 | 作用 | 时间复杂度 |

| --------------------------- | --------------------------------------------------- | ---------- |

| setbit key offset val | 给指定key的值的第offset赋值val | O(1) |

| getbit key offset | 获取指定key的第offset位 | O(1) |

| bitcount key start end | 返回指定key中[start,end]中为1的数量 | O(n) |

| bitop operation destkey key | 对不同的二进制存储数据进行位运算(AND、OR、NOT、XOR) | O(n) |

**应用案例**

有1亿用户,5千万登陆用户,那么统计每日用户的登录数。每一位标识一个用户ID,当某个用户访问我们的网站就在Bitmap中把标识此用户的位设置为1。使用set集合和Bitmap存储的对比:

| 数据类型 | 每个 userid 占用空间 | 需要存储的用户量 | 全部占用内存量 |

| -------- | ------------------------------------------------------------ | ---------------- | ---------------------------- |

| set | 32位也就是4个字节(假设userid用的是整型,实际很多网站用的是长整型) | 50,000,000 | 32位 * 50,000,000 = 200 MB |

| Bitmap | 1 位(bit) | 100,000,000 | 1 位 * 100,000,000 = 12.5 MB |

**应用场景**

- 用户在线状态

- 用户签到状态

- 统计独立用户

### BloomFilter(布隆过滤)

当一个元素被加入集合时,通过K个散列函数将这个元素映射成一个位数组中的K个点(使用多个哈希函数对**元素key (bloom中不存value)** 进行哈希,算出一个整数索引值,然后对位数组长度进行取模运算得到一个位置,每个无偏哈希函数都会得到一个不同的位置),把它们置为1。检索时,我们只要看看这些点是不是都是1就(大约)知道集合中有没有它了:

- 如果这些点有任何一个为0,则被检元素一定不在

- 如果都是1,并不能完全说明这个元素就一定存在其中,有可能这些位置为1是因为其他元素的存在,这就是布隆过滤器会出现误判的原因

**应用场景**

- **解决缓存穿透**:事先把存在的key都放到redis的**Bloom Filter** 中,他的用途就是存在性检测,如果 BloomFilter 中不存在,那么数据一定不存在;如果 BloomFilter 中存在,实际数据也有可能会不存

- **黑名单校验**:假设黑名单的数量是数以亿计的,存放起来就是非常耗费存储空间的,布隆过滤器则是一个较好的解决方案。把所有黑名单都放在布隆过滤器中,再收到邮件时,判断邮件地址是否在布隆过滤器中即可

- **Web拦截器**:用户第一次请求,将请求参数放入布隆过滤器中,当第二次请求时,先判断请求参数是否被布隆过滤器命中,从而提高缓存命中率

#### 基于Bitmap数据结构

```java

import com.google.common.base.Preconditions;

import org.springframework.data.redis.core.RedisTemplate;

import org.springframework.stereotype.Service;

import javax.annotation.Resource;

import java.util.Collection;

import java.util.Map;

import java.util.concurrent.TimeUnit;

@Service

public class RedisService {

@Resource

private RedisTemplate redisTemplate;

/**

* 根据给定的布隆过滤器添加值

*/

public void addByBloomFilter(BloomFilterHelper bloomFilterHelper, String key, T value) {

Preconditions.checkArgument(bloomFilterHelper != null, "bloomFilterHelper不能为空");

int[] offset = bloomFilterHelper.murmurHashOffset(value);

for (int i : offset) {

redisTemplate.opsForValue().setBit(key, i, true);

}

}

/**

* 根据给定的布隆过滤器判断值是否存在

*/

public boolean includeByBloomFilter(BloomFilterHelper bloomFilterHelper, String key, T value) {

Preconditions.checkArgument(bloomFilterHelper != null, "bloomFilterHelper不能为空");

int[] offset = bloomFilterHelper.murmurHashOffset(value);

for (int i : offset) {

if (!redisTemplate.opsForValue().getBit(key, i)) {

return false;

}

}

return true;

}

}

```

#### 基于RedisBloom模块

RedisBloom模块提供了四种数据类型:

- **Bloom Filter (布隆过滤器)**

- **Cuckoo Filter(布谷鸟过滤器)**

- **Count-Mins-Sketch**

- **Top-K**

`Bloom Filter` 和 `Cuckoo` 用于确定(以给定的确定性)集合中是否存在某项。使用 `Count-Min Sketch` 来估算子线性空间中的项目数,使用 `Top-K` 维护K个最频繁项目的列表。

```shell

# 1.git 下载

[root@test ~]# git clone https://github.com/RedisBloom/RedisBloom.git

[root@test ~]# cd redisbloom

[root@test ~]# make

# 2.wget 下载

[root@test ~]# wget https://github.com/RedisBloom/RedisBloom/archive/v2.0.3.tar.gz

[root@test ~]# tar -zxvf RedisBloom-2.0.3.tar.gz

[root@test ~]# cd RedisBloom-2.0.3/

[root@test ~]# make

# 3.修改Redis Conf

[root@test ~]#vim /etc/redis.conf

# 在文件中添加下行

loadmodule /root/RedisBloom-2.0.3/redisbloom.so

# 4.启动Redis server

[root@test ~]# /redis-server /etc/redis.conf

# 或者启动服务时加载os文件

[root@test ~]# /redis-server /etc/redis.conf --loadmodule /root/RedisBloom/redisbloom.so

# 5.测试RedisBloom

[root@test ~]# redis-cli

127.0.0.1:6379> bf.add bloomFilter foo

127.0.0.1:6379> bf.exists bloomFilter foo

127.0.0.1:6379> cf.add cuckooFilter foo

127.0.0.1:6379> cf.exists cuckooFilter foo

```

## 底层数据结构

当然是为了追求速度,不同数据类型使用不同的数据结构速度才得以提升。每种数据类型都有一种或者多种数据结构来支撑,底层数据结构有 6 种。

### SDS(简单动态字符)

C 语言字符串结构与 SDS 字符串结构对比图如上所示:

- SDS 中 len 保存这字符串的长度,O(1) 时间复杂度查询字符串长度信息

- 空间预分配:SDS 被修改后,程序不仅会为 SDS 分配所需要的必须空间,还会分配额外的未使用空间

- 惰性空间释放:当对 SDS 进行缩短操作时,程序并不会回收多余的内存空间,而是使用 free 字段将这些字节数量记录下来不释放,后面如果需要 append 操作,则直接使用 free 中未使用的空间,减少了内存的分配

### hash表(字典)

Redis 整体就是一个 哈希表来保存所有的键值对,无论数据类型是 5 种的任意一种。哈希表,本质就是一个数组,每个元素被叫做哈希桶,不管什么数据类型,每个桶里面的 entry 保存着实际具体值的指针。

整个数据库就是一个全局哈希表,而哈希表的时间复杂度是 O(1),只需要计算每个键的哈希值,便知道对应的哈希桶位置,定位桶里面的 entry 找到对应数据,这个也是 Redis 快的原因之一。

**那 Hash 冲突怎么办?**

当写入 Redis 的数据越来越多的时候,哈希冲突不可避免,会出现不同的 key 计算出一样的哈希值。Redis 通过链式哈希解决冲突:也就是同一个 桶里面的元素使用链表保存。但是当链表过长就会导致查找性能变差可能,所以 Redis 为了追求快,使用了两个全局哈希表。用于 rehash 操作,增加现有的哈希桶数量,减少哈希冲突。开始默认使用 hash 表 1 保存键值对数据,哈希表 2 此刻没有分配空间。

### linkedList(双端列表)

后续版本对列表数据结构进行了改造,使用 quicklist 代替了 ziplist 和 linkedlist。quicklist 是 ziplist 和 linkedlist 的混合体,它将 linkedlist 按段切分,每一段使用 ziplist 来紧凑存储,多个 ziplist 之间使用双向指针串接起来。这也是为何 Redis 快的原因,不放过任何一个可以提升性能的细节。

### zipList(压缩列表)

压缩列表是 List 、hash、 sorted Set 三种数据类型底层实现之一。当一个列表只有少量数据的时候,并且每个列表项要么就是小整数值,要么就是长度比较短的字符串,那么 Redis 就会使用压缩列表来做列表键的底层实现。

ziplist 是由一系列特殊编码的连续内存块组成的顺序型的数据结构,ziplist 中可以包含多个 entry 节点,每个节点可以存放整数或者字符串。ziplist 在表头有三个字段 zlbytes、zltail 和 zllen,分别表示列表占用字节数、列表尾的偏移量和列表中的 entry 个数;压缩列表在表尾还有一个 zlend,表示列表结束。

```go

struct ziplist {

int32 zlbytes; // 整个压缩列表占用字节数

int32 zltail_offset; // 最后一个元素距离压缩列表起始位置的偏移量,用于快速定位到最后一个节点

int16 zllength; // 元素个数

T[] entries; // 元素内容列表,挨个挨个紧凑存储

int8 zlend; // 标志压缩列表的结束,值恒为 0xFF

}

```

如果我们要查找定位第一个元素和最后一个元素,可以通过表头三个字段的长度直接定位,复杂度是 O(1)。而查找其他元素时,就没有这么高效了,只能逐个查找,此时的复杂度就是 O(N)。

### skipList(跳跃表)

sorted set 类型的排序功能便是通过「跳跃列表」数据结构来实现。跳跃表(skiplist)是一种有序数据结构,它通过在每个节点中维持多个指向其他节点的指针,从而达到快速访问节点的目的。

跳跃表支持平均 O(logN)、最坏 O(N)复杂度的节点查找,还可以通过顺序性操作来批量处理节点。跳表在链表的基础上,增加了多层级索引,通过索引位置的几个跳转,实现数据的快速定位。

### intset(整数数组)

当一个集合只包含整数值元素,并且这个集合的元素数量不多时,Redis 就会使用整数集合作为集合键的底层实现,节省内存。结构如下:

```go

typedef struct intset{

//编码方式

uint32_t encoding;

//集合包含的元素数量

uint32_t length;

//保存元素的数组

int8_t contents[];

}intset;

```

contents 数组是整数集合的底层实现:整数集合的每个元素都是 contents 数组的一个数组项(item),各个项在数组中按值的大小从小到大有序地排列,并且数组中不包含任何重复项。length 属性记录了整数集合包含的元素数量,也即是 contents 数组的长度。

## 持久化机制

通常来说,应该同时使用两种持久化方案,以保证数据安全:

- 如果数据不敏感,且可以从其他地方重新生成,可以关闭持久化

- 如果数据比较重要,且能够承受几分钟的数据丢失,比如缓存等,只需要使用RDB即可

- 如果是用做内存数据,要使用Redis的持久化,建议是RDB和AOF都开启

- 如果只用AOF,优先使用everysec的配置选择,因为它在可靠性和性能之间取了一个平衡

当RDB与AOF两种方式都开启时,Redis会优先使用AOF恢复数据,因为AOF保存的文件比RDB文件更完整

### RDB模式(内存快照)

`RDB`(Redis Database Backup File,**Redis数据备份文件**)持久化方式:是指用数据集快照的方式半持久化模式记录 Redis 数据库的所有键值对,在某个时间点将数据写入一个临时文件,持久化结束后,用这个临时文件替换上次持久化的文件,达到数据恢复。

**优点**

- RDB快照是一个压缩过的非常紧凑的文件。保存着某个时间点的数据集,适合做数据的备份,灾难恢复

- 可最大化Redis的的性能。在保存RDB文件,服务器进程只需要fork一个子进程来完成RDB文件创建,父进程不需要做IO操作

- 与AOF相比,恢复大数据集的时候会更快

**缺点**

- RDB的数据安全性是不如AOF的,保存整个数据集的过程是比繁重的,根据配置可能要几分钟才快照一次,如果服务器宕机,那么就可能丢失几分钟的数据

- Redis数据集较大时,fork的子进程要完成快照会比较耗CPU、耗时

**① 创建**

当 Redis 持久化时,程序会将当前内存中的**数据库状态**保存到磁盘中。创建 RDB 文件主要有两个 Redis 命令:`SAVE` 和 `BGSAVE`。

**② 载入**

服务器在载入 RDB 文件期间,会一直处于**阻塞**状态,直到载入工作完成为止。

#### save同步保存

`save` 命令是同步操作,执行命令时,会 **阻塞** Redis 服务器进程,拒绝客户端发送的命令请求。

具体流程如下:

由于 `save` 命令是同步命令,会占用Redis的主进程。若Redis数据非常多时,`save`命令执行速度会非常慢,阻塞所有客户端的请求。因此很少在生产环境直接使用SAVE 命令,可以使用BGSAVE 命令代替。如果在BGSAVE命令的保存数据的子进程发生错误的时,用 SAVE命令保存最新的数据是最后的手段。

#### bgsave异步保存

`bgsave` 命令是异步操作,执行命令时,子进程执行保存工作,服务器还可以继续让主线程**处理**客户端发送的命令请求。

具体流程如下:

Redis使用Linux系统的`fock()`生成一个子进程来将DB数据保存到磁盘,主进程继续提供服务以供客户端调用。如果操作成功,可以通过客户端命令LASTSAVE来检查操作结果。

#### 自动保存

可通过配置文件对 Redis 进行设置, 让它在“ N 秒内数据集至少有 M 个改动”这一条件被满足时, 自动进行数据集保存操作:

```shell

# RDB自动持久化规则

# 当 900 秒内有至少有 1 个键被改动时,自动进行数据集保存操作

save 900 1

# 当 300 秒内有至少有 10 个键被改动时,自动进行数据集保存操作

save 300 10

# 当 60 秒内有至少有 10000 个键被改动时,自动进行数据集保存操作

save 60 10000

# RDB持久化文件名

dbfilename dump-.rdb

# 数据持久化文件存储目录

dir /var/lib/redis

# bgsave发生错误时是否停止写入,通常为yes

stop-writes-on-bgsave-error yes

# rdb文件是否使用压缩格式

rdbcompression yes

# 是否对rdb文件进行校验和检验,通常为yes

rdbchecksum yes

```

#### 默认配置

RDB 文件默认的配置如下:

```properties

################################ SNAPSHOTTING ################################

#

# Save the DB on disk:

# 在给定的秒数和给定的对数据库的写操作数下,自动持久化操作。

# save

#

save 900 1

save 300 10

save 60 10000

#bgsave发生错误时是否停止写入,一般为yes

stop-writes-on-bgsave-error yes

#持久化时是否使用LZF压缩字符串对象?

rdbcompression yes

#是否对rdb文件进行校验和检验,通常为yes

rdbchecksum yes

# RDB持久化文件名

dbfilename dump.rdb

#持久化文件存储目录

dir ./

```

### AOF模式(日志追加)

AOF(Append Only File,**追加日志文件**)持久化方式:是指所有的命令行记录以 Redis 命令请求协议的格式完全持久化存储保存为 aof 文件。Redis 是先执行命令,把数据写入内存,然后才记录日志。因为该模式是**只追加**的方式,所以没有任何磁盘寻址的开销,所以很快,有点像 Mysql 中的binlog,AOF更适合做热备。

**优点**

- 数据更完整,安全性更高,秒级数据丢失(取决fsync策略,如果是everysec,最多丢失1秒的数据)

- AOF文件是一个只进行追加的日志文件,且写入操作是以Redis协议的格式保存的,内容是可读的,适合误删紧急恢复

**缺点**

- 对于相同的数据集,AOF文件的体积要大于RDB文件,数据恢复也会比较慢

- 根据所使用的fsync策略,AOF的速度可能会慢于RDB。 不过在一般情况下,每秒fsync的性能依然非常高

#### 持久化流程

**① 命令追加**

若 AOF 持久化功能处于打开状态,服务器在执行完一个命令后,会以协议格式将被执行的写命令**追加**到服务器状态的 `aof_buf` 缓冲区的末尾。

**② 文件同步**

服务器每次结束一个事件循环之前,都会调用 `flushAppendOnlyFile` 函数,这个函数会考虑是否需要将 `aof_buf` 缓冲区中的内容**写入和保存**到 AOF 文件里。`flushAppendOnlyFile` 函数执行以下流程:

- WRITE:根据条件,将 aof_buf 中的**缓存**写入到 AOF 文件;

- SAVE:根据条件,调用 fsync 或 fdatasync 函数,将 AOF 文件保存到**磁盘**中。

这个函数是由服务器配置的 `appendfsync` 的三个值:`always、everysec、no` 来影响的,也被称为三种策略:

- **always**:每条**命令**都会 fsync 到硬盘中,这样 redis 的写入数据就不会丢失。

- **everysec**:**每秒**都会刷新缓冲区到硬盘中(默认值)。

- **no**:根据当前**操作系统**的规则决定什么时候刷新到硬盘中,不需要我们来考虑。

**数据加载**

- 创建一个不带网络连接的伪客户端

- 从 AOF 文件中分析并读取出一条写命令

- 使用伪客户端执行被读出的写命令

- 一直执行步骤 2 和 3,直到 AOF 文件中的所有写命令都被**处理完毕**为止

#### 文件重写

**为何需要文件重写**

- 为了解决 AOF 文件**体积膨胀**的问题

- 通过重写创建一个新的 AOF 文件来替代现有的 AOF 文件,新的 AOF 文件不会包含任何浪费空间的冗余命令

**文件重写的实现原理**

- 不需要对现有的 AOF 文件进行任何操作

- 从数据库中直接读取键现在的值

- 用一条命令记录键值对,从而**代替**之前记录这个键值对的多条命令

**后台重写**

为不阻塞父进程,Redis将AOF重写程序放到**子进程**里执行。在子进程执行AOF重写期间,服务器进程需要执行三个流程:

- 执行客户端发来的命令

- 将执行后的写命令追加到 AOF 缓冲区

- 将执行后的写命令追加到 AOF 重写缓冲区

#### 默认配置

AOF 文件默认的配置如下:

```properties

############################## APPEND ONLY MODE ###############################

#开启AOF持久化方式

appendonly no

#AOF持久化文件名

appendfilename "appendonly.aof"

#每秒把缓冲区的数据fsync到磁盘

appendfsync everysec

# appendfsync no

#是否在执行重写时不同步数据到AOF文件

no-appendfsync-on-rewrite no

# 触发AOF文件执行重写的增长率

auto-aof-rewrite-percentage 100

#触发AOF文件执行重写的最小size

auto-aof-rewrite-min-size 64mb

#redis在恢复时,会忽略最后一条可能存在问题的指令

aof-load-truncated yes

#是否打开混合开关

aof-use-rdb-preamble yes

```

## 过期策略

**过期策略用于处理过期缓存数据**。Redis采用过期策略:`惰性删除` + `定期删除`。memcached采用过期策略:`惰性删除`。

### 定时过期

每个设置过期时间的key都需要创建一个定时器,到过期时间就会立即对key进行清除。该策略可以立即清除过期的数据,对内存很友好;但是**会占用大量的CPU资源去处理过期的数据**,从而影响缓存的响应时间和吞吐量。

### 惰性过期

只有当访问一个key时,才会判断该key是否已过期,过期则清除。该策略可以最大化地节省CPU资源,却**对内存非常不友好**。极端情况可能出现大量的过期key没有再次被访问,从而不会被清除,占用大量内存。

### 定期过期

每隔一定的时间,会扫描一定数量的数据库的expires字典中一定数量的key,并清除其中已过期的key。该策略是前两者的一个折中方案。通过调整定时扫描的时间间隔和每次扫描的限定耗时,可以在不同情况下使得CPU和内存资源**达到最优**的平衡效果。expires字典会保存所有设置了过期时间的key的过期时间数据,其中 key 是指向键空间中的某个键的指针,value是该键的毫秒精度的UNIX时间戳表示的过期时间。键空间是指该Redis集群中保存的所有键。

## 淘汰策略

Redis淘汰机制的存在是为了更好的使用内存,用一定的缓存丢失来换取内存的使用效率。当Redis内存快耗尽时,Redis会启动内存淘汰机制,将部分key清掉以腾出内存。当达到内存使用上限超过`maxmemory`时,可在配置文件`redis.conf`中指定 `maxmemory-policy` 的清理缓存方式。

```properties

# 配置最大内存限制

maxmemory 1000mb

# 配置淘汰策略

maxmemory-policy volatile-lru

```

### LRU(最近最少使用)

- `volatile-lru`:从已设置过期时间的key中,挑选**最近最少使用(最长时间没有使用)**的key进行淘汰

- `allkeys-lru`:从所有key中,挑选**最近最少使用**的数据淘汰

### LFU(最近最不经常使用)

- `volatile-lfu`:从已设置过期时间的key中,挑选**最近最不经常使用(使用次数最少)**的key进行淘汰

- `allkeys-lfu`:从所有key中,选择某段时间内内**最近最不经常使用**的数据淘汰

### Random(随机淘汰)

- `volatile-random`:从已设置过期时间的key中,**任意选择**数据淘汰

- `allkeys-random`:从所有key中,**任意选择数**据淘汰

### TTL(过期时间)

- `volatile-ttl`:从已设置过期时间的key中,挑选**将要过期**的数据淘汰

- `allkeys-random`:从所有key中,**任意选择数**据淘汰

### No-Enviction(驱逐)

- `noenviction(驱逐)`:当达到最大内存时直接返回错误,不覆盖或逐出任何数据

## 部署架构

### 单节点(Single)

**优点**

- 架构简单,部署方便

- 高性价比:缓存使用时无需备用节点(单实例可用性可以用 supervisor 或 crontab 保证),当然为了满足业务的高可用性,也可以牺牲一个备用节点,但同时刻只有一个实例对外提供服务

- 高性能

**缺点**

- 不保证数据的可靠性

- 在缓存使用,进程重启后,数据丢失,即使有备用的节点解决高可用性,但是仍然不能解决缓存预热问题,因此不适用于数据可靠性要求高的业务

- 高性能受限于单核CPU的处理能力(Redis是单线程机制),CPU为主要瓶颈,所以适合操作命令简单,排序/计算较少场景

### 主从复制(Replication)

**基本原理**

主从复制模式中包含一个主数据库实例(Master)与一个或多个从数据库实例(Slave),如下图:

.png)

优缺点.png)

### 哨兵(Sentinel)

Sentinel主要作用如下:

- **监控**:Sentinel 会不断的检查主服务器和从服务器是否正常运行

- **通知**:当被监控的某个Redis服务器出现问题,Sentinel通过API脚本向管理员或者其他的应用程序发送通知

- **自动故障转移**:当主节点不能正常工作时,Sentinel会开始一次自动的故障转移操作,它会将与失效主节点是主从关系的其中一个从节点升级为新的主节点,并且将其他的从节点指向新的主节点

.png)

优缺点.png)

### 集群(Cluster)

.png)

优缺点.png)

## 环境搭建

**Redis安装及配置**

Redis的安装十分简单,打开redis的官网 [http://redis.io](http://redis.io/) 。

- 下载一个最新版本的安装包,如 redis-version.tar.gz

- 解压 `tar zxvf redis-version.tar.gz`

- 执行 make (执行此命令可能会报错,例如确实gcc,一个个解决即可)

如果是 mac 电脑,安装redis将十分简单执行`brew install redis`即可。安装好redis之后,我们先不慌使用,先进行一些配置。打开`redis.conf`文件,我们主要关注以下配置:

```shell

port 6379 # 指定端口为 6379,也可自行修改

daemonize yes # 指定后台运行

```

### 单节点(Single)

安装好redis之后,我们来运行一下。启动redis的命令为 :

```shell

$ /bin/redis-server path/to/redis.config

```

假设我们没有配置后台运行(即:daemonize no),那么我们会看到如下启动日志:

```shell

93825:C 20 Jan 2019 11:43:22.640 # oO0OoO0OoO0Oo Redis is starting oO0OoO0OoO0Oo

93825:C 20 Jan 2019 11:43:22.640 # Redis version=5.0.3, bits=64, commit=00000000, modified=0, pid=93825, just started

93825:C 20 Jan 2019 11:43:22.640 # Configuration loaded

93825:S 20 Jan 2019 11:43:22.641 * Increased maximum number of open files to 10032 (it was originally set to 256).

_._

_.-``__ ''-._

_.-`` `. `_. ''-._ Redis 5.0.3 (00000000/0) 64 bit

.-`` .-```. ```\/ _.,_ ''-._

( ' , .-` | `, ) Running in standalone mode

|`-._`-...-` __...-.``-._|'` _.-'| Port: 6380

| `-._ `._ / _.-' | PID: 93825

`-._ `-._ `-./ _.-' _.-'

|`-._`-._ `-.__.-' _.-'_.-'|

| `-._`-._ _.-'_.-' | http://redis.io

`-._ `-._`-.__.-'_.-' _.-'

|`-._`-._ `-.__.-' _.-'_.-'|

| `-._`-._ _.-'_.-' |

`-._ `-._`-.__.-'_.-' _.-'

`-._ `-.__.-' _.-'

`-._ _.-'

`-.__.-'

```

### 主从复制(Replication)

Redis主从配置非常简单,过程如下(演示情况下主从配置在一台电脑上):

**第一步**:复制两个redis配置文件(启动两个redis,只需要一份redis程序,两个不同的redis配置文件即可)

```shell

mkdir redis-master-slave

cp path/to/redis/conf/redis.conf path/to/redis-master-slave master.conf

cp path/to/redis/conf/redis.conf path/to/redis-master-slave slave.conf

```

**第二步**:修改配置

```shell

## master.conf

port 6379

## master.conf

port 6380

slaveof 127.0.0.1 6379

```

**第三步**:分别启动两个redis

```shell

redis-server path/to/redis-master-slave/master.conf

redis-server path/to/redis-master-slave/slave.conf

```

启动之后,打开两个命令行窗口,分别执行 `telnet localhost 6379` 和 `telnet localhost 6380`,然后分别在两个窗口中执行 `info` 命令,可以看到:

```shell

# Replication

role:master

# Replication

role:slave

master_host:127.0.0.1

master_port:6379

```

主从配置没问题。然后在master 窗口执行 set 之后,到slave窗口执行get,可以get到,说明主从同步成功。这时,我们如果在slave窗口执行 set ,会报错:

```shell

-READONLY You can't write against a read only replica.

```

因为从节点是只读的。

### 哨兵(Sentinel)

Sentinel是用来监控主从节点的健康情况。客户端连接Redis主从的时候,先连接Sentinel,Sentinel会告诉客户端主Redis的地址是多少,然后客户端连接上Redis并进行后续的操作。当主节点挂掉的时候,客户端就得不到连接了因而报错了,客户端重新向Sentinel询问主master的地址,然后客户端得到了[新选举出来的主Redis],然后又可以愉快的操作了。

**哨兵sentinel配置**

为了说明sentinel的用处,我们做个试验。配置3个redis(1主2从),1个哨兵。步骤如下:

```shell

mkdir redis-sentinel

cd redis-sentinel

cp redis/path/conf/redis.conf path/to/redis-sentinel/redis01.conf

cp redis/path/conf/redis.conf path/to/redis-sentinel/redis02.conf

cp redis/path/conf/redis.conf path/to/redis-sentinel/redis03.conf

touch sentinel.conf

```

上我们创建了 3个redis配置文件,1个哨兵配置文件。我们将 redis01设置为master,将redis02,redis03设置为slave。

```shell

vim redis01.conf

port 63791

vim redis02.conf

port 63792

slaveof 127.0.0.1 63791

vim redis03.conf

port 63793

slaveof 127.0.0.1 63791

vim sentinel.conf

daemonize yes

port 26379

sentinel monitor mymaster 127.0.0.1 63793 1 # 下面解释含义

```

上面的主从配置都熟悉,只有哨兵配置 sentinel.conf,需要解释一下:

```shell

mymaster # 为主节点名字,可以随便取,后面程序里边连接的时候要用到

127.0.0.1 63793 # 为主节点的 ip,port

1 # 后面的数字 1 表示选举主节点的时候,投票数。1表示有一个sentinel同意即可升级为master

```

**启动哨兵**

上面我们配置好了redis主从,1主2从,以及1个哨兵。下面我们分别启动redis,并启动哨兵:

```shell

redis-server path/to/redis-sentinel/redis01.conf

redis-server path/to/redis-sentinel/redis02.conf

redis-server path/to/redis-sentinel/redis03.conf

redis-server path/to/redis-sentinel/sentinel.conf --sentinel

```

启动之后,可以分别连接到 3个redis上,执行info查看主从信息。

**模拟主节点宕机情况**

运行上面的程序(**注意,在实验这个效果的时候,可以将sleep时间加长或者for循环增多,以防程序提前停止,不便看整体效果**),然后将主redis关掉,模拟redis挂掉的情况。现在主redis为redis01,端口为63791

```shell

redis-cli -p 63791 shutdown

```

### 集群(Cluster)

上述所做的这些工作只是保证了数据备份以及高可用,目前为止我们的程序一直都是向1台redis写数据,其他的redis只是备份而已。实际场景中,单个redis节点可能不满足要求,因为:

- 单个redis并发有限

- 单个redis接收所有数据,最终回导致内存太大,内存太大回导致rdb文件过大,从很大的rdb文件中同步恢复数据会很慢

所以需要redis cluster 即redis集群。Redis 集群是一个提供在**多个Redis间节点间共享数据**的程序集。Redis集群并不支持处理多个keys的命令,因为这需要在不同的节点间移动数据,从而达不到像Redis那样的性能,在高负载的情况下可能会导致不可预料的错误。Redis 集群通过分区来提供**一定程度的可用性**,在实际环境中当某个节点宕机或者不可达的情况下继续处理命令.。Redis 集群的优势:

- 自动分割数据到不同的节点上

- 整个集群的部分节点失败或者不可达的情况下能够继续处理命令

为了配置一个redis cluster,我们需要准备至少6台redis,为啥至少6台呢?我们可以在redis的官方文档中找到如下一句话:

> Note that the minimal cluster that works as expected requires to contain at least three master nodes.

因为最小的redis集群,需要至少3个主节点,既然有3个主节点,而一个主节点搭配至少一个从节点,因此至少得6台redis。然而对我来说,就是复制6个redis配置文件。本实验的redis集群搭建依然在一台电脑上模拟。

**配置 redis cluster 集群**

上面提到,配置redis集群需要至少6个redis节点。因此我们需要准备及配置的节点如下:

```shell

# 主:redis01 从 redis02 slaveof redis01

# 主:redis03 从 redis04 slaveof redis03

# 主:redis05 从 redis06 slaveof redis05

mkdir redis-cluster

cd redis-cluster

mkdir redis01 到 redis06 6个文件夹

cp redis.conf 到 redis01 ... redis06

# 修改端口, 分别配置3组主从关系

```

**启动redis集群**

上面的配置完成之后,分别启动6个redis实例。配置正确的情况下,都可以启动成功。然后运行如下命令创建集群:

```shell

redis-5.0.3/src/redis-cli --cluster create 127.0.0.1:6371 127.0.0.1:6372 127.0.0.1:6373 127.0.0.1:6374 127.0.0.1:6375 127.0.0.1:6376 --cluster-replicas 1

```

**注意**,这里使用的是ip:port,而不是 domain:port ,因为我在使用 localhost:6371 之类的写法执行的时候碰到错误:

```shell

ERR Invalid node address specified: localhost:6371

```

执行成功之后,连接一台redis,执行 cluster info 会看到类似如下信息:

```shell

cluster_state:ok

cluster_slots_assigned:16384

cluster_slots_ok:16384

cluster_slots_pfail:0

cluster_slots_fail:0

cluster_known_nodes:6

cluster_size:3

cluster_current_epoch:6

cluster_my_epoch:1

cluster_stats_messages_ping_sent:1515

cluster_stats_messages_pong_sent:1506

cluster_stats_messages_sent:3021

cluster_stats_messages_ping_received:1501

cluster_stats_messages_pong_received:1515

cluster_stats_messages_meet_received:5

cluster_stats_messages_received:3021

```

我们可以看到`cluster_state:ok`,`cluster_slots_ok:16384`,`cluster_size:3`。

## 拓展方案

### 分区(Partitioning)

指在面临**单机**的**存储空间**瓶颈时,即将全部数据分散在多个Redis实例中,每个实例不需要关联,可以是完全独立的。

**使用方式**

- 客户端处理

和传统的数据库分库分表一样,可以从**key**入手,先进行计算,找到对应数据存储的实例在进行操作。

- **范围角度**,比如orderId:1~orderId:1000放入实例1,orderId:1001~orderId:2000放入实例2

- **哈希计算**,就像我们的**hashmap**一样,用hash函数加上位运算或者取模,高级玩法还有一致性Hash等操作,找到对应的实例进行操作

- 使用代理中间件

我们可以开发独立的代理中间件,屏蔽掉处理数据分片的逻辑,独立运行。当然Redis也有优秀的代理中间件,譬如Twemproxy,或者codis,可以结合场景选择是否使用

**缺点**

- **无缘多key操作**,key都不一定在一个实例上,那么多key操作或者多key事务自然是不支持

- **维护成本**,由于每个实例在物理和逻辑上,都属于单独的一个节点,缺乏统一管理

- **灵活性有限**,范围分片还好,比如hash+MOD这种方式,如果想**动态**调整Redis实例的数量,就要考虑大量数据迁移

### 主从(Master-Slave)

分区暂时能解决**单点**无法容纳的**数据量问题**,但是一个Key还是只在一个实例上。主从则将数据从**主节点**同步到**从节点**,然后可做**读写分离**,将读流量均摊在各个从节点,可靠性也能提高。**主从**(Master-Slave)也就是复制(Replication)方式。

**使用方式**

- 作为主节点的Redis实例,并不要求配置任何参数,只需要正常启动

- 作为从节点的实例,使用配置文件或命令方式`REPLICAOF 主节点Host 主节点port`即可完成主从配置

**缺点**

- slave节点都是**只读**的,如果**写流量**大的场景,就有些力不从心

- **故障转移**不友好,主节点挂掉后,写处理就无处安放,需要**手工**的设定新的主节点,如使用`REPLICAOF no one` 晋升为主节点,再梳理其他slave节点的新主配置,相对来说比较麻烦

### 哨兵(Sentinel)

**主从**的手工故障转移,肯定让人很难接受,自然就出现了高可用方案-**哨兵**(Sentinel)。我们可以在主从架构不变的场景,直接加入**Redis Sentinel**,对节点进行**监控**,来完成自动的**故障发现**与**转移**。并且还能够充当**配置提供者**,提供主节点的信息,就算发生了故障转移,也能提供正确的地址。

**使用方式**

**Sentinel**的最小配置,一行即可:

```properties

sentinel monitor <主节点别名> <主节点host> <主节点端口> <票数>

```

只需要配置master即可,然后用``redis-sentinel <配置文件>`` 命令即可启用。哨兵数量建议在三个以上且为奇数。

**使用场景问题**

- 故障转移期间短暂的不可用,但其实官网的例子也给出了`parallel-syncs`参数来指定并行的同步实例数量,以免全部实例都在同步出现整体不可用的情况,相对来说要比手工的故障转移更加方便

- 分区逻辑需要自定义处理,虽然解决了主从下的高可用问题,但是Sentinel并没有提供分区解决方案,还需开发者考虑如何建设

- 既然是还是主从,如果异常的写流量搞垮了主节点,那么自动的“故障转移”会不会变成自动“灾难传递”,即slave提升为Master之后挂掉,又进行提升又被挂掉

### 集群(Cluster)

**Cluster**在分区管理上,使用了“**哈希槽**”(hash slot)这么一个概念,一共有**16384**个槽位,每个实例负责一部分**槽**,通过`CRC16(key)&16383`这样的公式,计算出来key所对应的槽位。

**使用方式**

配置文件

```properties

cluster-enabled yes

cluster-config-file "redis-node.conf"

```

启动命令

```bash

redis-cli --cluster create 127.0.0.1:7000 127.0.0.1:7001 \

127.0.0.1:7002 127.0.0.1:7003 127.0.0.1:7004 127.0.0.1:7005 \

--cluster-replicas 1

```

**存在问题**

- 虽然是对分区良好支持,但也有一些分区的老问题。如如果不在同一个“槽”的数据,是没法使用类似mset的**多键操作**

- 在select命令页有提到, 集群模式下只能使用一个库,虽然平时一般也是这么用的,但是要了解一下

- 运维上也要谨慎,俗话说得好,“**使用越简单底层越复杂**”,启动搭建是很方便,使用时面对带宽消耗,数据倾斜等等具体问题时,还需人工介入,或者研究合适的配置参数

## 常见问题

**题目**:保证Redis 中的 20w 数据都是热点数据 说明是 被频繁访问的数据,并且要保证Redis的内存能够存放20w数据,要计算出Redis内存的大小。

- **保留热点数据:**对于保留 Redis 热点数据来说,我们可以使用 Redis 的内存淘汰策略来实现,可以使用**allkeys-lru淘汰策略,**该淘汰策略是从 Redis 的数据中挑选最近最少使用的数据删除,这样频繁被访问的数据就可以保留下来了

- **保证 Redis 只存20w的数据:**1个中文占2个字节,假如1条数据有100个中文,则1条数据占200字节,20w数据 乘以 200字节 等于 4000 字节(大概等于38M);所以要保证能存20w数据,Redis 需要38M的内存

**题目:MySQL里有2000w数据,redis中只存20w的数据,如何保证redis中的数据都是热点数据?**

限定 Redis 占用的内存,Redis 会根据自身数据淘汰策略,加载热数据到内存。所以,计算一下 20W 数据大约占用的内存,然后设置一下 Redis 内存限制即可。

**题目:假如Redis里面有1亿个key,其中有10w个key是以某个固定的已知的前缀开头的,如果将它们全部找出来?**

使用 keys 指令可以扫出指定模式的 key 列表。对方接着追问:如果这个 Redis 正在给线上的业务提供服务,那使用 keys 指令会有什么问题?这个时候你要回答 Redis 关键的一个特性:Redis 的单线程的。keys 指令会导致线程阻塞一段时间,线上服务会停顿,直到指令执行完毕,服务才能恢复。这个时候可以使用 scan 指令,scan 指令可以无阻塞地提取出指定模式的 key 列表,但是会有一定的重复概率,在客户端做一次去重就可以了,但是整体所花费的时间会比直接用 keys 指令长。

# Kafka

# RocketMQ

RocketMQ 是阿里巴巴开源的分布式消息中间件。支持事务消息、顺序消息、批量消息、定时消息、消息回溯等。它里面有几个区别于标准消息中件间的概念,如Group、Topic、Queue等。系统组成则由Producer、Consumer、Broker、NameServer等。

**功能优势**

- **削峰填谷**:主要解决瞬时写压力大于应用服务能力导致消息丢失、系统奔溃等问题

- **应用解耦**:解决不同重要程度、不同能力级别系统之间依赖导致一死全死

- **提升性能**:当存在一对多调用时,可以发一条消息给消息系统,让消息系统通知相关系统

- **蓄流压测**:线上有些链路不好压测,可以通过堆积一定量消息再放开来压测

- **异步处理**:不需要同步执行的远程调用可以有效提高响应时间

## 架构设计

### 部署模型

### 角色

#### Broker

- 理解成RocketMQ本身

- Broker主要用于Producer和Consumer接收和发送消息

- Broker会定时向NameSrver提交自己的信息

- 是消息中间件的消息存储、转发服务器

- 每个Broker节点在启动时都会遍历NameServer列表,与每个NameServer建立长连接,注册自己的信息,之后定时上报

#### NameServer

- 理解成Zookeeper的效果,只是他没用zk,而是自己写了个NameServer来替代zk

- 底层由Netty实现,提供了路由管理、服务注册、服务发现的功能,是一个无状态节点

- NameServer是服务发现者,集群中各个角色(Producer、Broker、Consumer等)都需要定时向NameServer上报自己的状态,以便互相发现彼此,超时不上报的话,NameServer会把它从列表中剔除

- NameServer可以部署多个,当多个NameServer存在的时候,其他角色同时向他们上报信息,以保证高可用,

- NameServer集群间互不通信,没有主备的概念

- NameServer内存式存储,NameServer中的Broker、Topic等信息默认不会持久化,所以他是无状态节点

#### Producer

- 消息的生产者

- 随机选择其中一个NameServer节点建立长连接,获得Topic路由信息(包括Topic下的Queue,这些Queue分布在哪些Broker上等等)

- 接下来向提供Topic服务的Master建立长连接(因为RocketMQ只有Master才能写消息),且定时向Master发送心跳

#### Consumer

- 消息的消费者

- 通过NameServer集群获得Topic的路由信息,连接到对应的Broker上消费消息

- 由于Master和Slave都可以读取消息,因此Consumer会与Master和Slave都建立连接进行消费消息

### 核心流程

- Broker都注册到Nameserver上

- Producer发消息的时候会从Nameserver上获取发消息的Topic信息

- Producer向提供服务的所有Master建立长连接,且定时向Master发送心跳

- Consumer通过NameServer集群获得Topic的路由信息

- Consumer会与所有的Master和所有的Slave都建立连接进行监听新消息

### 实现原理

RocketMQ由NameServer注册中心集群、Producer生产者集群、Consumer消费者集群和若干Broker(RocketMQ进程)组成,它的架构原理是这样的:

- Broker在启动的时候去向所有的NameServer注册,并保持长连接,每30s发送一次心跳

- Producer在发送消息的时候从NameServer获取Broker服务器地址,根据负载均衡算法选择一台服务器来发送消息

- Conusmer消费消息的时候同样从NameServer获取Broker地址,然后主动拉取消息来消费

## 核心概念

### Message(消息)

消息载体。Message发送或者消费的时候必须指定Topic。Message有一个可选的Tag项用于过滤消息,还可以添加额外的键值对。

### Topic(主题)

消息的逻辑分类,发消息之前必须要指定一个topic才能发,就是将这条消息发送到这个topic上。消费消息的时候指定这个topic进行消费。就是逻辑分类。

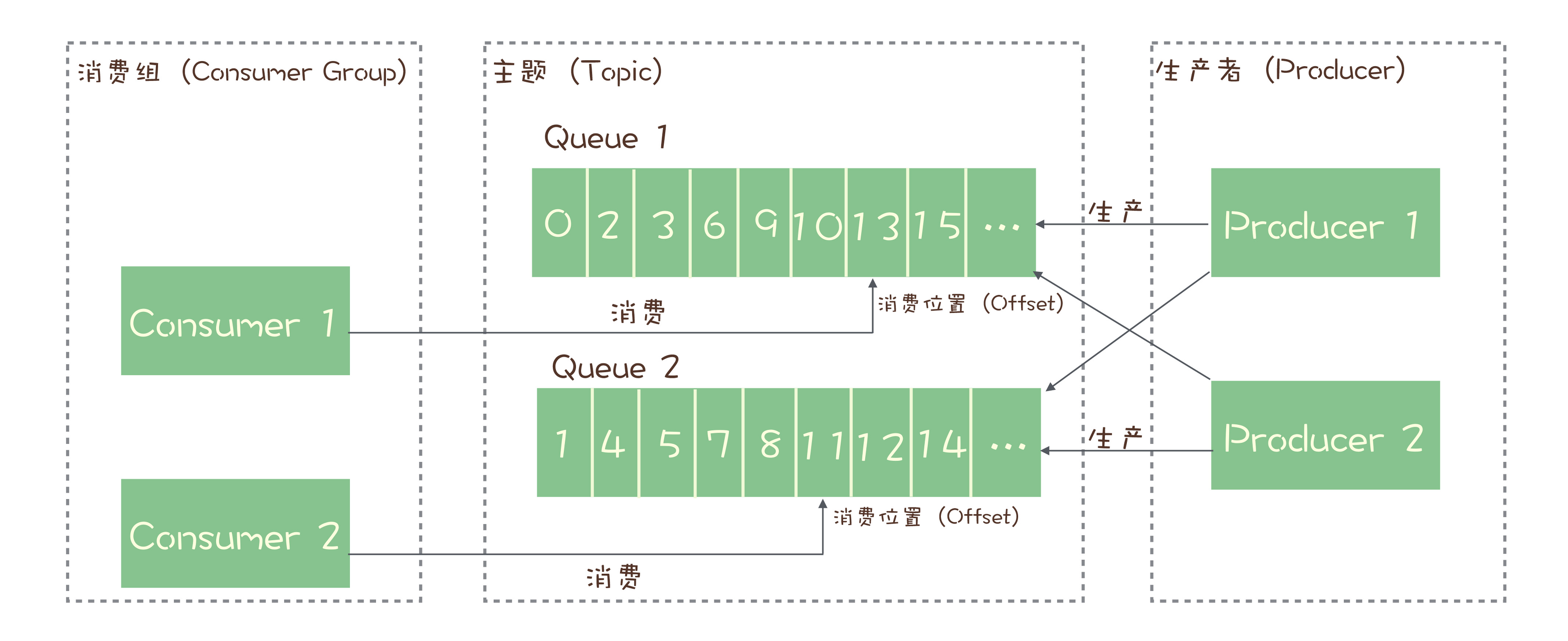

### Queue(队列)

1个Topic会被分为N个Queue,数量是可配置的。message本身其实是存储到queue上的,消费者消费的也是queue上的消息。多说一嘴,比如1个topic4个queue,有5个Consumer都在消费这个topic,那么会有一个consumer浪费掉了,因为负载均衡策略,每个consumer消费1个queue,5>4,溢出1个,这个会不工作。

### Tag(标签)

Tag 是 Topic 的进一步细分,顾名思义,标签。每个发送的时候消息都能打tag,消费的时候可以根据tag进行过滤,选择性消费。

### 消费模式(Message Model)

消息模型:集群(Clustering)和广播(Broadcasting)

#### 集群模式(Clustering)

生产者往某个队列里面发送消息,一个队列可以存储多个生产者的消息,一个队列也可以有多个消费者,但是消费者之间是竞争关系,即每条消息只能被一个消费者消费。

- 每条消息只需要被处理一次,Broker只会把消息发送给消费集群中的一个消费者

- 在消息重投时,不能保证路由到同一台机器上

- 消费状态由Broker维护

#### 广播模式(Broadcasting)

**为了解决一条消息能被多个消费者消费的问题**,发布/订阅模型就来了。该模型是将消息发往一个`Topic`即主题中,所有订阅了这个 `Topic` 的订阅者都能消费这条消息。

- 消费进度由Consumer维护

- 保证每个消费者都消费一次消息

- 消费失败的消息不会重投

### Message Order(消息顺序)

消息顺序:顺序(Orderly)和并发(Concurrently)

#### 顺序(Orderly)

#### 并发(Concurrently)

### Producer Group(生产组)

消息生产者组。标识发送同一类消息的Producer,通常发送逻辑一致。发送普通消息的时候,仅标识使用,并无特别用处。若事务消息,如果某条发送某条消息的producer-A宕机,使得事务消息一直处于PREPARED状态并超时,则broker会回查同一个group的其 他producer,确认这条消息应该commit还是rollback。但开源版本并不完全支持事务消息(阉割了事务回查的代码)。

### Consumer Group(消费组)

消息消费者组。标识一类Consumer的集合名称,这类Consumer通常消费一类消息,且消费逻辑一致。同一个Consumer Group下的各个实例将共同消费topic的消息,起到负载均衡的作用。消费进度以Consumer Group为粒度管理,不同Consumer Group之间消费进度彼此不受影响,即消息A被Consumer Group1消费过,也会再给Consumer Group2消费。

注: RocketMQ要求同一个Consumer Group的消费者必须要拥有相同的注册信息,即必须要听一样的topic(并且tag也一样)。

### Offset

在 Topic 的消费过程中,由于消息需要被不同的组进行多次消费,所以消费完的消息并不会立即被删除,这就需要 RocketMQ 为每个消费组在每个队列上维护一个消费位置(Consumer Offset),这个位置之前的消息都被消费过,之后的消息都没有被消费过,每成功消费一条消息,消费位置就加一。这个消费位置是非常重要的概念,我们在使用消息队列的时候,丢消息的原因大多是由于消费位置处理不当导致的。

## 核心设计

### 消息清理

Broker中的消息被消费后不会立即删除,每条消息都会持久化到CommitLog中,每个Consumer连接到Broker后会维持消费进度信息,当有消息消费后只是当前Consumer的消费进度(CommitLog的offset)更新了。默认48小时后会删除不再使用的CommitLog文件:

- 检查这个文件最后访问时间

- 判断是否大于过期时间

- 指定时间删除,默认凌晨4点

```java

/**

* {@link org.apache.rocketmq.store.DefaultMessageStore.CleanCommitLogService#isTimeToDelete()}

*/

private boolean isTimeToDelete() {

// when = "04";

String when = DefaultMessageStore.this.getMessageStoreConfig().getDeleteWhen();

// 是04点,就返回true

if (UtilAll.isItTimeToDo(when)) {

return true;

}

// 不是04点,返回false

return false;

}

/**

* {@link org.apache.rocketmq.store.DefaultMessageStore.CleanCommitLogService#deleteExpiredFiles()}

*/

private void deleteExpiredFiles() {

// isTimeToDelete()这个方法是判断是不是凌晨四点,是的话就执行删除逻辑。

if (isTimeToDelete()) {

// 默认是72,但是broker配置文件默认改成了48,所以新版本都是48。

long fileReservedTime = 48 * 60 * 60 * 1000;

deleteCount = DefaultMessageStore.this.commitLog.deleteExpiredFile(72 * 60 * 60 * 1000, xx, xx, xx);

}

}

/**

* {@link org.apache.rocketmq.store.CommitLog#deleteExpiredFile()}

*/

public int deleteExpiredFile(xxx) {

// 这个方法的主逻辑就是遍历查找最后更改时间+过期时间,小于当前系统时间的话就删了(也就是小于48小时)。

return this.mappedFileQueue.deleteExpiredFileByTime(72 * 60 * 60 * 1000, xx, xx, xx);

}

```

### push or pull

RocketMQ没有真正意义的push,都是pull,虽然有push类,但实际底层实现采用的是**长轮询机制**,即拉取方式。Broker端属性 `longPollingEnable` 标记是否开启长轮询,默认开启。源码如下:

```java

// {@link org.apache.rocketmq.client.impl.consumer.DefaultMQPushConsumerImpl#pullMessage()}

// 拉取消息,结果放到pullCallback里

this.pullAPIWrapper.pullKernelImpl(pullCallback);

```

**为什么要主动拉取消息而不使用事件监听方式?**

事件驱动方式是建立好长连接,由事件(发送数据)的方式来实时推送。如果broker主动推送消息的话有可能push速度快,消费速度慢的情况,那么就会造成消息在consumer端堆积过多,同时又不能被其他consumer消费的情况。而pull的方式可以根据当前自身情况来pull,不会造成过多的压力而造成瓶颈。所以采取了pull的方式。

### 负载均衡

RocketMQ通过Topic在多Broker中分布式存储实现。

#### Producer端

发送端指定message queue发送消息到相应的broker,来达到写入时的负载均衡

- 提升写入吞吐量,当多个producer同时向一个broker写入数据的时候,性能会下降

- 消息分布在多broker中,为负载消费做准备

**默认策略是随机选择:**

- producer维护一个index

- 每次取节点会自增

- index向所有broker个数取余

- 自带容错策略

**其他实现:**

- SelectMessageQueueByHash

- - hash的是传入的args

- SelectMessageQueueByRandom

- SelectMessageQueueByMachineRoom 没有实现

也可以自定义实现**MessageQueueSelector**接口中的select方法

```java

MessageQueue select(final List mqs, final Message msg, final Object arg);

```

#### Consumer端

采用的是平均分配算法来进行负载均衡。

**其他负载均衡算法**

- 平均分配策略(默认)(AllocateMessageQueueAveragely)

- 环形分配策略(AllocateMessageQueueAveragelyByCircle)

- 手动配置分配策略(AllocateMessageQueueByConfig)

- 机房分配策略(AllocateMessageQueueByMachineRoom)

- 一致性哈希分配策略(AllocateMessageQueueConsistentHash)

- 靠近机房策略(AllocateMachineRoomNearby)

**当消费负载均衡Consumer和Queue不对等的时候会发生什么?**

Consumer和Queue会优先平均分配,如果Consumer少于Queue的个数,则会存在部分Consumer消费多个Queue的情况,如果Consumer等于Queue的个数,那就是一个Consumer消费一个Queue,如果Consumer个数大于Queue的个数,那么会有部分Consumer空余出来,白白的浪费了。

## 最佳实践

### Producer

- **Topic**:消息主题,通过Topic对不同的业务消息进行分类

- **Tag**:消息标签,用来进一步区分某个Topic下的消息分类,消息从生产者发出即带上的属性

- **key**:每个消息在业务层面的唯一标识码,要设置到 keys 字段,方便将来定位消息丢失问题。服务器会为每个消息创建索引(哈希索引),应用可以通过 topic,key来查询这条消息内容,以及消息被谁消费。由于是哈希索引,请务必保证key 尽可能唯一,这样可以避免潜在的哈希冲突

- **日志**:消息发送成功或者失败,要打印消息日志,务必要打印 send result 和key 字段

- **send**:send消息方法,只要不抛异常,就代表发送成功。但是发送成功会有多个状态,在sendResult里定义

- **SEND_OK**:消息发送成功

- **FLUSH_DISK_TIMEOUT**:消息发送成功,但是服务器刷盘超时,消息已经进入服务器队列,只有此时服务器宕机,消息才会丢失

- **FLUSH_SLAVE_TIMEOUT**:消息发送成功,但是服务器同步到Slave时超时,消息已经进入服务器队列,只有此时服务器宕机,消息才会丢失

- **SLAVE_NOT_AVAILABLE**:消息发送成功,但是此时slave不可用,消息已经进入服务器队列,只有此时服务器宕机,消息才会丢失

- **订阅关系一致**

多个Group ID订阅了多个Topic,并且每个Group ID里的多个消费者实例的订阅关系保持了一致。

### Consumer

- **消费幂等**

为了防止消息重复消费导致业务处理异常,消息队列RocketMQ版的消费者在接收到消息后,有必要根据业务上的唯一Key对消息做幂等处理。消息重复的场景如下:

- **发送时消息重复**

- **投递时消息重复**

- **负载均衡时消息重复**(包括但不限于网络抖动、Broker重启以及消费者应用重启)

- **日志**:消费时记录日志,以便后续定位问题

- **批量消费**:尽量使用批量方式消费方式,可以很大程度上提高消费吞吐量

### 事务消息

MQ与DB一致性原理(两方事务)

事务消息就是MQ提供的类似XA的分布式事务能力,通过事务消息可以达到分布式事务的最终一致性。半事务消息就是MQ收到了生产者的消息,但是没有收到二次确认,不能投递的消息。实现原理如下:

- 生产者先发送一条半事务消息到MQ

- MQ收到消息后返回ack确认

- 生产者开始执行本地事务

- 如果事务执行成功发送commit到MQ,失败发送rollback

- 如果MQ长时间未收到生产者的二次确认commit或者rollback,MQ对生产者发起消息回查

- 生产者查询事务执行最终状态

- 根据查询事务状态再次提交二次确认

如果MQ收到二次确认commit,就可以把消息投递给消费者,反之如果是rollback,消息会保存下来并且在3天后被删除。

## 保证顺序

RocketMQ的消息是存储到Topic的Queue里面的,Queue本身是FIFO(First Int First Out)先进先出队列。所以单个Queue是可以保证有序性的。

顺序消息(FIFO 消息)是 MQ 提供的一种严格按照顺序进行发布和消费的消息类型。顺序消息由两个部分组成:

- **顺序发布**

- **顺序消费**

顺序消息包含两种类型:

- **分区顺序**:一个Partition内所有的消息按照先进先出的顺序进行发布和消费

- **全局顺序**:一个Topic内所有的消息按照先进先出的顺序进行发布和消费

对于两个订单的消息的原始数据:a1、b1、b2、a2、a3、b3(绝对时间下发生的顺序):

- 在发送时,a订单的消息需要保持a1、a2、a3的顺序,b订单的消息也相同,但是a、b订单之间的消息没有顺序关系,这意味着a、b订单的消息可以在不同的线程中被发送出去

- 在存储时,需要分别保证a、b订单的消息的顺序,但是a、b订单之间的消息的顺序可以不保证

### 保持顺序发送

消息被发送时保持顺序。

### 保持顺序发送存储

消息被存储时保持和发送的顺序一致。

### 保持顺序消费

消息被消费时保持和存储的顺序一致。

#### MQPullConsumer

MQPullConsumer由用户控制线程,主动从服务端获取消息,每次获取到的是一个MessageQueue中的消息。PullResult中的List msgFoundList自然和存储顺序一致,用户需要再拿到这批消息后自己保证消费的顺序。

#### MQPushConsumer

对于PushConsumer,由用户注册MessageListener来消费消息,在客户端中需要保证调用MessageListener时消息的顺序性。

## 消息不丢失

一条消息从生产到被消费,将会经历三个阶段:

- 生产阶段:Producer 新建消息,然后通过网络将消息投递给 MQ Broker

- 存储阶段:消息将会存储在 Broker 端磁盘中

- 消息阶段:Consumer 将会从 Broker 拉取消息

以上任一阶段都可能会丢失消息,我们只要找到这三个阶段丢失消息原因,采用合理的办法避免丢失,就可以彻底解决消息丢失的问题。

### 生产阶段

Producer通过网络将消息发送给Broker,这个发送可能会发生丢失,比如网络延迟不可达等。

失败会自动重试,即使重试N次也不行后,那客户端也会知道消息没成功,这也可以自己补偿等,不会盲目影响到主业务逻辑。再比如即使Broker挂了,那还有其他Broker再提供服务了,高可用,不影响。

总结:**同步发送+自动重试机制+多个Master节点**

#### 同步发送

有三种send方法,同步发送、异步发送、单向发送,可以采取同步发送的方式进行发送消息。

- **同步发送**:发消息时会同步阻塞等待broker返回的结果,如果没成功,则不会收到SendResult,这种是最可靠的

- **异步发送**:在回调方法里可以得知是否发送成功

- **单向发送(OneWay)**:最不靠谱的一种发送方式,我们无法保证消息真正可达

```java

/**

* {@link org.apache.rocketmq.client.producer.DefaultMQProducer}

*/

// 同步发送

public SendResult send(Message msg) throws MQClientException, RemotingException, MQBrokerException, InterruptedException {}

// 异步发送,sendCallback作为回调

public void send(Message msg,SendCallback sendCallback) throws MQClientException, RemotingException, InterruptedException {}

// 单向发送,不关心发送结果,最不靠谱

public void sendOneway(Message msg) throws MQClientException, RemotingException, InterruptedException {}

```

#### 失败重试

发送消息如果失败或者超时了,则会自动重试。默认是重试3次,可以根据api进行更改,比如改为10次:

```java

producer.setRetryTimesWhenSendFailed(10);

```

底层源码逻辑如下:

```java

/**

* {@link org.apache.rocketmq.client.producer.DefaultMQProducer#sendDefaultImpl(Message, CommunicationMode, SendCallback, long)}

*/

// 自动重试次数,this.defaultMQProducer.getRetryTimesWhenSendFailed()默认为2,如果是同步发送,默认重试3次,否则重试1次

int timesTotal = communicationMode == CommunicationMode.SYNC ? 1 + this.defaultMQProducer.getRetryTimesWhenSendFailed() : 1;

int times = 0;

for (; times < timesTotal; times++) {

// 选择发送的消息queue

MessageQueue mqSelected = this.selectOneMessageQueue(topicPublishInfo, lastBrokerName);

if (mqSelected != null) {

try {

// 真正的发送逻辑,sendKernelImpl。

sendResult = this.sendKernelImpl(msg, mq, communicationMode, sendCallback, topicPublishInfo, timeout - costTime);

switch (communicationMode) {

case ASYNC:

return null;

case ONEWAY:

return null;

case SYNC:

// 如果发送失败了,则continue,意味着还会再次进入for,继续重试发送

if (sendResult.getSendStatus() != SendStatus.SEND_OK) {

if (this.defaultMQProducer.isRetryAnotherBrokerWhenNotStoreOK()) {

continue;

}

}

// 发送成功的话,将发送结果返回给调用者

return sendResult;

default:

break;

}

} catch (RemotingException e) {

continue;

} catch (...) {

continue;

}

}

}

```

#### 故障切换

假设Broker宕机了,但是生产环境一般都是多M多S的,所以还会有其他Master节点继续提供服务,这也不会影响到我们发送消息,我们消息依然可达。因为比如恰巧发送到broker的时候,broker宕机了,producer收到broker的响应发送失败了,这时候producer会自动重试,这时候宕机的broker就被踢下线了, 所以producer会换一台broker发送消息。

### Broker存储阶段

若想很严格的保证Broker存储消息阶段消息不丢失,则需要如下配置,但是性能肯定远差于默认配置:

```properties

# master 节点配置

flushDiskType = SYNC_FLUSH

brokerRole=SYNC_MASTER

# slave 节点配置

brokerRole=slave

flushDiskType = SYNC_FLUSH

```

#### 设置Broker同步刷盘策略

**设置Broker同步刷盘策略**。默认情况下,消息只要到了 Broker 端,将会优先保存到内存中,然后立刻返回确认响应给生产者。随后 Broker 定期批量的将一组消息从内存异步刷入磁盘。这种方式减少 I/O 次数,可以取得更好的性能,但是如果发生机器断电,异常宕机等情况,消息还未及时刷入磁盘,就会出现丢失消息的情况。

若想保证 Broker 端不丢消息,保证消息的可靠性,我们需要将消息保存机制修改为同步刷盘方式,即消息**存储磁盘成功**,才会返回响应。修改 Broker 端配置如下:

```properties

# 默认情况为 ASYNC_FLUSH

flushDiskType = SYNC_FLUSH

```

若 Broker 未在同步刷盘时间内(**默认为 5s**)完成刷盘,将会返回 `SendStatus.FLUSH_DISK_TIMEOUT` 状态给生产者。

#### 等待Master和Slave刷盘完

等待Master和Slave刷盘完。即使Broker设置了同步刷盘策略,但是Broker刷完盘后磁盘坏了,这会导致盘上的消息全丢了。但是如果即使是1主1从了,但是Master刷完盘后还没来得及同步给Slave就磁盘坏了,这会导致盘上的消息全丢了。所以我们还可以配置不仅是等Master刷完盘就通知Producer,而是等Master和Slave都刷完盘后才去通知Producer说消息ok了。

```properties

# 默认为 ASYNC_MASTER

brokerRole=SYNC_MASTER

```

### 消费阶段

消费失败了其实也是消息丢失的一种变体。

只有当消费模式为 **MessageModel.CLUSTERING(集群模式)** 时,Broker 才会自动进行重试,对于广播消息是不会重试的。对于一直无法消费成功的消息,RocketMQ 会在达到最大重试次数之后,将该消息投递至死信队列。然后我们需要关注死信队列,并对该死信消息业务做人工的补偿操作。

#### 手动ACK确认

消费者会先把消息拉取到本地,然后进行业务逻辑,业务逻辑完成后手动进行ack确认,这时候才会真正的代表消费完成。而不是说pull到本地后消息就算消费完了。举个例子

```java

consumer.registerMessageListener(new MessageListenerConcurrently() {

@Override

public ConsumeConcurrentlyStatus consumeMessage(List msgs, ConsumeConcurrentlyContext consumeConcurrentlyContext) {

try{

for (MessageExt msg : msgs) {

String str = new String(msg.getBody());

System.out.println(str);

}

return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;

} catch(Throwable t){

log.error("消费异常:{}", msgs, t);

return ConsumeConcurrentlyStatus.RECONSUME_LATER;

}

}

});

```

#### 消费异常自动重试

- 业务消费方返回 ConsumeConcurrentlyStatus.RECONSUME_LATER

- 业务消费方返回 null

- 业务消费方主动/被动抛出异常

针对以上3种情况下,Broker一般会进行重试(默认最大重试16次),RocketMQ 采用了“时间衰减策略”进行消息的重复投递,即重试次数越多,消息消费成功的可能性越小。我们可以在 RocketMQ 的 `broker.conf` 配置文件中配置 Consumer 侧重试次数及时间间隔(**距离第1次发送的时间间隔**), 配置如下:

```properties

messageDelayLevel=1s 5s 10s 30s 1m 2m 3m 4m 5m 6m 7m 8m 9m 10m 20m 30m 1h 2h

```

消费者客户端,首先判断消费端有没有显式设置最大重试次数 MaxReconsumeTimes, 如果没有,则设置默认重试次数为 16,否则以设置的最大重试次数为准。

```java

private int getMaxReconsumeTimes() {

// default reconsume times: 16

if (this.defaultMQPushConsumer.getMaxReconsumeTimes() == -1) {

return 16;

} else {

return this.defaultMQPushConsumer.getMaxReconsumeTimes();

}

}

```

#### 消费超时无线重试

如果是消费超时情况,MQ会无限制的发送给消费端。这种情况就是Consumer端没有返回`ConsumeConcurrentlyStatus. CONSUME_SUCCESS`,也没有返回`ConsumeConcurrentlyStatus.RECONSUME_LATER`。

#### 死信队列

死信的处理逻辑:

- 首先判断消息当前重试次数是否大于等于 16,或者消息延迟级别是否小于 0

- 只要满足上述的任意一个条件,设置新的 topic(死信 topic)为:**%DLQ%+consumerGroup**

- 进行前置属性的添加

- 将死信消息投递到上述步骤 2 建立的死信 topic 对应的死信队列中并落盘,使消息持久化

最后单独启动一个死信队列的消费者进行消费,然后进行人工干预处理失败的消息。

## 消息幂等

在所有消息系统中消费消息有三种模式:`at-most-once`(最多一次)、`at-least-once`(最少一次)和 `exactly-only-once`(精确仅一次),分布式消息系统都是在三者间取平衡,前两者是可行的并且被广泛使用。

- `at-most-once`:消息投递后不论消息是否被消费成功,不会再重复投递,有可能会导致消息未被消费,RocketMQ 未使用该方式

- `at-lease-once`:消息投递后,消费完成后,向服务器返回 ACK,没有消费则一定不会返回 ACK 消息。由于网络异常、客户端重启等原因,服务器未能收到客户端返回的 ACK,服务器则会再次投递,这就会导致可能重复消费,RocketMQ 通过 ACK 来确保消息至少被消费一次

- `exactly-only-once`:在分布式系统环境下,如果要实现该模式,巨大的开销不可避免。RocketMQ 没有保证此特性,无法避免消息重复,由业务上进行幂等性处理。必须下面两个条件都满足,才能认为消息是"Exactly Only Once":

- 发送消息阶段,不允许发送重复消息

- 消费消息阶段,不允许消费重复的消息

# Zookeeper

**下载地址:**http://www.apache.org/dist/zookeeper/

## 节点角色

### Leader

- 负责处理客户端发送的`读、写事务请求`。这里的事务请求可以理解这个请求具有事务的 ACID 特性

- 同步`写事务请求`给其他节点,且需要保证事务的顺序性

- 状态为 LEADING

### Follower

- 负责处理客户端发送的读请求

- 转发写事务请求给 Leader

- 参与 Leader 的选举

- 状态为 FOLLOWING

### Observer

和 Follower 一样,唯一不同的是,不参与 Leader 的选举,且状态为 OBSERING。可以用来线性扩展读的 QPS。

## 核心流程设计

### 启动阶段 Leader选举

Zookeeper 刚启动的时候,多个节点需要找出一个 Leader。怎么找呢,就是用`投票`。比如集群中有两个节点,A 和 B,原理图如下所示:

- 节点 A 先`投票给自己`,投票信息包含`节点 id(SID)` 和一个 `ZXID`,如 (1,0)。SID 是配置好的,且唯一,ZXID 是唯一的递增编号

- 节点 B 先`投票给自己`,投票信息为(2,0)

- 然后节点 A 和 B 将自己的投票信息`投票`给集群中`所有节点`

- 节点 A 收到节点 B 的投票信息后,`检查`下节点 B 的状态是否是`本轮投票`,以及是否是`正在选举(LOOKING)`的状态

- 投票 PK:节点 A 会将自己的投票和别人的投票进行 PK,如果别的节点发过来的 ZXID 较大,则把自己的投票信息`更新`为别的节点发过来的投票信息,**如果 ZXID 相等,则比较 SID**。这里节点 A 和 节点 B 的 ZXID 相同,SID 的话,节点 B 要大些,所以节点 A 更新投票信息为(2,0),然后将投票信息`再次`发送出去。而节点 B `不需要更新`投票信息,但是下一轮还需要再次将投票发出去。这个时候节点 A 的投票信息为(2,0),如下图所示:

- 统计投票:每一轮投票,都会统计每台节点收到的投票信息,判断是否有`过半的节点`收到了`相同`的投票信息。节点 A 和 节点 B 收到的投票信息都为(2,0),且数量来说,大于一半节点的数量,所以将节点 B 选出来作为 Leader

- 更新节点状态:节点 A 作为 `Follower`,更新状态为 FOLLOWING,节点 B 作为 `Leader`,更新状态为 LEADING

### 运行期间Leader宕机处理

在 Zookeeper 运行期间,Leader 会一直保持为 LEADING 状态,直到 Leader 宕机了,这个时候就要重新选 Leader,而选举过程和启动阶段的选举过程基本一致。需要注意的点:

- 剩下的 Follower 进行选举,Observer 不参与选举

- 投票信息中的 zxid 用的是本地磁盘日志文件中的。如果这个节点上的 zxid 较大,就会被当选为 Leader。如果 Follower 的 zxid 都相同,则 Follower 的节点 id 较大的会被选为 Leader

### 节点之间同步数据流程

不同的客户端可以分别连接到主节点或备用节点。而客户端发送读写请求时是不知道自己连的是Leader 还是 Follower,**如果客户端连的是主节点**,发送了写请求,那么 Leader 执行 2PC(两阶段提交协议)同步给其他 Follower 和 Observer 就可以了。但是**如果客户端连的是 Follower**,发送了写请求,那么 Follower 会将写请求转发给 Leader,然后 Leader 再进行 2PC 同步数据给 Follower。两阶段提交协议:

- **第一阶段**:Leader 先发送 proposal 给 Follower,Follower 发送 ack 响应给 Leader。如果收到的 ack 过半,则进入下一阶段

- **第二阶段**: Leader 从磁盘日志文件中加载数据到内存中,Leader 发送 commit 消息给 Follower,Follower 加载数据到内存中

我们来看下 Leader 同步数据的流程:

- ① 客户端发送写事务请求

- ② Leader 收到写请求后,转化为一个 "proposal01:zxid1" 事务请求,存到磁盘日志文件

- ③ 发送 proposal 给其他 Follower

- ④ Follower 收到 proposal 后,Follower 写磁盘日志文件

接着我们看下 Follower 收到 Leader 发送的 proposal 事务请求后,怎么处理的:

- ⑤ Follower 返回 ack 给 Leader

- ⑥ Leader 收到超过一半的 ack,进行下一阶段

- ⑦ Leader 将磁盘中的日志文件的 proposal 加载到 znode 内存数据结构中

- ⑧ Leader 发送 commit 消息给所有 Follower 和 Observer

- ⑨ Follower 收到 commit 消息后,将 磁盘中数据加载到 znode 内存数据结构中

现在Leader和Follower的数据都是在内存数据中的,且是一致的,客户端从Leader和Follower读到的数据都是一致的。

### ZAB顺序一致性原理

Leader 发送 proposal 时,其实会为每个 Follower 创建一个队列,都往各自的队列中发送 proposal。如下图所示是 Zookeeper 的消息广播流程:

客户端发送了三条写事务请求,对应的 proposal 为

```properties

proposal01:zxid1

proposal02:zxid2

proposal03:zxid3

```

Leader 收到请求后,依次放到队列中,然后 Follower 依次从队列中获取请求,这样就保证了数据的顺序性。

### Zookeeper是否是强一致性

> 官方定义:顺序一致性。

不保证强一致性,为什么呢?

因为 Leader 再发送 commit 消息给所有 Follower 和 Observer 后,它们并不是同时完成 commit 的。比如因为`网络原因`,不同节点收到的 commit 较晚,那么提交的时间也较晚,就会出现多个节点的数据不一致,但是经过短暂的时间后,所有节点都 commit 后,数据就保持同步了。另外 Zookeeper 支持强一致性,就是手动调用 sync 方法来保证所有节点都 commit 才算成功。

这里有个问题:如果某个节点 commit 失败,那么 Leader 会进行重试吗?如何保证数据的一致性?

### Leader 宕机数据丢失问题

**第一种情况**:假设 Leader 已经将消息写入了本地磁盘,但是还没有发送 proposal 给 Follower,这个时候 Leader 宕机了。那就需要选新的 Leader,新 Leader 发送 proposal 的时候,包含的 zxid 自增规律会发生一次变化:

- zxid 的高 32 位自增 1 一次,高 32 位代表 Leader 的版本号。

- zxid 的低 32 位自增 1,后续还是继续保持自增长。

当老 Leader 恢复后,会转成 Follower,Leader 发送最新的 proposal 给它时,发现本地磁盘的 proposal 的 zxid 的高 32 位小于新 Leader 发送的 proposal,就丢弃自己的 proposal。

**第二种情况**:如果 Leader 成功发送了 commit 消息给 Follower,但是所有或者部分 Follower 还没来得及 commit 这个 proposal,也就是加载磁盘中的 proposal 到 内存中,这个时候 Leader 宕机了。

那么就需要选出磁盘日志中 zxid 最大的 Follower,如果 zxid 相同,则比较节点 id,节点 id 大的作为 Leader。

## ZK特性

Zookeeper主要靠其 **分布式数据一致性** 为集群提供 **分布式协调服务**,即指在集群的节点中进行可靠的消息传递,来协调集群的工作。主要具有如下特点:

- **最终一致性:**Client无论连接到哪个Server,展示给它都是同一个视图,这是zookeeper最重要的性能

- **可靠性:**如果一个消息或事物被一台Server接受,那么它将被所有的服务器接受

- **实时性:**Zookeeper不能保证强一致性,只保证顺序一致性和最终一致性,因此称为**伪实时性**。由于网络延时等原因,Zookeeper不能保证两个客户端能同时得到刚更新的数据,如果需要最新数据,应该在读数据之前调用sync()接口

- **原子性:**更新只能成功或者失败,没有中间状态

- **顺序性:**包括 **全序(Total order)** 和 **因果顺序(Causal order)**

- **全序:**如果消息a在消息b之前发送,则所有Server应该看到相同的结果

- **因果顺序:**如果消息a在消息b之前发生(a导致了b),并被一起发送,则a始终在b之前被执行

## ZK角色

- **Server(服务端)**

- **Leader(领导者):**负责对所有对ZK状态变更的请求,将状态更新请求进行排序与编号,以保证集群内部消息处理的有序性

- **Learner(学习者)**

- **Follower(追随者):**用于接收客户请求并向客户端返回结果,在选举过程中参与投票

- **Observer(观察者):**其作用是为了扩展集群来提供读取速度,可以接收客户端连接,将写请求转发给Leader节点,但不参与投票,只同步Leader状态

- **Client(客户端):**请求发起方

每个Server在工作过程中有三种状态:

- **LOOKING:**当前Server不知道Leader是谁,正在搜寻

- **LEADING:**当前Server即为选举出来的Leader

- **FOLLOWING:**Leader已经选举出来,当前Server与之同步

Zookeeper集群中,有Leader、Follower和Observer三种角色

- **领导者(Leader)**:负责进行投票的发起和决议,更新系统状态

Leader服务器是整个ZooKeeper集群工作机制中的核心,其主要工作:

- 事务请求的唯一调度和处理者,保证集群事务处理的顺序性

- 集群内部各服务的调度者

- **跟随者(Follower)**:用于接收客户端请求并给客户端返回结果,在选主过程中进行投票

Follower服务器是ZooKeeper集群状态的跟随者,其主要工作:

- 处理客户端非事务请求,转发事务请求给Leader服务器

- 参与事务请求Proposal的投票

- 参与Leader选举投票

- **观察者(Observer)**:可以接受客户端连接,将写请求转发给 leader,但是observer 不参加投票的过程,只是为了扩展系统,提高读取的速度

Observer是3.3.0 版本开始引入的一个服务器角色,它充当一个观察者角色——观察ZooKeeper集群的最新状态变化并将这些状态变更同步过来。其工作:

- 处理客户端的非事务请求,转发事务请求给 Leader 服务器

- 不参与任何形式的投票

## 数据模型

Zookeeper 的数据模型:

- 层次化的目录结构,命名符合常规文件系统规范,类似于Linux

- 每个节点在zookeeper中叫做znode,并且其有一个唯一的路径标识

- 节点Znode可以包含数据和子节点,但是EPHEMERAL类型的节点不能有子节点

- Znode中的数据可以有多个版本,比如某一个路径下存有多个数据版本,那么查询这个路径下的数据就需要带上版本

- 客户端应用可以在节点上设置监视器

- 节点不支持部分读写,而是一次性完整读写

## Server工作状态

服务器具有四种状态,分别是 LOOKING、FOLLOWING、LEADING、OBSERVING。

- LOOKING:寻找Leader状态。当服务器处于该状态时,它会认为当前集群中没有 Leader,因此需要进入 Leader 选举状态

- FOLLOWING:跟随者状态。表明当前服务器角色是Follower

- LEADING:领导者状态。表明当前服务器角色是Leader

- OBSERVING:观察者状态。表明当前服务器角色是Observer

## 运行模式

Zookeeper 有三种运行模式:单机模式、伪集群模式和集群模式。

- **单机模式**:这种模式一般适用于开发测试环境,一方面我们没有那么多机器资源,另外就是平时的开发调试并不需要极好的稳定性。

- **集群模式**:一个 ZooKeeper 集群通常由一组机器组成,一般 3 台以上就可以组成一个可用的 ZooKeeper 集群了。组成 ZooKeeper 集群的每台机器都会在内存中维护当前的服务器状态,并且每台机器之间都会互相保持通信。

- **伪集群模式**:这是一种特殊的集群模式,即集群的所有服务器都部署在一台机器上。当你手头上有一台比较好的机器,如果作为单机模式进行部署,就会浪费资源,这种情况下,ZooKeeper 允许你在一台机器上通过启动不同的端口来启动多个 ZooKeeper 服务实例,以此来以集群的特性来对外服务。

## Leader选举

### 服务器启动的Leader选举

zookeeper集群初始化阶段,服务器(myid=1-5)**「依次」**启动,开始zookeeper选举Leader~

- 服务器1(myid=1)启动,当前只有一台服务器,无法完成Leader选举

- 服务器2(myid=2)启动,此时两台服务器能够相互通讯,开始进入Leader选举阶段

- 每个服务器发出一个投票

服务器1 和 服务器2都将自己作为Leader服务器进行投票,投票的基本元素包括:服务器的myid和ZXID,我们以(myid,ZXID)形式表示。初始阶段,服务器1和服务器2都会投给自己,即服务器1的投票为(1,0),服务器2的投票为(2,0),然后各自将这个投票发给集群中的其他所有机器。

- 接受来自各个服务器的投票

每个服务器都会接受来自其他服务器的投票。同时,服务器会校验投票的有效性,是否本轮投票、是否来自LOOKING状态的服务器。

- 处理投票

收到其他服务器的投票,会将别人的投票跟自己的投票PK,PK规则如下:

- 优先检查ZXID。ZXID比较大的服务器优先作为leader。

- 如果ZXID相同的话,就比较myid,myid比较大的服务器作为leader。服务器1的投票是(1,0),它收到投票是(2,0),两者zxid都是0,因为收到的myid=2,大于自己的myid=1,所以它更新自己的投票为(2,0),然后重新将投票发出去。对于服务器2呢,即不再需要更新自己的投票,把上一次的投票信息发出即可。

- 统计投票

每次投票后,服务器会统计所有投票,判断是否有过半的机器接受到相同的投票信息。服务器2收到两票,少于3(n/2+1,n为总服务器5),所以继续保持LOOKING状态

- 服务器3(myid=3)启动,继续进入Leader选举阶段

跟前面流程一致,服务器1和2先投自己一票,因为服务器3的myid最大,所以大家把票改投给它。此时,服务器为3票(大于等于n/2+1),所以服务器3当选为Leader。服务器1,2更改状态为FOLLOWING,服务器3更改状态为LEADING;

- 服务器4启动,发起一次选举。

此时服务器1,2,3已经不是LOOKING状态,不会更改选票信息。选票信息结果:服务器3为3票,服务器4为1票。服务器4并更改状态为FOLLOWING;

- 服务器5启动,发起一次选举。

同理,服务器也是把票投给服务器3,服务器5并更改状态为FOLLOWING;

- 投票结束,服务器3当选为Leader

### 服务器运行期间的Leader选举

zookeeper集群的五台服务器(myid=1-5)正在运行中,突然某个瞬间,Leader服务器3挂了,这时候便开始Leader选举~

- 变更状态

Leader 服务器挂了之后,余下的非Observer服务器都会把自己的服务器状态更改为LOOKING,然后开始进入Leader选举流程。

- 每个服务器发起投票

每个服务器都把票投给自己,因为是运行期间,所以每台服务器的ZXID可能不相同。假设服务1,2,4,5的zxid分别为333,666,999,888,则分别产生投票(1,333),(2,666),(4,999)和(5,888),然后各自将这个投票发给集群中的其他所有机器。

- 接受来自各个服务器的投票

- 处理投票

投票规则是跟Zookeeper集群启动期间一致的,优先检查ZXID,大的优先作为Leader,所以显然服务器zxid=999具有优先权。

- 统计投票

- 改变服务器状态

## 节点(znode)

**① 节点组成**

每个znode由4部分组成:

- **path:**即节点名称,用于存放简单可视化的数据

- **stat:**即状态信息,描述该znode的版本,权限等信息

- **data:**与该znode关联的数据

- **children:**该znode下的子节点

**② 节点类型**

- **PERSISTENT(持久化目录节点)**

客户端与zookeeper断开连接后,该节点依旧存在

- **PERSISTENT_SEQUENTIAL(持久化顺序编号目录节点)**

客户端与zookeeper断开连接后,该节点依旧存在,只是Zookeeper给该节点名称进行顺序编号

- **EPHEMERAL(临时目录节点)**

客户端与zookeeper断开连接后,该节点被删除

- **EPHEMERAL_SEQUENTIAL(临时顺序编号目录节点)**

客户端与zookeeper断开连接后,该节点被删除,只是Zookeeper给该节点名称进行顺序编号

## 关键词

- **zxid(事务ID号)**

ZooKeeper状态的每一次改变,都对应着一个递增的`Transaction id`,该id称为zxid。由于zxid的递增性质,如果zxid1小于zxid2,那么zxid1肯定先于zxid2发生。创建任意节点、更新任意节点的数据、删除任意节点,都会导致Zookeeper状态发生改变,从而导致zxid的值增加。

- **session(会话连接)**

在Client和Server通信之前,首先需要建立连接,该连接称为session。连接建立后,如果发生连接超时、授权失败或显式关闭连接,连接便处于CLOSED状态,此时session结束。

## Watcher监听机制

Zookeeper 允许客户端向服务端的某个Znode注册一个Watcher监听,当服务端的一些指定事件触发了这个Watcher,服务端会向指定客户端发送一个事件通知来实现分布式的通知功能,然后客户端根据 Watcher通知状态和事件类型做出业务上的改变。

- ZooKeeper的Watcher机制主要包括客户端线程、客户端 WatcherManager、Zookeeper服务器三部分

- 客户端向ZooKeeper服务器注册Watcher的同时,会将Watcher对象存储在客户端的WatchManager中

- 当zookeeper服务器触发watcher事件后,会向客户端发送通知, 客户端线程从 WatcherManager 中取出对应的 Watcher 对象来执行回调逻辑

**Watcher特性总结**

- **「一次性:」** 一个Watch事件是一个一次性的触发器。一次性触发,客户端只会收到一次这样的信息

- **「异步的:」** Zookeeper服务器发送watcher的通知事件到客户端是异步的,不能期望能够监控到节点每次的变化,Zookeeper只能保证最终的一致性,而无法保证强一致性

- **「轻量级:」** Watcher 通知非常简单,它只是通知发生了事件,而不会传递事件对象内容

- **「客户端串行:」** 执行客户端 Watcher 回调的过程是一个串行同步的过程

- 注册 watcher用getData、exists、getChildren方法

- 触发 watcher用create、delete、setData方法

## ZXID

ZXID有两部分组成:

- 任期:完成本次选举后,直到下次选举前,由同一Leader负责协调写入

- 事务计数器:单调递增,每生效一次写入,计数器加一

ZXID的低32位是计数器,所以同一任期内,ZXID是连续的,每个结点又都保存着自身最新生效的ZXID,通过对比新提案的ZXID与自身最新ZXID是否相差“1”,来保证事务严格按照顺序生效的。

## 工作流程

**① 客户端发起的操作的主要流程**

Leader可以执行增删改查操作,而Follower只能进行查询操作。所有的更新操作都会被转交给Leader来处理,Leader批准的任务,再发送给Follower去执行来保证和Leader的一致性。由于网络是不稳定的,为了保证执行顺序的一致,所有的任务都会被赋予一个唯一的顺序的编号,一定是按照这个编号来执行任务,保证任务顺序的一致性。

**② 客户端的请求什么时候才能算处理成功?为什么说集群过半机器宕机后无法再工作?**

Leader在收到客户端提交过来的任务后,会向集群中所有的Follower发送提案等待Follower的投票,Follower们收到这个提议后,会进行投票,同意或者不同意,Leader会回收Follower的投票,一旦受到过半的投票表示同意,则Leader认为这个提案通过,再发送命令要求所有的Follower都进行这个提案中的任务。由于需要过半的机器同意才能执行任务,所以一旦集群中过半的机器挂掉,整个集群就无法工作了。

- **Leader工作流程**

Leader主要有三个功能:

- 恢复数据

- 维持与Learner的心跳,接收Learner请求并判断Learner的请求消息类型

- Learner的消息类型主要有如下四种,根据不同的消息类型,进行不同的处理:

- **PING消息:**指Learner的心跳信息

- **REQUEST消息:**Follower发送的提议信息,包括写请求及同步请求

- **ACK消息:**Follower的对提议的回复,超过半数的Follower通过,则commit该提议

- **REVALIDATE消息:**用来延长SESSION有效时间

- **Follower工作流程**

Follower主要有四个功能:

- 向Leader发送消息请求(PING消息、REQUEST消息、ACK消息、REVALIDATE消息)

- 接收Leader消息并进行处理

- 接收Client的请求,如果为写请求,发送给Leader进行投票

- 返回Client结果

Follower的消息循环处理如下几种来自Leader的消息:

- **PING消息:** 心跳消息

- **PROPOSAL消息:**Leader发起的提案,要求Follower投票

- **COMMIT消息:**服务器端最新一次提案的信息

- **UPTODATE消息:**表明同步完成

- **REVALIDATE消息:**根据Leader的REVALIDATE结果,关闭待revalidate的session还是允许其接受消息

- **SYNC消息:**返回SYNC结果到客户端,这个消息最初由客户端发起,用来强制得到最新的更新

- **Observer工作流程**

对于Observer的流程不再叙述,Observer流程和Follower的唯一不同的地方就是Observer不会参加Leader发起的投票。

## ZAB协议

ZooKeeper并没有完全采用Paxos算法,而是使用一种称为ZooKeeper Atomic Broadcast(ZAB,Zookeeper原子消息广播协议)的协议作为其数据一致性的核心算法,简称ZAB协议。ZAB协议分为两种模式:

- **崩溃恢复模式(Recovery):**当服务初次启动或Leader节点挂了时,系统就会进入恢复模式,直到选出了有合法数量Follower的新Leader,然后新Leader负责将整个系统同步到最新状态

- **消息广播模式(Boardcast):**ZAB协议中,所有的写请求都由Leader来处理。正常工作状态下,Leader接收请求并通过广播协议来处理(如:广播提议投票、广播命令)

**① 崩溃恢复模式(Recovery)**

为了使Leader挂了后系统能正常工作,需要解决以下两个问题:

- 已经被处理的消息不能丢

- 被丢弃的消息不能再次出现

**② 消息广播模式(Boardcast)**

广播的过程实际上是一个简化的二阶段提交过程:

- Leader 接收到消息请求后,将消息赋予一个全局唯一的 64 位自增 id,叫做:zxid,通过 zxid 的大小比较即可实现因果有序这一特性

- Leader 通过先进先出队列(通过 TCP 协议来实现,以此实现了全局有序这一特性)将带有 zxid 的消息作为一个提案(proposal)分发给所有 follower

- 当 follower 接收到 proposal,先将 proposal 写到硬盘,写硬盘成功后再向 leader 回一个 ACK

- 当 leader 接收到合法数量的 ACKs 后,leader 就向所有 follower 发送 COMMIT 命令,同事会在本地执行该消息

- 当 follower 收到消息的 COMMIT 命令时,就会执行该消息

**总结**

个人认为 Zab 协议设计的优秀之处有两点,一是简化二阶段提交,提升了在正常工作情况下的性能;二是巧妙地利用率自增序列,简化了异常恢复的逻辑,也很好地保证了顺序处理这一特性。值得注意的是,ZAB提交事务并不像2PC一样需要全部Follower都ACK,只需要得到quorum(超过半数的节点)的ACK就可以了。

**③ ZAB 的四个阶段**

- **Leader election(选举阶段):**节点在一开始都处于选举阶段,只要有一个节点得到超半数节点的票数,它就可以当选准Leader(只有完成ZAB的四个阶段,准Leader才会成为真正的Leader)。本阶段的目的是就是为了选出一个准Leader,然后进入下一个阶段

- **Discovery(发现阶段):**在次阶段,Followers跟准Leader进行通信,同步Followers最近接收的事务提议,这个一阶段的主要目的是发现当前大多数节点接收的最新提议

- **Synchronization(同步阶段):**同步阶段主要是利用Leader前一阶段获得的最新提议历史,同步集群中所有的副本。只有当quorum都同步完成,准Leader才会成为真正的Leader。Follower只会接收zxid比自己的lastZxid大的提议

- **Broadcast(广播阶段):**到了这个阶段,Zookeeper 集群才能正式对外提供事务服务,并且Leader可以进行消息广播。同时如果有新的节点加入,还需要对新节点进行同步

**④ JAVA版ZAB协议**

- **Fast Leader Election**:Fast Leader Election

前面提到 FLE 会选举拥有最新提议历史(lastZixd最大)的节点作为 leader,这样就省去了发现最新提议的步骤。这是基于拥有最新提议的节点也有最新提交记录的前提。成为 leader 的条件:

- 选epoch最大的

- epoch相等,选 zxid 最大的

- epoch和zxid都相等,选择server id最大的(即配置zoo.cfg中的myid)

- **Recovery Phase**:这一阶段Follower发送它们的 lastZixd 给Leader,Leader 根据 lastZixd 决定如何同步数据。这里的实现跟前面 Phase 2 有所不同:Follower 收到 TRUNC 指令会中止 L.lastCommittedZxid 之后的提议,收到 DIFF 指令会接收新的提议。

- **Broadcast Phase**:暂无

## ZK选举过程

最开始集群启动时,会选择xzid最小的机器作为leader。

当Leader崩溃或者Leader失去大多数的Follower,这时候ZK进入恢复模式,恢复模式需要重新选举出一个新的Leader,让所有的Server都恢复到一个正确的状态。ZK的选举算法使用**ZAB协议**:

- 选举线程由当前Server发起选举的线程担任,其主要功能是对投票结果进行统计,并选出推荐的Server

- 选举线程首先向所有Server发起一次询问(包括自己)

- 选举线程收到回复后,验证是否是自己发起的询问(验证zxid是否一致),然后获取对方的id(myid),并存储到当前询问对象列表中,最后获取对方提议的leader相关信息(id,zxid),并将这些信息存储到当次选举的投票记录表中

- 收到所有Server回复以后,就计算出zxid最大的那个Server,并将这个Server相关信息设置成下一次要投票的Server

- 线程将当前zxid最大的Server设置为当前Server要推荐的Leader,如果此时获胜的Server获得n/2 + 1的Server票数, 设置当前推荐的leader为获胜的Server,将根据获胜的Server相关信息设置自己的状态,否则,继续这个过程,直到leader被选举出来

**分析结论**

要使Leader获得多数Server的支持,则Server总数最好是奇数2n+1,且存活的Server的数目不得少于n+1。因为需要过半存活集群才能工作,所以2n个机器提供的集群可靠性其实和2n-1个机器提供的集群可靠性是一样的。

## Zookeeper安装

### 单机模式

**第一步:安装部署**

```shell

# 下载解压

wget http://mirror.bit.edu.cn/apache/zookeeper/zookeeper-3.4.9/zookeeper-3.4.9.tar.gz

tar -zxvf zookeeper-3.4.9.tar.gz

# 设置全局变量

vim ~/.bash_profile

# 最后一行加入

export ZOOKEEPER_HOME=/home/zookeeper/zookeeper-3.4.9

export PATH=$ZOOKEEPER_HOME/bin:$PATH

# 使之生效

source ~/.bash_profile

# 复制配置文件

cp /home/zookeeper/zookeeper-3.4.9/conf/zoo_sample.cfg /home/zookeeper/zookeeper-3.4.9/conf/zoo.cfg

```

**第二步:配置信息**

```shell

# 心跳间隔

tickTime=2000

# 保存数据目录

dataDir=/home/zookeeper/zookeeper-3.4.9/dataDir

# 保存日志目录

dataLogDir=/home/zookeeper/zookeeper-3.4.9/dataLogDir

# 客户端连接Zookeeper的端口

clientPort=2181

# 允许follower连接并同步到leader的初始化连接时间(心跳倍数),超过则连接失败

initLimit=5

# 表示leader和follower之间发送消息时, 请求和应答的最大时间长度

syncLimit=2

```

### 集群模式

**第一步:安装部署**

安装方式参考单机模式。

**第二步:配置信息**

在dataDir根目录下新建myid文件,并向文件myid中写入值(如:1、2、3……)

```shell

# 1表示当前集群的id号

echo "1" > myid

```

在单机配置情况下,新增下述参数:

```shell

# 格式:server.X=A:B:C

# X表示myid(范围1~255)

# A是该server所在的IP地址

# B配置该server和集群中的leader交换消息所使用的端口,即数据同步端口

# C配置选举leader时所使用的端口

server.1=10.24.1.62:2888:3888

server.2=10.24.1.63:2888:3888

server.3=10.24.1.64:2888:3888

```

### 运维命令

```shell

# 启动ZK服务器

./zkServer.sh start

# 使用ZK Client连接指定服务器

./zkCli.sh -server 127.0.0.1:2181

# 查看ZK服务状态

./zkServer.sh status

# 停止ZK服务

./zkServer.sh stop

# 重启ZK服务

./zkServer.sh restart

```

### zoo.cfg配置参数

```shell

# 客户端连接server的端口,默认值2181

clientPort=2181

# 存储快照文件snapshot的目录

dataDir=/User/lry/zookeeper/data

# ZK中的最小时间单元,单位为毫秒

tickTime=5000

# 事务日志输出目录

dataLogDir=/User/lry/zookeeper/datalog

# Server端最大允许的请求堆积数,默认值为1000

globalOutstandingLimit=1000

# 每个事务日志文件的大小,默认值64M

preAllocSize=64

# 每进行snapCount次事务日志输出后,触发一次快照,默认值100000,实际代码中是随机范围触发,避免并发情况

snapCount=100000

# 单个客户端与单台服务器之间的连接数的限制,是ip级别的,默认是60,如果设置为0,那么表明不作任何限制

maxClientCnxns=60

# 对于多网卡的机器,可以为每个IP指定不同的监听端口。默认是所有IP都监听clientPort指定的端口

clientPortAddress=10.24.22.56

# Session超时时间限制,如果客户端设置的超时时间不在这个范围,那么会被强制设置为最大或最小时间。默认的Session超时时间是在2*tickTime~20*tickTime这个范围

minSessionTimeoutmaxSessionTimeout

# Follower在启动过程中,会从Leader同步所有最新数据,然后确定自己能够对外服务的起始状态。Leader允许F在 initLimit 时间内完成这个工作。

initLimit

# 在运行过程中,Leader负责与ZK集群中所有机器进行通信,例如通过一些心跳检测机制,来检测机器的存活状态。如果L发出心跳包在syncLimit之后,还没有从F那里收到响应,那么就认为这个F已经不在线了。

syncLimit

# 默认情况下,Leader是会接受客户端连接,并提供正常的读写服务。但是,如果你想让Leader专注于集群中机器的协调,那么可以将这个参数设置为no,这样一来,会大大提高写操作的性能

leaderServes=yes

# server.[myid]=[hostname]:[数据同步和其它通讯端口]:[选举投票通讯]

server.x=[hostname]:nnnnn[:nnnnn]

# 对机器分组和权重设置

group.x=nnnnn[:nnnnn]weight.x=nnnnn

# Leader选举过程中,打开一次连接的超时时间,默认是5s

cnxTimeout

# 每个节点最大数据量,是默认是1M

jute.maxbuffer

```

# Netty

## Netty逻辑架构

Netty内部逻辑的流转:

### 网络通信层

网络通信层的职责是**执行网络I/O的操作**,它支持多种网络协议和I/O模型的连接操作。当网络数据读取到内核缓冲区后,会触发各种网络事件,这些网络事件会分发给事件调度层进行处理。三个核心组件包括:

- **BootStrap和ServerBootStrap**

主要负责整个Netty程序的启动、初始化、服务器连接等过程,它相当于一条主线,串联了Netty的其它核心组件。Bootstrap和ServerBootStrap十分相似,两者的区别在于:

- Bootstrap可用于连接远端服务器,只绑定一个EventLoopGroup

- ServerBootStrap则用于服务端启动绑定本地端口,会绑定两个EventLoopGroup,通常称为Boss和Worker(Boss 会不停地接收新的连接,然后将连接分配给一个个Worker处理连接)

- **Channel**

提供了基本的API用于网络I/O操作,如register、bind、connect、read、write、flush 等。Netty的Channel是以JDK NIO Channel为基础的,相比较于JDK NIO,Netty的Channel提供了更高层次的抽象,同时屏蔽了底层Socket的复杂性,赋予了Channel更加强大的功能,在使用Netty时基本不需要再与Java Socket类直接打交道。

### 事件调度层

事件调度层的职责是通过Reactor线程模型对各类事件进行聚合处理,通过Selector主循环线程集成多种事件(I/O事件、信号事件、定时事件等),实际的业务处理逻辑是交由服务编排层中相关的Handler完成。两个核心组件包括:

- **EventLoopGroup、EventLoop**

EventLoopGroup是Netty的核心处理引擎,本质是一个线程池,主要负责接收I/O请求,并分配线程执行处理请求。EventLoopGroup的实现类**NioEventLoopGroup**也是 Netty 中最被推荐使用的线程模型。是基于NIO模型开发的,可以把NioEventLoopGroup理解为一个线程池,每个线程负责处理多个Channel,而同一个Channel只会对应一个线程。

- 一个 EventLoopGroup 往往包含一个或者多个 EventLoop。EventLoop 用于处理 Channel 生命周期内的所有 I/O 事件,如 accept、connect、read、write 等 I/O 事件

- EventLoop 同一时间会与一个线程绑定,每个 EventLoop 负责处理多个 Channel

- 每新建一个 Channel,EventLoopGroup 会选择一个 EventLoop 与其绑定。该 Channel 在生命周期内都可以对 EventLoop 进行多次绑定和解绑

其实EventLoopGroup是Netty Reactor线程模型的具体实现方式,Netty通过创建不同的EventLoopGroup参数配置,就可以支持Reactor的三种线程模型:

- **单线程模型**:EventLoopGroup只包含一个EventLoop,Boss和Worker使用同一个EventLoopGroup

- **多线程模型**:EventLoopGroup包含多个EventLoop,Boss和Worker使用同一个EventLoopGroup

- **主从多线程模型**:EventLoopGroup包含多个EventLoop,Boss是主Reactor,Worker是从Reactor,它们分别使用不同的EventLoopGroup,主Reactor负责新的网络连接Channel创建,然后把Channel注册到从Reactor

### 服务编排层

服务编排层的职责是负责组装各类服务,是Netty的核心处理链,用以实现网络事件的动态编排和有序传播。核心组件包括:

- **ChannelPipeline**

ChannelPipeline 是 Netty 的核心编排组件,负责组装各种 ChannelHandler,实际数据的编解码以及加工处理操作都是由 ChannelHandler 完成的。ChannelPipeline 可以理解为ChannelHandler 的实例列表——内部通过双向链表将不同的 ChannelHandler 链接在一起。当 I/O 读写事件触发时,ChannelPipeline 会依次调用 ChannelHandler 列表对 Channel 的数据进行拦截和处理。

ChannelPipeline 是线程安全的,因为每一个新的 Channel 都会对应绑定一个新的 ChannelPipeline。一个 ChannelPipeline 关联一个 EventLoop,一个 EventLoop 仅会绑定一个线程。

ChannelPipeline、ChannelHandler 都是高度可定制的组件。开发者可以通过这两个核心组件掌握对 Channel 数据操作的控制权。下面我们看一下 ChannelPipeline 的结构图:

ChannelPipeline中包含入站ChannelInboundHandler和出站 ChannelOutboundHandler两种处理器,结合客户端和服务端的数据收发流程:

- **ChannelHandler & ChannelHandlerContext**

数据的编解码工作以及其他转换工作实际都是通过 ChannelHandler 处理的。ChannelHandlerContext 用于保存 ChannelHandler 上下文,通过 ChannelHandlerContext 可以知道 ChannelPipeline 和 ChannelHandler 的关联关系。ChannelHandlerContext 可以实现 ChannelHandler 之间的交互,ChannelHandlerContext 包含了 ChannelHandler 生命周期的所有事件,如 connect、bind、read、flush、write、close 等。

每创建一个 Channel 都会绑定一个新的 ChannelPipeline,ChannelPipeline 中每加入一个 ChannelHandler 都会绑定一个 ChannelHandlerContext。

## Reactor线程模型

Reactor线程模型运行机制的四个步骤,分别为**连接注册、事件轮询、事件分发、任务处理**。

- 连接注册:Channel建立后,注册至Reactor线程中的Selector选择器

- 事件轮询:轮询Selector选择器中已注册的所有Channel的I/O事件

- 事件分发:为准备就绪的I/O事件分配相应的处理线程

- 任务处理:Reactor线程还负责任务队列中的非I/O任务,每个Worker线程从各自维护的任务队列中取出任务异步执行

### 单Reactor单线程

上图描述了 Reactor 的单线程模型结构,在 Reactor 单线程模型中,所有 I/O 操作(包括连接建立、数据读写、事件分发等),都是由一个线程完成的。单线程模型逻辑简单,缺陷也十分明显:

- 一个线程支持处理的连接数非常有限,CPU 很容易打满,性能方面有明显瓶颈

- 当多个事件被同时触发时,只要有一个事件没有处理完,其他后面的事件就无法执行,这就会造成消息积压及请求超时

- 线程在处理 I/O 事件时,Select 无法同时处理连接建立、事件分发等操作

- 如果 I/O 线程一直处于满负荷状态,很可能造成服务端节点不可用

### 单Reactor多线程

由于单线程模型有性能方面的瓶颈,多线程模型作为解决方案就应运而生了。Reactor 多线程模型将业务逻辑交给多个线程进行处理。除此之外,多线程模型其他的操作与单线程模型是类似的,例如读取数据依然保留了串行化的设计。当客户端有数据发送至服务端时,Select 会监听到可读事件,数据读取完毕后提交到业务线程池中并发处理。

### 主从Reactor多线程

主从多线程模型由多个 Reactor 线程组成,每个 Reactor 线程都有独立的 Selector 对象。MainReactor 仅负责处理客户端连接的 Accept 事件,连接建立成功后将新创建的连接对象注册至 SubReactor。再由 SubReactor 分配线程池中的 I/O 线程与其连接绑定,它将负责连接生命周期内所有的 I/O 事件。

Netty 推荐使用主从多线程模型,这样就可以轻松达到成千上万规模的客户端连接。在海量客户端并发请求的场景下,主从多线程模式甚至可以适当增加 SubReactor 线程的数量,从而利用多核能力提升系统的吞吐量。

## 核心设计

### Netty EventLoop原理

EventLoop 这个概念其实并不是 Netty 独有的,它是一种事件等待和处理的程序模型,可以解决多线程资源消耗高的问题。例如 Node.js 就采用了 EventLoop 的运行机制,不仅占用资源低,而且能够支撑了大规模的流量访问。

EventLoop 可以说是 Netty 的调度中心,负责监听多种事件类型:I/O 事件、信号事件、定时事件等。

#### EventLoop运行模式

上图展示了 EventLoop 通用的运行模式。每当事件发生时,应用程序都会将产生的事件放入事件队列当中,然后 EventLoop 会轮询从队列中取出事件执行或者将事件分发给相应的事件监听者执行。事件执行的方式通常分为**立即执行、延后执行、定期执行**几种。

#### NioEventLoop原理

在 Netty 中 EventLoop 可以理解为 Reactor 线程模型的事件处理引擎,每个 EventLoop 线程都维护一个 Selector 选择器和任务队列 taskQueue。它主要负责处理 I/O 事件、普通任务和定时任务。Netty 中推荐使用 NioEventLoop 作为实现类,那么 Netty 是如何实现 NioEventLoop 的呢?首先我们来看 NioEventLoop 最核心的 run() 方法源码:

```java

protected void run() {

for (;;) {

try {

try {

switch (selectStrategy.calculateStrategy(selectNowSupplier, hasTasks())) {

case SelectStrategy.CONTINUE:

continue;

case SelectStrategy.BUSY_WAIT:

case SelectStrategy.SELECT:

// 轮询 I/O 事件

select(wakenUp.getAndSet(false));

if (wakenUp.get()) {

selector.wakeup();

}

default:

}

} catch (IOException e) {

rebuildSelector0();

handleLoopException(e);

continue;

}

cancelledKeys = 0;

needsToSelectAgain = false;

final int ioRatio = this.ioRatio;

if (ioRatio == 100) {

try {

// 处理 I/O 事件

processSelectedKeys();

} finally {

// 处理所有任务

runAllTasks();

}

} else {

final long ioStartTime = System.nanoTime();

try {

// 处理 I/O 事件

processSelectedKeys();

} finally {

final long ioTime = System.nanoTime() - ioStartTime;

// 处理完 I/O 事件,再处理异步任务队列

runAllTasks(ioTime * (100 - ioRatio) / ioRatio);

}

}

} catch (Throwable t) {

handleLoopException(t);

}

try {

if (isShuttingDown()) {

closeAll();

if (confirmShutdown()) {

return;

}

}

} catch (Throwable t) {

handleLoopException(t);

}

}

}

```

上述源码的结构比较清晰,NioEventLoop 每次循环的处理流程都包含事件轮询 select、事件处理 processSelectedKeys、任务处理 runAllTasks 几个步骤,是典型的 Reactor 线程模型的运行机制。而且 Netty 提供了一个参数 ioRatio,可以调整 I/O 事件处理和任务处理的时间比例。下面我们将着重从**事件处理**和**任务处理**两个核心部分出发,详细介绍 Netty EventLoop 的实现原理。

#### 事件处理机制

结合Netty的整体架构,看上述EventLoop的事件流转图,以便更好地理解 Netty EventLoop 的设计原理。NioEventLoop 的事件处理机制采用的是**无锁串行化的设计思路**:

- **BossEventLoopGroup** 和 **WorkerEventLoopGroup** 包含一个或者多个 NioEventLoop

BossEventLoopGroup 负责监听客户端的 Accept 事件,当事件触发时,将事件注册至 WorkerEventLoopGroup 中的一个 NioEventLoop 上。每新建一个 Channel, 只选择一个 NioEventLoop 与其绑定。所以说 Channel 生命周期的所有事件处理都是**线程独立**的,不同的 NioEventLoop 线程之间不会发生任何交集。

- NioEventLoop 完成数据读取后,会调用绑定的 ChannelPipeline 进行事件传播

ChannelPipeline 也是**线程安全**的,数据会被传递到 ChannelPipeline 的第一个 ChannelHandler 中。数据处理完成后,将加工完成的数据再传递给下一个 ChannelHandler,整个过程是**串行化**执行,不会发生线程上下文切换的问题。

NioEventLoop 无锁串行化的设计不仅使系统吞吐量达到最大化,而且降低了用户开发业务逻辑的难度,不需要花太多精力关心线程安全问题。虽然单线程执行避免了线程切换,但是它的缺陷就是不能执行时间过长的 I/O 操作,一旦某个 I/O 事件发生阻塞,那么后续的所有 I/O 事件都无法执行,甚至造成事件积压。在使用 Netty 进行程序开发时,我们一定要对 ChannelHandler 的实现逻辑有充分的风险意识。

NioEventLoop 线程的可靠性至关重要,一旦 NioEventLoop 发生阻塞或者陷入空轮询,就会导致整个系统不可用。在 JDK 中, Epoll 的实现是存在漏洞的,即使 Selector 轮询的事件列表为空,NIO 线程一样可以被唤醒,导致 CPU 100% 占用。这就是臭名昭著的 JDK epoll 空轮询的 Bug。Netty 作为一个高性能、高可靠的网络框架,需要保证 I/O 线程的安全性。那么它是如何解决 JDK epoll 空轮询的 Bug 呢?实际上 Netty 并没有从根源上解决该问题,而是巧妙地规避了这个问题。

抛开其它细枝末节,直接定位到事件轮询select()方法中的最后一部分代码,一起看下Netty是如何解决epoll空轮询的Bug:

```java

long time = System.nanoTime();

if (time - TimeUnit.MILLISECONDS.toNanos(timeoutMillis) >= currentTimeNanos) {

selectCnt = 1;

} else if (SELECTOR_AUTO_REBUILD_THRESHOLD > 0 &&

selectCnt >= SELECTOR_AUTO_REBUILD_THRESHOLD) {

selector = selectRebuildSelector(selectCnt);

selectCnt = 1;

break;

}

```

Netty提供了一种检测机制判断线程是否可能陷入空轮询,具体的实现方式如下:

- 每次执行 select 操作之前记录当前时间 currentTimeNanos

- **time - TimeUnit.MILLISECONDS.toNanos(timeoutMillis) >= currentTimeNanos**,如果事件轮询的持续时间大于等于 timeoutMillis,那么说明是正常的,否则表明阻塞时间并未达到预期,可能触发了空轮询的 Bug

- Netty 引入了计数变量 selectCnt。在正常情况下,selectCnt 会重置,否则会对 selectCnt 自增计数。当 selectCnt 达到 SELECTOR_AUTO_REBUILD_THRESHOLD(默认512) 阈值时,会触发重建 Selector 对象

Netty 采用这种方法巧妙地规避了 JDK Bug。异常的 Selector 中所有的 SelectionKey 会重新注册到新建的 Selector 上,重建完成之后异常的 Selector 就可以废弃了。

#### 任务处理机制

NioEventLoop 不仅负责处理 I/O 事件,还要兼顾执行任务队列中的任务。任务队列遵循 FIFO 规则,可以保证任务执行的公平性。NioEventLoop 处理的任务类型基本可以分为三类:

- **普通任务**:通过 NioEventLoop 的 execute() 方法向任务队列 taskQueue 中添加任务。例如 Netty 在写数据时会封装 WriteAndFlushTask 提交给 taskQueue。taskQueue 的实现类是多生产者单消费者队列 MpscChunkedArrayQueue,在多线程并发添加任务时,可以保证线程安全

- **定时任务**:通过调用 NioEventLoop 的 schedule() 方法向定时任务队列 scheduledTaskQueue 添加一个定时任务,用于周期性执行该任务。例如,心跳消息发送等。定时任务队列 scheduledTaskQueue 采用优先队列 PriorityQueue 实现

- **尾部队列**:tailTasks 相比于普通任务队列优先级较低,在每次执行完 taskQueue 中任务后会去获取尾部队列中任务执行。尾部任务并不常用,主要用于做一些收尾工作,例如统计事件循环的执行时间、监控信息上报等

下面结合任务处理 runAllTasks 的源码结构,分析下 NioEventLoop 处理任务的逻辑,源码实现如下:

```java

protected boolean runAllTasks(long timeoutNanos) {

// 1. 合并定时任务到普通任务队列

fetchFromScheduledTaskQueue();

// 2. 从普通任务队列中取出任务

Runnable task = pollTask();

if (task == null) {

afterRunningAllTasks();

return false;

}

// 3. 计算任务处理的超时时间

final long deadline = ScheduledFutureTask.nanoTime() + timeoutNanos;

long runTasks = 0;

long lastExecutionTime;

for (;;) {

// 4. 安全执行任务

safeExecute(task);