| 文本前端 |

|

tn / g2p

|

| 声学模型 |

Tacotron2 |

LJSpeech / CSMSC |

tacotron2-ljspeech / tacotron2-csmsc

|

| Transformer TTS |

LJSpeech |

transformer-ljspeech

|

| SpeedySpeech |

CSMSC |

speedyspeech-csmsc

|

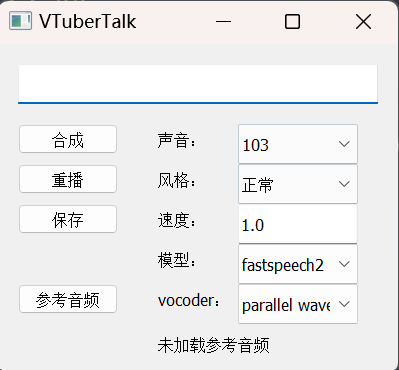

| FastSpeech2 |

LJSpeech / VCTK / CSMSC / AISHELL-3 |

fastspeech2-ljspeech / fastspeech2-vctk / fastspeech2-csmsc / fastspeech2-aishell3

|

| 声码器 |

WaveFlow |

LJSpeech |

waveflow-ljspeech

|

| Parallel WaveGAN |

LJSpeech / VCTK / CSMSC / AISHELL-3 |

PWGAN-ljspeech / PWGAN-vctk / PWGAN-csmsc / PWGAN-aishell3

|

| Multi Band MelGAN |

CSMSC |

Multi Band MelGAN-csmsc

|

| Style MelGAN |

CSMSC |

Style MelGAN-csmsc

|

| HiFiGAN |

LJSpeech / VCTK / CSMSC / AISHELL-3 |

HiFiGAN-ljspeech / HiFiGAN-vctk / HiFiGAN-csmsc / HiFiGAN-aishell3

|

| WaveRNN |

CSMSC |

WaveRNN-csmsc

|

| 声音克隆 |

GE2E |

Librispeech, etc. |

ge2e

|

| GE2E + Tacotron2 |

AISHELL-3 |

ge2e-tacotron2-aishell3

|

| GE2E + FastSpeech2 |

AISHELL-3 |

ge2e-fastspeech2-aishell3

|