|

|

3 weeks ago | |

|---|---|---|

| .. | ||

| README.md | 3 weeks ago | |

| assignment.md | 3 weeks ago | |

README.md

Изградња решења за машинско учење са одговорном вештачком интелигенцијом

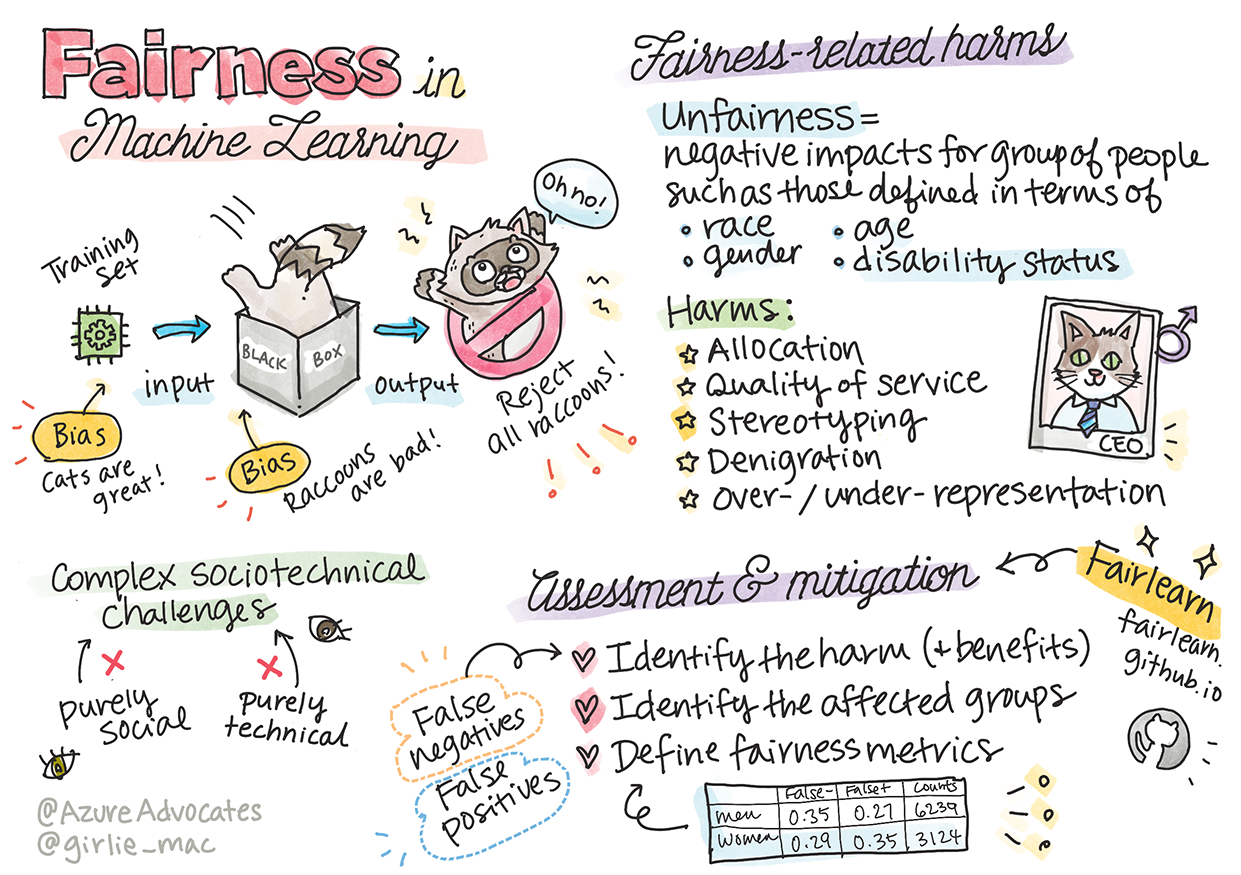

Скица од Томоми Имура

Квиз пре предавања

Увод

У овом курикулуму, почећете да откривате како машинско учење може и већ утиче на наше свакодневне животе. Чак и сада, системи и модели су укључени у свакодневне задатке доношења одлука, као што су дијагнозе у здравству, одобравање кредита или откривање превара. Због тога је важно да ти модели добро функционишу како би пружили резултате који су поуздани. Као и свака софтверска апликација, системи вештачке интелигенције могу да не испуне очекивања или да имају непожељан исход. Зато је од суштинског значаја разумети и објаснити понашање модела вештачке интелигенције.

Замислите шта може да се догоди када подаци које користите за изградњу ових модела недостају одређеним демографским групама, као што су раса, пол, политички ставови, религија, или када непропорционално представљају те демографске групе. Шта ако је излаз модела интерпретиран тако да фаворизује одређену демографску групу? Које су последице за апликацију? Поред тога, шта се дешава када модел има негативан исход и наноси штету људима? Ко је одговоран за понашање система вештачке интелигенције? Ово су нека од питања која ћемо истражити у овом курикулуму.

У овој лекцији, научићете:

- Да подигнете свест о важности правичности у машинском учењу и штетама повезаним са неправичношћу.

- Да се упознате са праксом истраживања изузетака и необичних сценарија ради осигурања поузданости и безбедности.

- Да стекнете разумевање о потреби оснаживања свих кроз дизајнирање инклузивних система.

- Да истражите колико је важно заштитити приватност и безбедност података и људи.

- Да увидите значај приступа „стаклене кутије“ за објашњавање понашања модела вештачке интелигенције.

- Да будете свесни како је одговорност кључна за изградњу поверења у системе вештачке интелигенције.

Предуслов

Као предуслов, молимо вас да прођете кроз „Принципе одговорне вештачке интелигенције“ и погледате видео испод на ову тему:

Сазнајте више о одговорној вештачкој интелигенцији пратећи овај пут учења

🎥 Кликните на слику изнад за видео: Приступ Microsoft-а одговорној вештачкој интелигенцији

Правичност

Системи вештачке интелигенције треба да третирају све људе праведно и избегавају различите ефекте на сличне групе људи. На пример, када системи вештачке интелигенције пружају смернице о медицинском лечењу, апликацијама за кредите или запошљавању, они треба да дају исте препоруке свима са сличним симптомима, финансијским околностима или професионалним квалификацијама. Сваки од нас као људско биће носи у себи наследне предрасуде које утичу на наше одлуке и поступке. Те предрасуде могу бити очигледне у подацима које користимо за обучавање система вештачке интелигенције. Таква манипулација понекад може да се догоди ненамерно. Често је тешко свесно знати када уносите предрасуде у податке.

„Неправичност“ обухвата негативне утицаје, или „штете“, за групу људи, као што су они дефинисани у смислу расе, пола, старости или инвалидитета. Главне штете повезане са неправичношћу могу се класификовати као:

- Додела ресурса, ако је, на пример, одређени пол или етничка група фаворизована у односу на другу.

- Квалитет услуге. Ако обучите податке за један специфичан сценарио, али је стварност много сложенија, то доводи до лоше услуге. На пример, дозатор сапуна који не може да препозна људе са тамном кожом. Референца

- Омаловажавање. Неправедно критиковање и етикетирање нечега или некога. На пример, технологија за означавање слика је озлоглашено погрешно означила слике људи тамне коже као гориле.

- Прекомерна или недовољна заступљеност. Идеја је да одређена група није видљива у одређеној професији, а свака услуга или функција која наставља да промовише то доприноси штети.

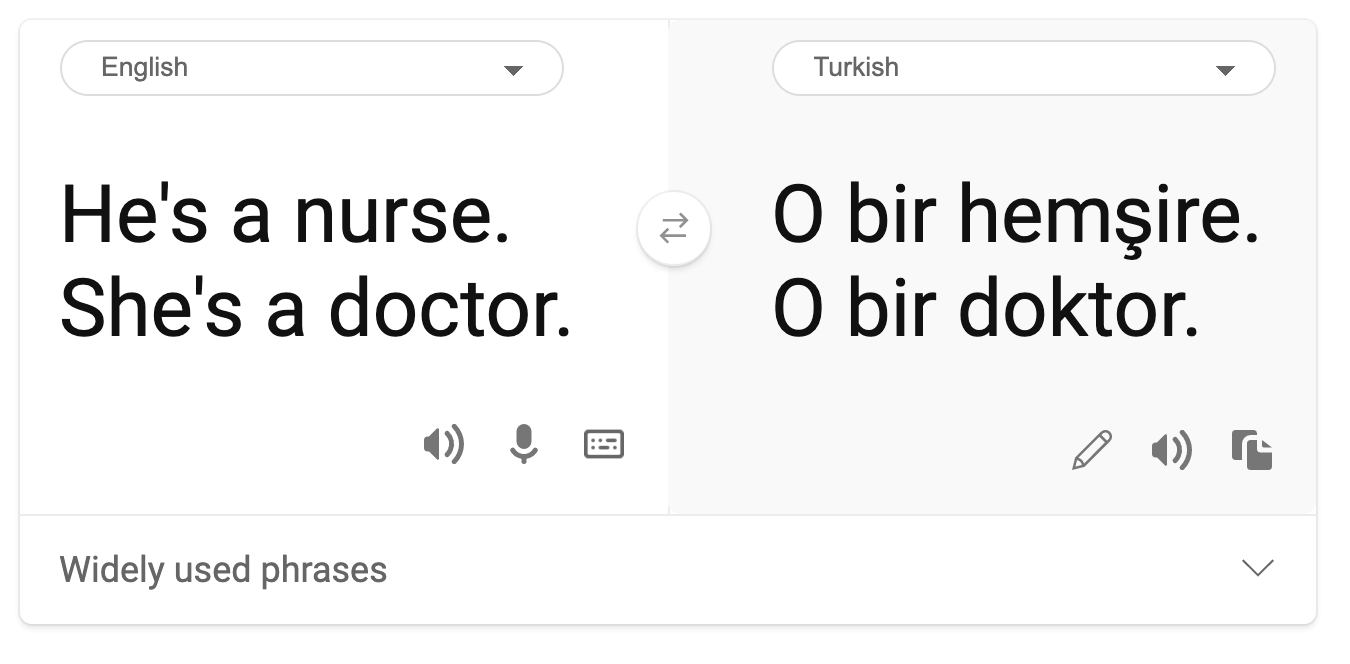

- Стереотипизација. Повезивање одређене групе са унапред додељеним атрибутима. На пример, систем за превођење између енглеског и турског може имати нетачности због речи са стереотипним асоцијацијама на пол.

превод на турски

превод назад на енглески

Када дизајнирамо и тестирамо системе вештачке интелигенције, морамо осигурати да вештачка интелигенција буде праведна и да није програмирана да доноси пристрасне или дискриминаторне одлуке, које су и људима забрањене. Гарантовање правичности у вештачкој интелигенцији и машинском учењу остаје сложен социотехнички изазов.

Поузданост и безбедност

Да би се изградило поверење, системи вештачке интелигенције морају бити поуздани, безбедни и конзистентни у нормалним и неочекиваним условима. Важно је знати како ће се системи вештачке интелигенције понашати у различитим ситуацијама, посебно када су у питању изузеци. Приликом изградње решења заснованих на вештачкој интелигенцији, потребно је посветити значајну пажњу томе како се носити са широким спектром околности које би решења могла да сусретну. На пример, аутомобил који се самостално управља мора ставити безбедност људи као главни приоритет. Као резултат, вештачка интелигенција која покреће аутомобил мора узети у обзир све могуће сценарије са којима би се аутомобил могао суочити, као што су ноћ, грмљавина или снежне олује, деца која трче преко улице, кућни љубимци, радови на путу итд. Колико добро систем вештачке интелигенције може да се носи са широким спектром услова поуздано и безбедно одражава ниво предвиђања који је научник за податке или програмер вештачке интелигенције разматрао током дизајна или тестирања система.

Инклузивност

Системи вештачке интелигенције треба да буду дизајнирани тако да ангажују и оснажују све. Приликом дизајнирања и имплементације система вештачке интелигенције, научници за податке и програмери вештачке интелигенције идентификују и решавају потенцијалне препреке у систему које би могле ненамерно искључити људе. На пример, постоји 1 милијарда људи са инвалидитетом широм света. Са напретком вештачке интелигенције, они могу лакше приступити широком спектру информација и могућности у свакодневном животу. Решавањем препрека стварају се могућности за иновације и развој производа заснованих на вештачкој интелигенцији са бољим искуствима која користе свима.

🎥 Кликните овде за видео: инклузивност у вештачкој интелигенцији

Безбедност и приватност

Системи вештачке интелигенције треба да буду безбедни и да поштују приватност људи. Људи имају мање поверења у системе који угрожавају њихову приватност, информације или животе. Приликом обучавања модела машинског учења, ослањамо се на податке како бисмо произвели најбоље резултате. У том процесу, порекло података и њихов интегритет морају бити узети у обзир. На пример, да ли су подаци достављени од стране корисника или јавно доступни? Затим, док радимо са подацима, од суштинског је значаја развијати системе вештачке интелигенције који могу заштитити поверљиве информације и одолети нападима. Како вештачка интелигенција постаје све присутнија, заштита приватности и обезбеђивање важних личних и пословних информација постаје све критичнија и сложенија. Питања приватности и безбедности података захтевају посебну пажњу за вештачку интелигенцију јер је приступ подацима од суштинског значаја за системе вештачке интелигенције да би донели тачне и информисане предвиђања и одлуке о људима.

🎥 Кликните овде за видео: безбедност у вештачкој интелигенцији

- Као индустрија, постигли смо значајан напредак у области приватности и безбедности, значајно подстакнут регулативама као што је GDPR (Општа уредба о заштити података).

- Ипак, са системима вештачке интелигенције морамо признати тензију између потребе за више личних података како би системи били персонализованији и ефикаснији – и приватности.

- Као што је било са појавом повезаних рачунара преко интернета, такође видимо велики пораст броја безбедносних проблема повезаних са вештачком интелигенцијом.

- Истовремено, видели смо да се вештачка интелигенција користи за побољшање безбедности. На пример, већина модерних антивирусних скенера данас се покреће помоћу хеуристике засноване на вештачкој интелигенцији.

- Морамо осигурати да наши процеси у области науке о подацима хармонично функционишу са најновијим праксама приватности и безбедности.

Транспарентност

Системи вештачке интелигенције треба да буду разумљиви. Кључни део транспарентности је објашњавање понашања система вештачке интелигенције и њихових компоненти. Побољшање разумевања система вештачке интелигенције захтева да заинтересоване стране разумеју како и зашто функционишу, како би могли да идентификују потенцијалне проблеме у перформансама, забринутости у вези са безбедношћу и приватношћу, пристрасности, праксе искључивања или непредвиђене исходе. Такође верујемо да они који користе системе вештачке интелигенције треба да буду искрени и отворени о томе када, зашто и како одлучују да их примене, као и о ограничењима система које користе. На пример, ако банка користи систем вештачке интелигенције за подршку у доношењу одлука о кредитима за потрошаче, важно је испитати исходе и разумети који подаци утичу на препоруке система. Владе почињу да регулишу вештачку интелигенцију у различитим индустријама, па научници за податке и организације морају објаснити да ли систем вештачке интелигенције испуњава регулаторне захтеве, посебно када дође до непожељног исхода.

🎥 Кликните овде за видео: транспарентност у вештачкој интелигенцији

- Због сложености система вештачке интелигенције, тешко је разумети како они функционишу и интерпретирати резултате.

- Овај недостатак разумевања утиче на начин на који се ти системи управљају, оперативно користе и документују.

- Овај недостатак разумевања, што је још важније, утиче на одлуке донете на основу резултата које ти системи производе.

Одговорност

Људи који дизајнирају и примењују системе вештачке интелигенције морају бити одговорни за начин на који њихови системи функционишу. Потреба за одговорношћу је посебно важна код осетљивих технологија као што је препознавање лица. У последње време, постоји растућа потражња за технологијом препознавања лица, посебно од стране организација за спровођење закона које виде потенцијал технологије у употребама као што је проналажење нестале деце. Међутим, те технологије би потенцијално могле бити коришћене од стране владе да угрозе основне слободе својих грађана, на пример, омогућавањем континуираног надзора одређених појединаца. Зато научници за податке и организације морају бити одговорни за начин на који њихов систем вештачке интелигенције утиче на појединце или друштво.

🎥 Кликните на слику изнад за видео: Упозорења о масовном надзору кроз препознавање лица

На крају, једно од највећих питања за нашу генерацију, као прву генерацију која доноси вештачку интелигенцију у друштво, јесте како осигурати да рачунари остану одговорни људима и како осигурати да људи који дизајнирају рачунаре остану одговорни свима осталима.

Процена утицаја

Пре него што обучите модел машинског учења, важно је спровести процену утицаја како бисте разум Погледајте овај радионицу да бисте се дубље упознали са темама:

- У потрази за одговорном вештачком интелигенцијом: Примена принципа у пракси од стране Бесмире Нуши, Мехрнуш Самеки и Амита Шарме

🎥 Кликните на слику изнад за видео: RAI Toolbox: Отворени оквир за изградњу одговорне вештачке интелигенције од стране Бесмире Нуши, Мехрнуш Самеки и Амита Шарме

Такође, прочитајте:

-

Microsoft-ов центар ресурса за одговорну вештачку интелигенцију: Responsible AI Resources – Microsoft AI

-

Microsoft-ова истраживачка група FATE: FATE: Fairness, Accountability, Transparency, and Ethics in AI - Microsoft Research

RAI Toolbox:

Прочитајте о алатима Azure Machine Learning-а за обезбеђивање правичности:

Задатак

Одрицање од одговорности:

Овај документ је преведен коришћењем услуге за превођење помоћу вештачке интелигенције Co-op Translator. Иако настојимо да обезбедимо тачност, молимо вас да имате у виду да аутоматизовани преводи могу садржати грешке или нетачности. Оригинални документ на изворном језику треба сматрати меродавним извором. За критичне информације препоручује се професионални превод од стране људи. Не сносимо одговорност за било каква погрешна тумачења или неспоразуме који могу произаћи из коришћења овог превода.