|

|

2 weeks ago | |

|---|---|---|

| .. | ||

| README.md | 2 weeks ago | |

| assignment.md | 3 weeks ago | |

README.md

Создание решений машинного обучения с ответственным ИИ

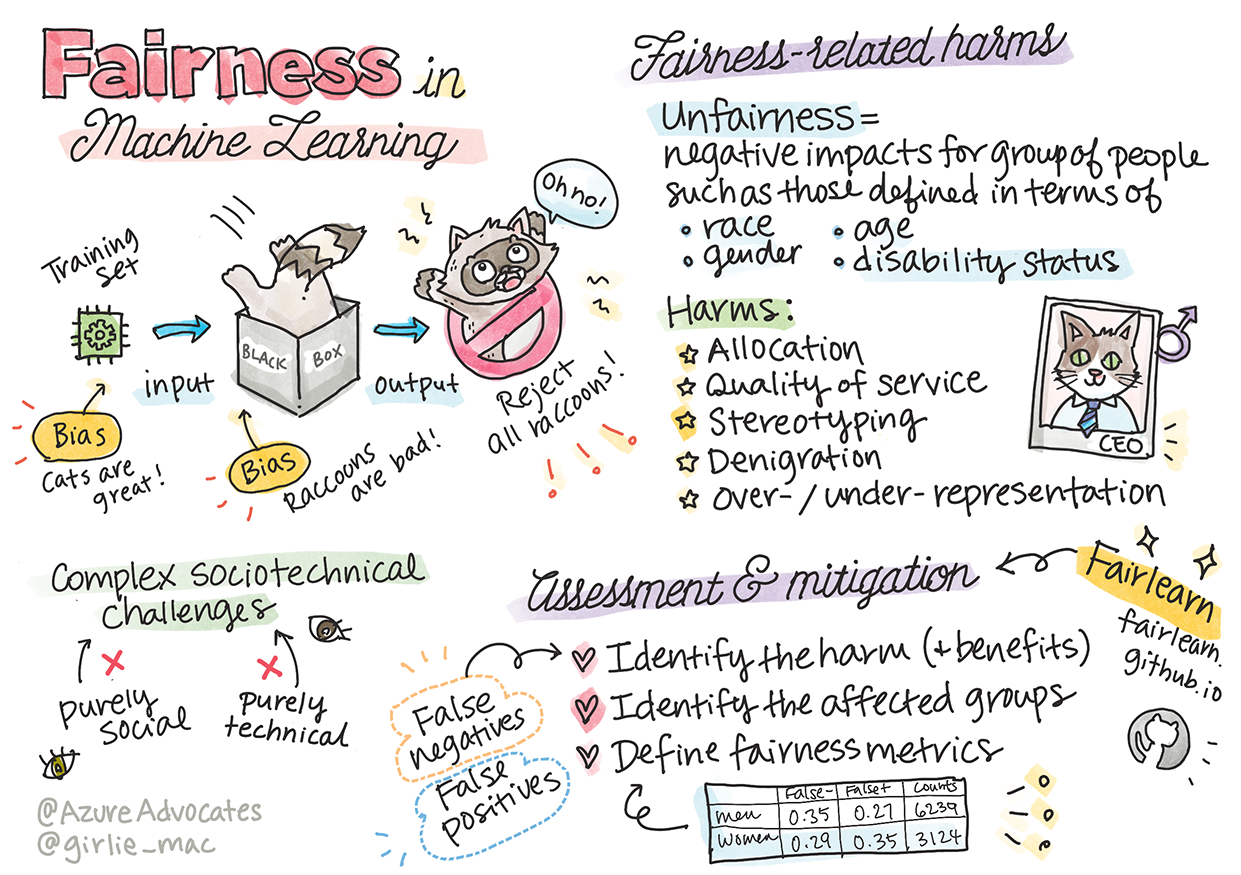

Скетчноут от Tomomi Imura

Тест перед лекцией

Введение

В этом курсе вы начнете узнавать, как машинное обучение влияет на нашу повседневную жизнь. Уже сейчас системы и модели участвуют в принятии решений в таких областях, как диагностика в здравоохранении, одобрение кредитов или выявление мошенничества. Поэтому важно, чтобы эти модели работали корректно и предоставляли надежные результаты. Как и любое программное приложение, системы ИИ могут не оправдывать ожидания или давать нежелательные результаты. Именно поэтому важно уметь понимать и объяснять поведение модели ИИ.

Представьте, что может произойти, если данные, которые вы используете для создания моделей, не включают определенные демографические группы, такие как раса, пол, политические взгляды, религия, или непропорционально представляют такие группы. А что, если вывод модели интерпретируется так, что он благоприятствует одной демографической группе? Каковы последствия для приложения? Кроме того, что происходит, если модель приводит к негативным результатам и наносит вред людям? Кто несет ответственность за поведение системы ИИ? Это лишь некоторые из вопросов, которые мы будем изучать в этом курсе.

В этом уроке вы:

- Узнаете о важности справедливости в машинном обучении и связанных с этим вредах.

- Ознакомитесь с практикой изучения выбросов и необычных сценариев для обеспечения надежности и безопасности.

- Поймете необходимость создания инклюзивных систем, которые дают возможность каждому.

- Исследуете важность защиты конфиденциальности и безопасности данных и людей.

- Увидите, насколько важно иметь прозрачный подход для объяснения поведения моделей ИИ.

- Осознаете, что ответственность является ключевым фактором для построения доверия к системам ИИ.

Предварительные знания

Перед началом курса рекомендуется пройти учебный путь "Принципы ответственного ИИ" и посмотреть видео на эту тему:

Узнайте больше о ответственном ИИ, следуя этому учебному пути

🎥 Нажмите на изображение выше, чтобы посмотреть видео: Подход Microsoft к ответственному ИИ

Справедливость

Системы ИИ должны относиться ко всем справедливо и избегать различного воздействия на схожие группы людей. Например, когда системы ИИ дают рекомендации по медицинскому лечению, заявкам на кредиты или трудоустройству, они должны делать одинаковые рекомендации для всех с похожими симптомами, финансовыми обстоятельствами или профессиональными квалификациями. Каждый из нас, как человек, носит в себе унаследованные предвзятости, которые влияют на наши решения и действия. Эти предвзятости могут проявляться в данных, которые мы используем для обучения систем ИИ. Такое влияние иногда происходит непреднамеренно. Часто трудно осознанно понять, когда вы вводите предвзятость в данные.

«Несправедливость» охватывает негативные последствия или «вред» для группы людей, таких как те, которые определяются по расе, полу, возрасту или статусу инвалидности. Основные виды вреда, связанные со справедливостью, можно классифицировать следующим образом:

- Распределение, если, например, один пол или этническая группа предпочитается другой.

- Качество обслуживания. Если данные обучены для одного конкретного сценария, но реальность гораздо сложнее, это приводит к плохой работе сервиса. Например, диспенсер для мыла, который не может распознать людей с темной кожей. Источник

- Очернение. Несправедливая критика или маркировка чего-либо или кого-либо. Например, технология распознавания изображений некорректно маркировала изображения темнокожих людей как горилл.

- Пере- или недопредставленность. Идея заключается в том, что определенная группа не представлена в определенной профессии, и любой сервис или функция, продолжающие это продвигать, способствуют вреду.

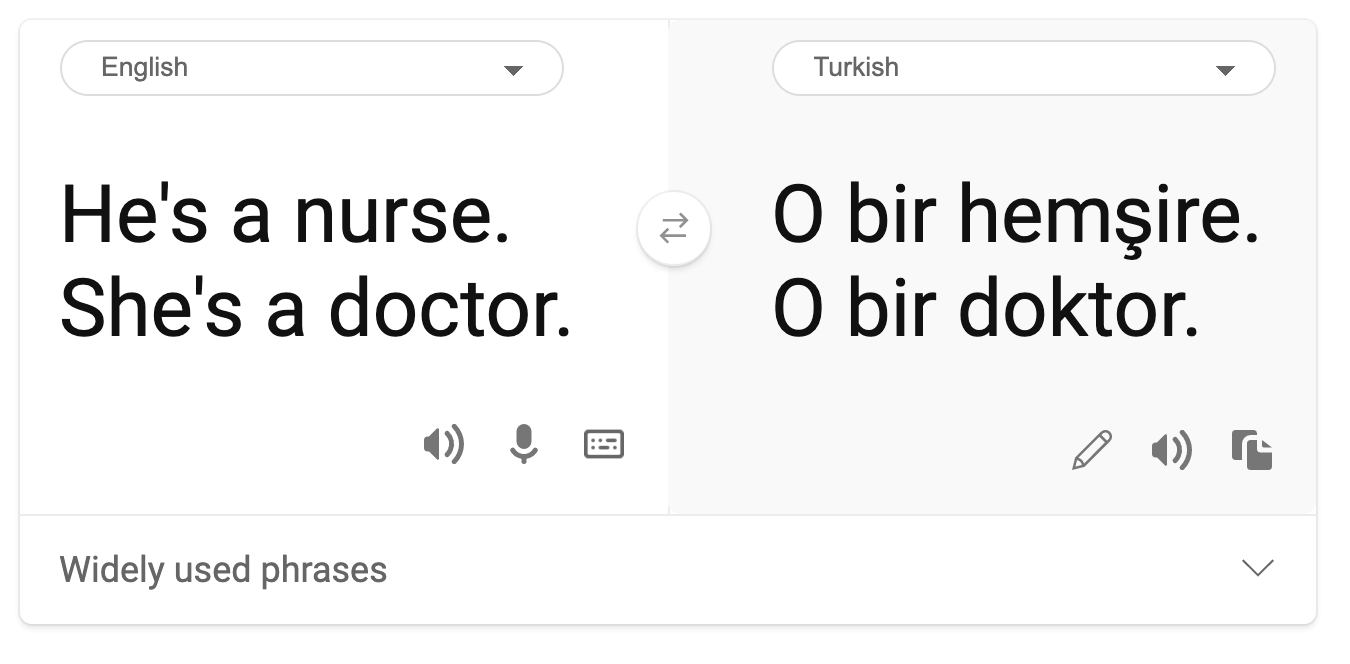

- Стереотипизация. Ассоциация определенной группы с заранее заданными атрибутами. Например, система перевода между английским и турецким может иметь неточности из-за слов, связанных со стереотипами о поле.

перевод на турецкий

перевод обратно на английский

При проектировании и тестировании систем ИИ мы должны гарантировать, что ИИ справедлив и не запрограммирован на принятие предвзятых или дискриминационных решений, которые также запрещены для людей. Обеспечение справедливости в ИИ и машинном обучении остается сложной социотехнической задачей.

Надежность и безопасность

Для построения доверия системы ИИ должны быть надежными, безопасными и стабильными как в обычных, так и в неожиданных условиях. Важно знать, как системы ИИ будут вести себя в различных ситуациях, особенно в случае выбросов. При создании решений ИИ необходимо уделять значительное внимание тому, как справляться с широким спектром обстоятельств, с которыми могут столкнуться решения ИИ. Например, самоуправляемый автомобиль должен ставить безопасность людей на первое место. Следовательно, ИИ, управляющий автомобилем, должен учитывать все возможные сценарии, с которыми автомобиль может столкнуться, такие как ночь, грозы или метели, дети, выбегающие на дорогу, домашние животные, дорожные работы и т.д. То, насколько хорошо система ИИ может справляться с широким спектром условий надежно и безопасно, отражает уровень подготовки, который разработчик данных или ИИ учел при проектировании или тестировании системы.

Инклюзивность

Системы ИИ должны быть разработаны так, чтобы вовлекать и давать возможность каждому. При проектировании и внедрении систем ИИ специалисты по данным и разработчики ИИ выявляют и устраняют потенциальные барьеры в системе, которые могут непреднамеренно исключать людей. Например, в мире насчитывается 1 миллиард людей с инвалидностью. С развитием ИИ они могут легче получать доступ к широкому спектру информации и возможностей в своей повседневной жизни. Устранение барьеров создает возможности для инноваций и разработки продуктов ИИ с лучшим пользовательским опытом, который приносит пользу всем.

Безопасность и конфиденциальность

Системы ИИ должны быть безопасными и уважать конфиденциальность людей. Люди меньше доверяют системам, которые ставят под угрозу их конфиденциальность, информацию или жизнь. При обучении моделей машинного обучения мы полагаемся на данные для получения наилучших результатов. При этом необходимо учитывать происхождение данных и их целостность. Например, были ли данные предоставлены пользователем или доступны публично? Далее, работая с данными, важно разрабатывать системы ИИ, которые могут защищать конфиденциальную информацию и противостоять атакам. По мере того, как ИИ становится более распространенным, защита конфиденциальности и обеспечение безопасности важной личной и бизнес-информации становятся все более критичными и сложными. Вопросы конфиденциальности и безопасности данных требуют особенно пристального внимания в ИИ, поскольку доступ к данным необходим для того, чтобы системы ИИ могли делать точные и информированные прогнозы и принимать решения о людях.

- В отрасли достигнуты значительные успехи в области конфиденциальности и безопасности, во многом благодаря таким регуляциям, как GDPR (Общий регламент по защите данных).

- Однако в системах ИИ мы должны признать напряжение между необходимостью получения большего объема персональных данных для повышения эффективности систем и конфиденциальностью.

- Как и с появлением подключенных компьютеров в интернете, мы также наблюдаем значительный рост числа проблем безопасности, связанных с ИИ.

- В то же время мы видим, как ИИ используется для улучшения безопасности. Например, большинство современных антивирусных сканеров работают на основе эвристики ИИ.

- Мы должны гарантировать, что наши процессы анализа данных гармонично сочетаются с последними практиками конфиденциальности и безопасности.

Прозрачность

Системы ИИ должны быть понятными. Важной частью прозрачности является объяснение поведения систем ИИ и их компонентов. Улучшение понимания систем ИИ требует, чтобы заинтересованные стороны понимали, как и почему они функционируют, чтобы можно было выявить потенциальные проблемы производительности, вопросы безопасности и конфиденциальности, предвзятости, исключительные практики или непреднамеренные результаты. Мы также считаем, что те, кто использует системы ИИ, должны быть честными и открытыми в отношении того, когда, почему и как они решают внедрять их. А также о ограничениях систем, которые они используют. Например, если банк использует систему ИИ для поддержки своих решений по потребительскому кредитованию, важно изучить результаты и понять, какие данные влияют на рекомендации системы. Правительства начинают регулировать ИИ в различных отраслях, поэтому специалисты по данным и организации должны объяснять, соответствует ли система ИИ нормативным требованиям, особенно если возникает нежелательный результат.

- Поскольку системы ИИ настолько сложны, трудно понять, как они работают и интерпретировать результаты.

- Это отсутствие понимания влияет на то, как эти системы управляются, внедряются и документируются.

- Более важно, это отсутствие понимания влияет на решения, принимаемые на основе результатов, которые производят эти системы.

Ответственность

Люди, которые проектируют и внедряют системы ИИ, должны нести ответственность за то, как их системы работают. Необходимость ответственности особенно важна для технологий чувствительного использования, таких как распознавание лиц. В последнее время растет спрос на технологии распознавания лиц, особенно со стороны правоохранительных органов, которые видят потенциал технологии в таких применениях, как поиск пропавших детей. Однако эти технологии могут быть использованы правительством для того, чтобы поставить под угрозу основные свободы граждан, например, путем постоянного наблюдения за конкретными людьми. Поэтому специалисты по данным и организации должны быть ответственными за то, как их система ИИ влияет на отдельных людей или общество.

🎥 Нажмите на изображение выше, чтобы посмотреть видео: Предупреждения о массовом наблюдении через распознавание лиц

В конечном итоге один из самых больших вопросов для нашего поколения, как первого поколения, которое внедряет ИИ в общество, заключается в том, как гарантировать, что компьютеры останутся подотчетными людям, и как гарантировать, что люди, которые проектируют компьютеры, останутся подотчетными всем остальным.

Оценка воздействия

Перед обучением модели машинного обучения важно провести оценку воздействия, чтобы понять цель системы ИИ, предполагаемое использование, место внедрения и кто будет взаимодействовать с системой. Это полезно для рецензентов или тестировщиков, оценивающих систему, чтобы знать, какие факторы учитывать при выявлении потенциальных рисков и ожидаемых последствий.

Следующие области являются ключевыми при проведении оценки воздействия:

- Негативное воздействие на отдельных людей. Осознание любых ограничений или требований, неподдерживаемого использования или известных ограничений, препятствующих работе системы, важно для того, чтобы система не использовалась таким образом, который может нанести вред людям.

- Требования к данным. Понимание того, как и где система будет использовать данные, позволяет рецензентам изучить любые требования к данным, которые необходимо учитывать (например, регуляции GDPR или HIPPA). Кроме того, необходимо проверить, является ли источник или объем данных достаточным для обучения.

- Сводка воздействия. Составьте список потенциальных вредов, которые могут возникнуть при использовании системы. На протяжении всего жизненного цикла ML проверяйте, устранены ли выявленные проблемы.

- Применимые цели для каждого из шести основных принципов. Оцените, достигнуты ли цели каждого из принципов и есть ли какие-либо пробелы.

Отладка с ответственным ИИ

Как и отладка программного приложения, отладка системы ИИ — это необходимый процесс выявления и устранения проблем в системе. Существует множество факторов, которые могут повлиять на то, что модель не работает так, как ожидалось или ответственно. Большинство традиционных метрик производительности модели являются количественными агрегатами производительности модели, которые недостаточны для анализа того, как модель нарушает принципы ответственного ИИ. Более того, модель машинного обучения — это черный ящик, который затрудняет понимание того, что влияет на ее результаты, или предоставление объяснений, когда она допускает ошибку. Позже в этом курсе мы узнаем, как использовать панель управления ответственного ИИ для отладки систем ИИ. Панель управления предоставляет комплексный инструмент для специалистов по данным и разработчиков ИИ для выполнения:

- Анализа ошибок. Для выявления распределения ошибок модели, которые могут повлиять на справедливость или надежность системы.

- Обзора модели. Для обнаружения различий в производительности модели в различных когорт данных.

- Анализа данных. Для понимания распределения данных и выявления потенциальной предвзятости в данных, которая может привести к проблемам справедливости, инклюзивности и надежности.

- Интерпретации модели. Для понимания того, что влияет или влияет на прогнозы модели. Это помогает объяснить поведение модели, что важно для прозрачности и ответственности.

🚀 Задание

Чтобы предотвратить возникновение вреда с самого начала, мы должны:

- обеспечить разнообразие опыта и точек зрения среди людей, работающих над системами

- инвестировать в наборы данных, которые отражают разнообразие нашего общества

- разработать лучшие методы на протяжении всего жизненного цикла машинного обучения для выявления и исправления проблем ответственного ИИ, когда они возникают

Подумайте о реальных сценариях, где недоверие к модели очевидно в процессе создания и использования модели. Что еще следует учитывать?

Тест после лекции

Обзор и самостоятельное изучение

В этом уроке вы узнали основы концепций справедливости и несправедливости в машинном обучении. Посмотрите этот воркшоп, чтобы глубже изучить темы:

- В поисках ответственного ИИ: Применение принципов на практике, авторы Бесмира Нуши, Мехрнуш Самеки и Амит Шарма

🎥 Нажмите на изображение выше, чтобы посмотреть видео: RAI Toolbox: Открытая платформа для создания ответственного ИИ, авторы Бесмира Нуши, Мехрнуш Самеки и Амит Шарма

Также прочитайте:

-

Центр ресурсов Microsoft по ответственному ИИ: Responsible AI Resources – Microsoft AI

-

Исследовательская группа Microsoft FATE: FATE: Справедливость, Подотчетность, Прозрачность и Этика в ИИ - Microsoft Research

RAI Toolbox:

Узнайте о инструментах Azure Machine Learning для обеспечения справедливости:

Задание

Отказ от ответственности:

Этот документ был переведен с помощью сервиса автоматического перевода Co-op Translator. Несмотря на наши усилия обеспечить точность, автоматические переводы могут содержать ошибки или неточности. Оригинальный документ на его родном языке следует считать авторитетным источником. Для получения критически важной информации рекомендуется профессиональный перевод человеком. Мы не несем ответственности за любые недоразумения или неправильные интерпретации, возникающие в результате использования данного перевода.