|

|

2 weeks ago | |

|---|---|---|

| .. | ||

| solution | 3 weeks ago | |

| README.md | 2 weeks ago | |

| assignment.md | 3 weeks ago | |

| notebook.ipynb | 3 weeks ago | |

README.md

مقدمة إلى التصنيف

في هذه الدروس الأربعة، ستستكشف أحد الجوانب الأساسية لتعلم الآلة الكلاسيكي - التصنيف. سنقوم باستخدام مجموعة متنوعة من خوارزميات التصنيف مع مجموعة بيانات عن جميع المأكولات الرائعة في آسيا والهند. نأمل أن تكون جائعًا!

احتفل بالمأكولات الآسيوية في هذه الدروس! الصورة بواسطة Jen Looper

التصنيف هو شكل من أشكال التعلم الموجّه الذي يشترك كثيرًا مع تقنيات الانحدار. إذا كان تعلم الآلة يدور حول التنبؤ بالقيم أو الأسماء باستخدام مجموعات البيانات، فإن التصنيف ينقسم عمومًا إلى مجموعتين: التصنيف الثنائي و التصنيف متعدد الفئات.

🎥 انقر على الصورة أعلاه لمشاهدة الفيديو: يقدم جون غوتاج من MIT التصنيف

تذكر:

- الانحدار الخطي ساعدك في التنبؤ بالعلاقات بين المتغيرات وإجراء توقعات دقيقة حول مكان وقوع نقطة بيانات جديدة بالنسبة لذلك الخط. على سبيل المثال، يمكنك التنبؤ بسعر اليقطين في سبتمبر مقابل ديسمبر.

- الانحدار اللوجستي ساعدك في اكتشاف "الفئات الثنائية": عند نقطة السعر هذه، هل هذا اليقطين برتقالي أم غير برتقالي؟

يستخدم التصنيف خوارزميات مختلفة لتحديد طرق أخرى لتحديد تسمية أو فئة نقطة البيانات. دعونا نعمل مع بيانات المأكولات لنرى ما إذا كان بإمكاننا، من خلال مراقبة مجموعة من المكونات، تحديد أصل المأكولات.

اختبار ما قبل المحاضرة

هذا الدرس متاح بلغة R!

مقدمة

التصنيف هو أحد الأنشطة الأساسية للباحثين في تعلم الآلة وعلماء البيانات. من التصنيف الأساسي لقيمة ثنائية ("هل هذا البريد الإلكتروني مزعج أم لا؟") إلى التصنيف المعقد للصور وتقسيمها باستخدام رؤية الكمبيوتر، من المفيد دائمًا أن تكون قادرًا على تصنيف البيانات إلى فئات وطرح الأسئلة عليها.

لصياغة العملية بطريقة أكثر علمية، فإن طريقة التصنيف الخاصة بك تنشئ نموذجًا تنبؤيًا يمكّنك من رسم العلاقة بين المتغيرات المدخلة والمتغيرات الناتجة.

مشاكل التصنيف الثنائي مقابل متعدد الفئات التي تتعامل معها خوارزميات التصنيف. الرسم البياني بواسطة Jen Looper

قبل البدء في عملية تنظيف بياناتنا، تصورها، وتجهيزها لمهام تعلم الآلة، دعونا نتعلم قليلاً عن الطرق المختلفة التي يمكن من خلالها استخدام تعلم الآلة لتصنيف البيانات.

مستمدة من الإحصائيات، يستخدم التصنيف باستخدام تعلم الآلة الكلاسيكي ميزات مثل smoker، weight، و age لتحديد احتمالية الإصابة بمرض معين. كطريقة تعلم موجّهة مشابهة لتمارين الانحدار التي أجريتها سابقًا، يتم تصنيف بياناتك وتستخدم خوارزميات تعلم الآلة هذه التصنيفات لتصنيف وتوقع الفئات (أو "الميزات") لمجموعة البيانات وتعيينها إلى مجموعة أو نتيجة.

✅ خذ لحظة لتخيل مجموعة بيانات عن المأكولات. ما الذي يمكن لنموذج متعدد الفئات الإجابة عليه؟ وما الذي يمكن لنموذج ثنائي الإجابة عليه؟ ماذا لو أردت تحديد ما إذا كانت مأكولات معينة من المحتمل أن تستخدم الحلبة؟ ماذا لو أردت معرفة ما إذا كان بإمكانك، بالنظر إلى حقيبة بقالة مليئة باليانسون النجمي، الخرشوف، القرنبيط، والفجل، إعداد طبق هندي نموذجي؟

🎥 انقر على الصورة أعلاه لمشاهدة الفيديو. الفكرة الأساسية لبرنامج 'Chopped' هي "السلة الغامضة" حيث يتعين على الطهاة إعداد طبق من اختيار عشوائي من المكونات. بالتأكيد كان نموذج تعلم الآلة سيساعد!

مرحبًا بـ 'المصنف'

السؤال الذي نريد طرحه على مجموعة بيانات المأكولات هو في الواقع سؤال متعدد الفئات، حيث لدينا العديد من المأكولات الوطنية المحتملة للعمل معها. بالنظر إلى مجموعة من المكونات، أي من هذه الفئات العديدة ستتناسب معها البيانات؟

يوفر Scikit-learn العديد من الخوارزميات المختلفة لاستخدامها لتصنيف البيانات، اعتمادًا على نوع المشكلة التي تريد حلها. في الدروس التالية، ستتعلم عن العديد من هذه الخوارزميات.

تمرين - تنظيف وتوازن البيانات

المهمة الأولى التي يجب القيام بها، قبل بدء هذا المشروع، هي تنظيف وتوازن البيانات للحصول على نتائج أفضل. ابدأ بملف notebook.ipynb الفارغ الموجود في جذر هذا المجلد.

أول شيء يجب تثبيته هو imblearn. هذه حزمة Scikit-learn ستتيح لك تحقيق توازن أفضل للبيانات (ستتعلم المزيد عن هذه المهمة قريبًا).

-

لتثبيت

imblearn، قم بتشغيلpip install، كما يلي:pip install imblearn -

قم باستيراد الحزم التي تحتاجها لاستيراد بياناتك وتصورها، واستيراد

SMOTEمنimblearn.import pandas as pd import matplotlib.pyplot as plt import matplotlib as mpl import numpy as np from imblearn.over_sampling import SMOTEالآن أصبحت جاهزًا لاستيراد البيانات.

-

المهمة التالية ستكون استيراد البيانات:

df = pd.read_csv('../data/cuisines.csv')استخدام

read_csv()سيقرأ محتوى ملف csv cusines.csv ويضعه في المتغيرdf. -

تحقق من شكل البيانات:

df.head()تبدو الصفوف الخمسة الأولى كما يلي:

| | Unnamed: 0 | cuisine | almond | angelica | anise | anise_seed | apple | apple_brandy | apricot | armagnac | ... | whiskey | white_bread | white_wine | whole_grain_wheat_flour | wine | wood | yam | yeast | yogurt | zucchini | | --- | ---------- | ------- | ------ | -------- | ----- | ---------- | ----- | ------------ | ------- | -------- | --- | ------- | ----------- | ---------- | ----------------------- | ---- | ---- | --- | ----- | ------ | -------- | | 0 | 65 | indian | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | ... | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | | 1 | 66 | indian | 1 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | ... | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | | 2 | 67 | indian | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | ... | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | | 3 | 68 | indian | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | ... | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | | 4 | 69 | indian | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | ... | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 1 | 0 | -

احصل على معلومات حول هذه البيانات عن طريق استدعاء

info():df.info()يشبه الناتج:

<class 'pandas.core.frame.DataFrame'> RangeIndex: 2448 entries, 0 to 2447 Columns: 385 entries, Unnamed: 0 to zucchini dtypes: int64(384), object(1) memory usage: 7.2+ MB

تمرين - التعرف على المأكولات

الآن يبدأ العمل ليصبح أكثر إثارة. دعونا نكتشف توزيع البيانات لكل نوع من المأكولات.

-

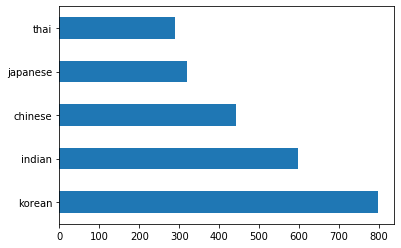

قم برسم البيانات كأشرطة باستخدام

barh():df.cuisine.value_counts().plot.barh()هناك عدد محدود من المأكولات، لكن توزيع البيانات غير متساوٍ. يمكنك إصلاح ذلك! قبل القيام بذلك، استكشف قليلاً.

-

اكتشف مقدار البيانات المتاحة لكل نوع من المأكولات واطبعها:

thai_df = df[(df.cuisine == "thai")] japanese_df = df[(df.cuisine == "japanese")] chinese_df = df[(df.cuisine == "chinese")] indian_df = df[(df.cuisine == "indian")] korean_df = df[(df.cuisine == "korean")] print(f'thai df: {thai_df.shape}') print(f'japanese df: {japanese_df.shape}') print(f'chinese df: {chinese_df.shape}') print(f'indian df: {indian_df.shape}') print(f'korean df: {korean_df.shape}')يبدو الناتج كما يلي:

thai df: (289, 385) japanese df: (320, 385) chinese df: (442, 385) indian df: (598, 385) korean df: (799, 385)

اكتشاف المكونات

الآن يمكنك التعمق أكثر في البيانات ومعرفة ما هي المكونات النموذجية لكل نوع من المأكولات. يجب تنظيف البيانات المتكررة التي تسبب ارتباكًا بين المأكولات، لذا دعونا نتعلم عن هذه المشكلة.

-

قم بإنشاء وظيفة

create_ingredient()في Python لإنشاء إطار بيانات للمكونات. ستبدأ هذه الوظيفة بإسقاط عمود غير مفيد وفرز المكونات حسب عددها:def create_ingredient_df(df): ingredient_df = df.T.drop(['cuisine','Unnamed: 0']).sum(axis=1).to_frame('value') ingredient_df = ingredient_df[(ingredient_df.T != 0).any()] ingredient_df = ingredient_df.sort_values(by='value', ascending=False, inplace=False) return ingredient_dfالآن يمكنك استخدام هذه الوظيفة للحصول على فكرة عن أكثر عشرة مكونات شيوعًا لكل نوع من المأكولات.

-

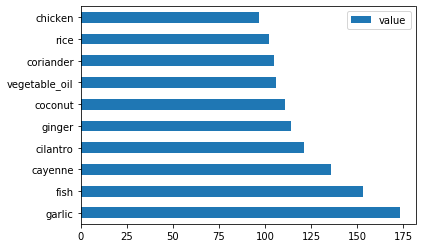

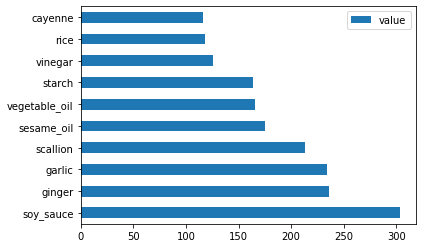

قم باستدعاء

create_ingredient()وقم برسمها باستخدامbarh():thai_ingredient_df = create_ingredient_df(thai_df) thai_ingredient_df.head(10).plot.barh() -

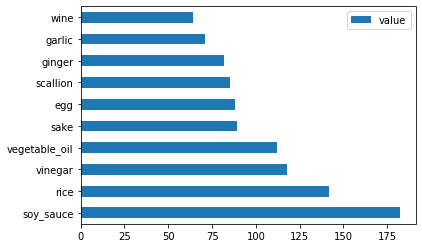

قم بنفس الشيء لبيانات المأكولات اليابانية:

japanese_ingredient_df = create_ingredient_df(japanese_df) japanese_ingredient_df.head(10).plot.barh() -

الآن بالنسبة لمكونات المأكولات الصينية:

chinese_ingredient_df = create_ingredient_df(chinese_df) chinese_ingredient_df.head(10).plot.barh() -

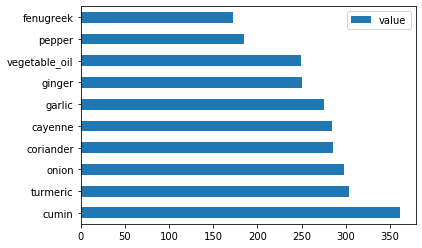

قم برسم مكونات المأكولات الهندية:

indian_ingredient_df = create_ingredient_df(indian_df) indian_ingredient_df.head(10).plot.barh() -

أخيرًا، قم برسم مكونات المأكولات الكورية:

korean_ingredient_df = create_ingredient_df(korean_df) korean_ingredient_df.head(10).plot.barh() -

الآن، قم بإسقاط المكونات الأكثر شيوعًا التي تسبب ارتباكًا بين المأكولات المختلفة، باستخدام

drop():الجميع يحب الأرز، الثوم، والزنجبيل!

feature_df= df.drop(['cuisine','Unnamed: 0','rice','garlic','ginger'], axis=1) labels_df = df.cuisine #.unique() feature_df.head()

توازن مجموعة البيانات

الآن بعد أن قمت بتنظيف البيانات، استخدم SMOTE - "تقنية الإفراط في أخذ العينات للأقلية الاصطناعية" - لتحقيق التوازن.

-

قم باستدعاء

fit_resample()، هذه الاستراتيجية تولد عينات جديدة عن طريق الاستيفاء.oversample = SMOTE() transformed_feature_df, transformed_label_df = oversample.fit_resample(feature_df, labels_df)من خلال تحقيق التوازن في بياناتك، ستحصل على نتائج أفضل عند تصنيفها. فكر في التصنيف الثنائي. إذا كانت معظم بياناتك تنتمي إلى فئة واحدة، فإن نموذج تعلم الآلة سيتنبأ بتلك الفئة بشكل أكثر تكرارًا، فقط لأن هناك المزيد من البيانات لها. تحقيق التوازن في البيانات يزيل أي انحراف ويساعد في حل هذه المشكلة.

-

الآن يمكنك التحقق من أعداد التصنيفات لكل مكون:

print(f'new label count: {transformed_label_df.value_counts()}') print(f'old label count: {df.cuisine.value_counts()}')يبدو الناتج كما يلي:

new label count: korean 799 chinese 799 indian 799 japanese 799 thai 799 Name: cuisine, dtype: int64 old label count: korean 799 indian 598 chinese 442 japanese 320 thai 289 Name: cuisine, dtype: int64البيانات نظيفة ومتوازنة ولذيذة جدًا!

-

الخطوة الأخيرة هي حفظ بياناتك المتوازنة، بما في ذلك التصنيفات والميزات، في إطار بيانات جديد يمكن تصديره إلى ملف:

transformed_df = pd.concat([transformed_label_df,transformed_feature_df],axis=1, join='outer') -

يمكنك إلقاء نظرة أخيرة على البيانات باستخدام

transformed_df.head()وtransformed_df.info(). احفظ نسخة من هذه البيانات لاستخدامها في الدروس المستقبلية:transformed_df.head() transformed_df.info() transformed_df.to_csv("../data/cleaned_cuisines.csv")يمكن الآن العثور على ملف CSV الجديد في مجلد البيانات الجذر.

🚀تحدي

تحتوي هذه المناهج على العديد من مجموعات البيانات المثيرة للاهتمام. ابحث في مجلدات data لترى ما إذا كانت تحتوي على مجموعات بيانات مناسبة للتصنيف الثنائي أو متعدد الفئات؟ ما الأسئلة التي ستطرحها على هذه المجموعة؟

اختبار ما بعد المحاضرة

المراجعة والدراسة الذاتية

استكشف واجهة برمجة تطبيقات SMOTE. ما هي حالات الاستخدام التي تناسبها؟ ما المشاكل التي تحلها؟

الواجب

إخلاء المسؤولية:

تمت ترجمة هذا المستند باستخدام خدمة الترجمة الآلية Co-op Translator. بينما نسعى لتحقيق الدقة، يرجى العلم أن الترجمات الآلية قد تحتوي على أخطاء أو معلومات غير دقيقة. يجب اعتبار المستند الأصلي بلغته الأصلية هو المصدر الموثوق. للحصول على معلومات حساسة أو هامة، يُوصى بالاستعانة بترجمة بشرية احترافية. نحن غير مسؤولين عن أي سوء فهم أو تفسيرات خاطئة تنشأ عن استخدام هذه الترجمة.