|

|

7 months ago | |

|---|---|---|

| .. | ||

| README.md | 7 months ago | |

| assignment.md | 7 months ago | |

README.md

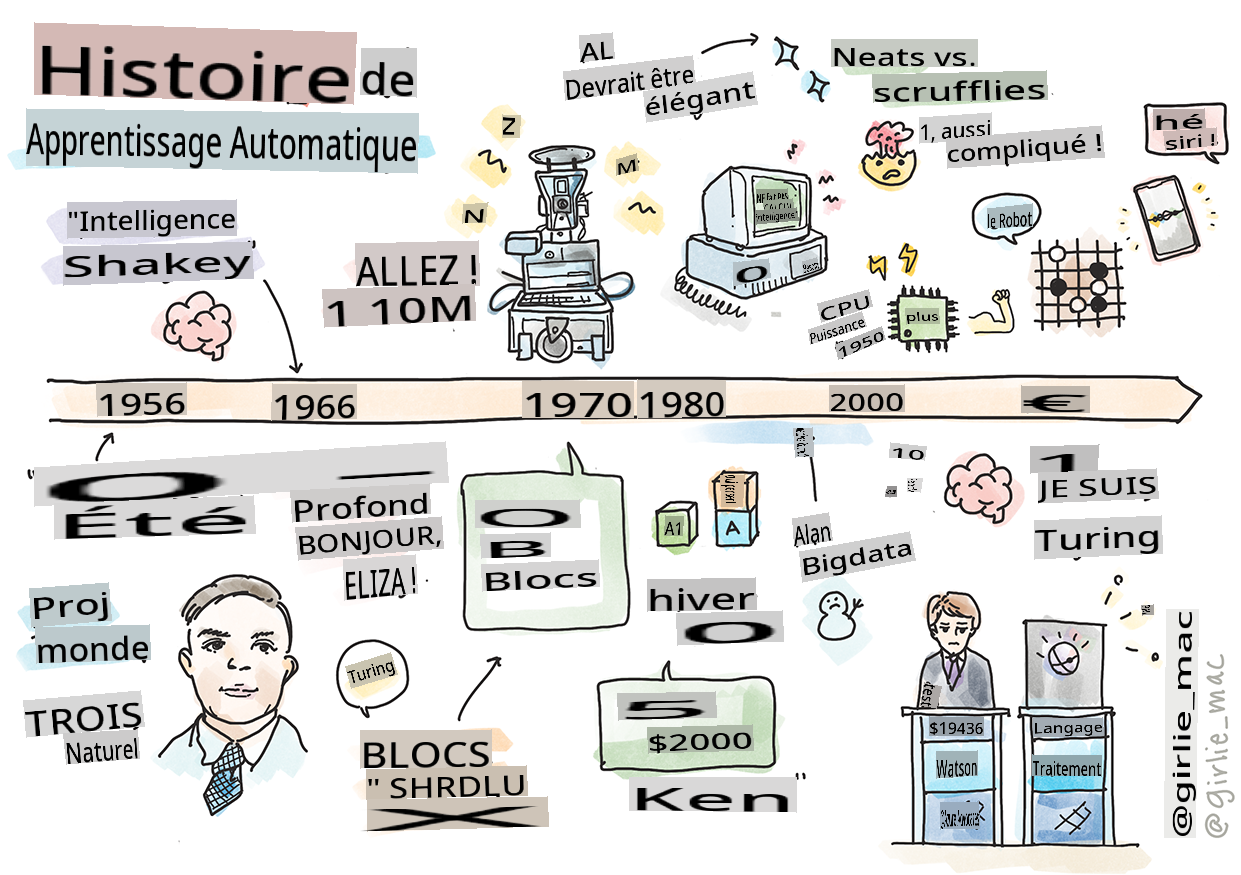

Histoire de l'apprentissage automatique

Sketchnote par Tomomi Imura

Quiz avant le cours

🎥 Cliquez sur l'image ci-dessus pour une courte vidéo qui accompagne cette leçon.

Dans cette leçon, nous allons passer en revue les principales étapes de l'histoire de l'apprentissage automatique et de l'intelligence artificielle.

L'histoire de l'intelligence artificielle (IA) en tant que domaine est étroitement liée à l'histoire de l'apprentissage automatique, car les algorithmes et les avancées computationnelles qui sous-tendent l'apprentissage automatique ont contribué au développement de l'IA. Il est utile de se rappeler que, bien que ces domaines aient commencé à se cristalliser dans les années 1950, d'importantes découvertes algorithmiques, statistiques, mathématiques, computationnelles et techniques ont précédé et chevauché cette époque. En fait, les gens réfléchissent à ces questions depuis des centaines d'années : cet article discute des bases intellectuelles historiques de l'idée d'une 'machine pensante'.

Découvertes notables

- 1763, 1812 Théorème de Bayes et ses prédécesseurs. Ce théorème et ses applications sous-tendent l'inférence, décrivant la probabilité qu'un événement se produise en fonction des connaissances antérieures.

- 1805 Théorie des moindres carrés par le mathématicien français Adrien-Marie Legendre. Cette théorie, que vous découvrirez dans notre unité de Régression, aide à l'ajustement des données.

- 1913 Chaînes de Markov, nommées d'après le mathématicien russe Andrey Markov, sont utilisées pour décrire une séquence d'événements possibles basée sur un état précédent.

- 1957 Perceptron est un type de classificateur linéaire inventé par le psychologue américain Frank Rosenblatt qui sous-tend les avancées en apprentissage profond.

- 1967 Voisin le plus proche est un algorithme initialement conçu pour cartographier des itinéraires. Dans un contexte d'apprentissage automatique, il est utilisé pour détecter des motifs.

- 1970 Rétropropagation est utilisée pour entraîner des réseaux de neurones à propagation avant.

- 1982 Réseaux de neurones récurrents sont des réseaux de neurones artificiels dérivés de réseaux de neurones à propagation avant qui créent des graphes temporels.

✅ Faites un peu de recherche. Quelles autres dates se démarquent comme étant décisives dans l'histoire de l'apprentissage automatique et de l'IA ?

1950 : Machines qui pensent

Alan Turing, une personne vraiment remarquable qui a été votée par le public en 2019 comme le plus grand scientifique du 20e siècle, est crédité d'avoir aidé à poser les bases du concept de 'machine capable de penser.' Il a dû faire face à des sceptiques et à son propre besoin de preuves empiriques de ce concept en partie en créant le Test de Turing, que vous explorerez dans nos leçons de NLP.

1956 : Projet de recherche d'été de Dartmouth

"Le projet de recherche d'été de Dartmouth sur l'intelligence artificielle a été un événement marquant pour l'intelligence artificielle en tant que domaine," et c'est ici que le terme 'intelligence artificielle' a été inventé (source).

Chaque aspect de l'apprentissage ou toute autre caractéristique de l'intelligence peut en principe être décrit de manière si précise qu'une machine peut être faite pour le simuler.

Le chercheur principal, le professeur de mathématiques John McCarthy, espérait "progresser sur la base de la conjecture selon laquelle chaque aspect de l'apprentissage ou toute autre caractéristique de l'intelligence peut en principe être décrit de manière si précise qu'une machine peut être faite pour le simuler." Les participants comprenaient un autre luminaire du domaine, Marvin Minsky.

L'atelier est crédité d'avoir initié et encouragé plusieurs discussions, y compris "l'essor des méthodes symboliques, des systèmes axés sur des domaines limités (les premiers systèmes experts), et des systèmes déductifs par rapport aux systèmes inductifs." (source).

1956 - 1974 : "Les années d'or"

Des années 1950 au milieu des années 70, l'optimisme était fort dans l'espoir que l'IA pourrait résoudre de nombreux problèmes. En 1967, Marvin Minsky a déclaré avec confiance que "Dans une génération ... le problème de la création de 'l'intelligence artificielle' sera substantiellement résolu." (Minsky, Marvin (1967), Computation: Finite and Infinite Machines, Englewood Cliffs, N.J.: Prentice-Hall)

La recherche en traitement du langage naturel a prospéré, la recherche a été affinée et rendue plus puissante, et le concept de 'micro-mondes' a été créé, où des tâches simples étaient accomplies à l'aide d'instructions en langage clair.

La recherche était bien financée par des agences gouvernementales, des avancées ont été réalisées dans la computation et les algorithmes, et des prototypes de machines intelligentes ont été construits. Certaines de ces machines comprennent :

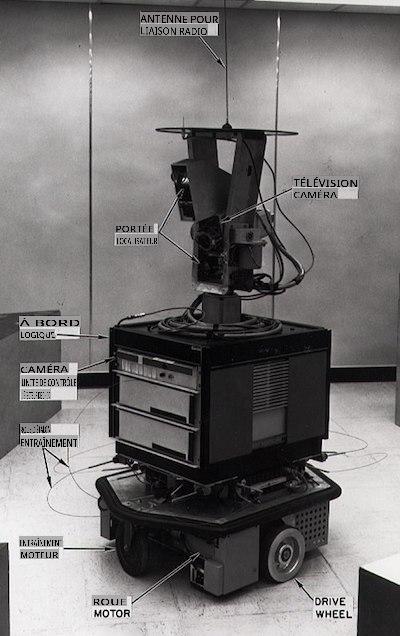

-

Shakey le robot, qui pouvait manœuvrer et décider comment accomplir des tâches 'intelligemment'.

Shakey en 1972

-

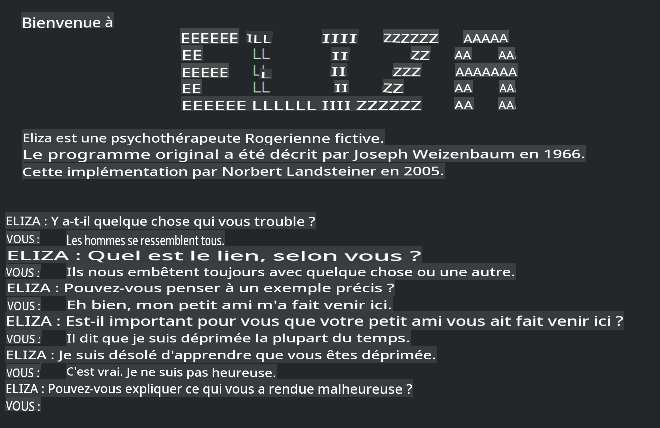

Eliza, un 'chatterbot' précoce, pouvait converser avec des gens et agir comme un 'thérapeute' primitif. Vous en apprendrez davantage sur Eliza dans les leçons de NLP.

Une version d'Eliza, un chatbot

-

"Le monde des blocs" était un exemple d'un micro-monde où des blocs pouvaient être empilés et triés, et des expériences sur l'enseignement aux machines de prendre des décisions pouvaient être testées. Des avancées réalisées avec des bibliothèques telles que SHRDLU ont contribué à faire progresser le traitement du langage.

🎥 Cliquez sur l'image ci-dessus pour une vidéo : Monde des blocs avec SHRDLU

1974 - 1980 : "L'hiver de l'IA"

Au milieu des années 1970, il était devenu évident que la complexité de la création de 'machines intelligentes' avait été sous-estimée et que sa promesse, compte tenu de la puissance de calcul disponible, avait été exagérée. Le financement a diminué et la confiance dans le domaine a ralenti. Certains problèmes qui ont impacté la confiance incluent :

- Limitations. La puissance de calcul était trop limitée.

- Explosion combinatoire. Le nombre de paramètres à entraîner a augmenté de manière exponentielle à mesure que l'on demandait davantage aux ordinateurs, sans évolution parallèle de la puissance et des capacités de calcul.

- Pénurie de données. Il y avait une pénurie de données qui entravait le processus de test, de développement et de perfectionnement des algorithmes.

- Posons-nous les bonnes questions ?. Les questions mêmes qui étaient posées ont commencé à être remises en question. Les chercheurs ont commencé à faire face à des critiques concernant leurs approches :

- Les tests de Turing ont été remis en question par des moyens, parmi d'autres idées, de la 'théorie de la chambre chinoise' qui postulait que "programmer un ordinateur numérique peut donner l'apparence de comprendre le langage mais ne peut produire une réelle compréhension." (source)

- L'éthique de l'introduction d'intelligences artificielles telles que le "thérapeute" ELIZA dans la société a été contestée.

En même temps, diverses écoles de pensée en IA ont commencé à se former. Une dichotomie a été établie entre les pratiques de l'IA "en désordre" vs. "propre". Les laboratoires en désordre ajustaient les programmes pendant des heures jusqu'à obtenir les résultats souhaités. Les laboratoires propres "se concentraient sur la logique et la résolution formelle de problèmes". ELIZA et SHRDLU étaient des systèmes en désordre bien connus. Dans les années 1980, alors que la demande émergeait pour rendre les systèmes d'apprentissage automatique reproductibles, l'approche propre a progressivement pris le devant de la scène, car ses résultats sont plus explicables.

Systèmes experts des années 1980

À mesure que le domaine grandissait, son utilité pour les entreprises devenait plus claire, et dans les années 1980, la prolifération des 'systèmes experts' a également eu lieu. "Les systèmes experts étaient parmi les premières formes véritablement réussies de logiciels d'intelligence artificielle (IA)." (source).

Ce type de système est en réalité hybride, consistant partiellement en un moteur de règles définissant les exigences commerciales, et un moteur d'inférence qui exploitait le système de règles pour déduire de nouveaux faits.

Cette époque a également vu une attention croissante portée aux réseaux de neurones.

1987 - 1993 : "Refroidissement de l'IA"

La prolifération de matériel spécialisé pour les systèmes experts a eu l'effet malheureux de devenir trop spécialisé. L'essor des ordinateurs personnels a également concurrencé ces grands systèmes centralisés et spécialisés. La démocratisation de l'informatique avait commencé, et cela a finalement ouvert la voie à l'explosion moderne des big data.

1993 - 2011

Cette époque a vu une nouvelle ère pour l'apprentissage automatique et l'IA, capables de résoudre certains des problèmes causés plus tôt par le manque de données et de puissance de calcul. La quantité de données a commencé à augmenter rapidement et à devenir plus largement disponible, pour le meilleur et pour le pire, surtout avec l'avènement du smartphone autour de 2007. La puissance de calcul a augmenté de manière exponentielle, et les algorithmes ont évolué en parallèle. Le domaine a commencé à gagner en maturité alors que les jours désinvoltes du passé commençaient à se cristalliser en une véritable discipline.

Maintenant

Aujourd'hui, l'apprentissage automatique et l'IA touchent presque tous les aspects de nos vies. Cette époque appelle à une compréhension attentive des risques et des effets potentiels de ces algorithmes sur la vie humaine. Comme l'a déclaré Brad Smith de Microsoft, "La technologie de l'information soulève des questions qui touchent au cœur des protections fondamentales des droits de l'homme, comme la vie privée et la liberté d'expression. Ces questions accroissent la responsabilité des entreprises technologiques qui créent ces produits. À notre avis, elles appellent également à une réglementation gouvernementale réfléchie et au développement de normes autour des usages acceptables" (source).

Il reste à voir ce que l'avenir nous réserve, mais il est important de comprendre ces systèmes informatiques et les logiciels et algorithmes qu'ils exécutent. Nous espérons que ce programme vous aidera à acquérir une meilleure compréhension afin que vous puissiez décider par vous-même.

🎥 Cliquez sur l'image ci-dessus pour une vidéo : Yann LeCun discute de l'histoire de l'apprentissage profond dans cette conférence

🚀Défi

Explorez l'un de ces moments historiques et apprenez-en davantage sur les personnes qui les ont marqués. Il y a des personnages fascinants, et aucune découverte scientifique n'a jamais été réalisée dans un vide culturel. Qu'est-ce que vous découvrez ?

Quiz après le cours

Revue & Auto-apprentissage

Voici des éléments à regarder et à écouter :

Ce podcast où Amy Boyd discute de l'évolution de l'IA

Tâche

Avertissement :

Ce document a été traduit à l'aide de services de traduction automatique basés sur l'IA. Bien que nous nous efforçons d'assurer l'exactitude, veuillez noter que les traductions automatiques peuvent contenir des erreurs ou des inexactitudes. Le document original dans sa langue natale doit être considéré comme la source faisant autorité. Pour des informations critiques, une traduction professionnelle par un humain est recommandée. Nous ne sommes pas responsables des malentendus ou des interprétations erronées résultant de l'utilisation de cette traduction.